SK hynix presentó sus tecnologías y soluciones de semiconductores de memoria de próxima generación en el OCP Global Summit 2023, que se celebró en San José, California, del 17 al 19 de octubre.

El OCP Global Summit se trata de un evento anual organizado por la comunidad tecnologíca de centros de datos más grande del mundo, el Open Compute Project (OCP), donde los expertos de la industria se reúnen para compartir diversas tecnologías y visiones. Este año, SK hynix y su filial Solidigm mostraron productos avanzados de memoria semiconductora que liderarán la era de la inteligencia artificial bajo el lema “Unidos por la tecnología”.

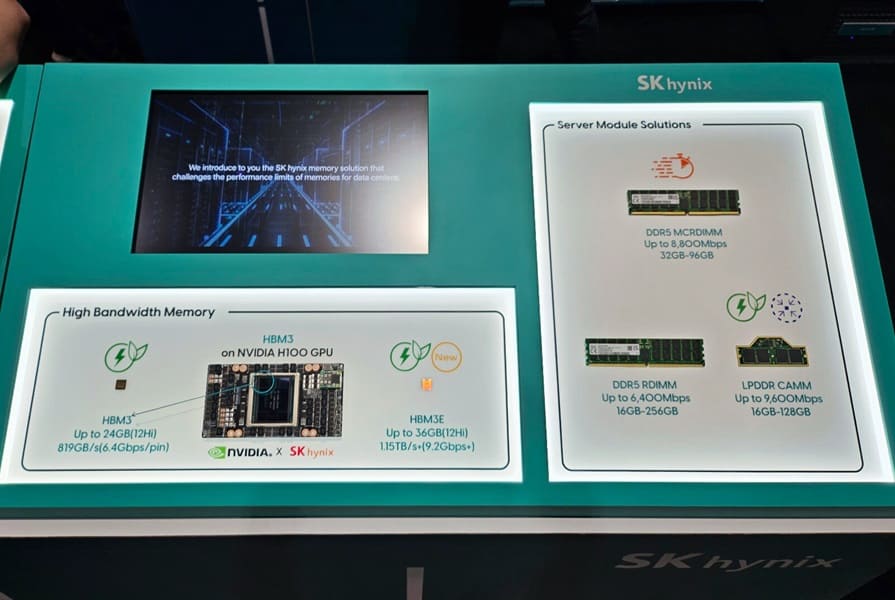

SK hynix presentó una amplia gama de sus soluciones en el evento, incluyendo su HBM (HBM3/3E), CXL y AiM líderes en el mercado para la inteligencia artificial generativa. La compañía también dio a conocer algunas de las últimas incorporaciones a su cartera de productos, como su DDR5 RDIMM, MCR DIMM, SSD empresarial (eSSD) y dispositivos LPDDR CAMM.

Los visitantes de la exposición HBM pudieron ver el HBM3, que se utiliza en el H100 de NVIDIA, una GPU de alto rendimiento para la inteligencia artificial, y también echar un vistazo al HBM3E de próxima generación. Debido a su bajo consumo de energía y su ultra alto rendimiento, estas soluciones HBM son más ecológicas y especialmente adecuadas para los sistemas de servidores de inteligencia artificial que consumen mucha energía.

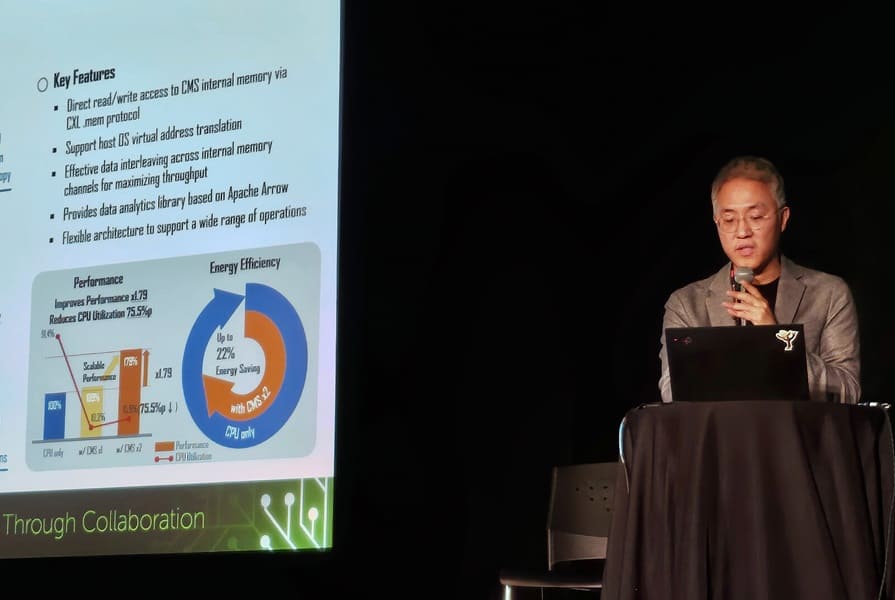

Tres de los principales productos CXL de SK hynix se demostraron en el evento, incluyendo su solución de memoria computacional basada en CXL (CMS) 2.0. Una solución de memoria de próxima generación que integra funciones computacionales en la memoria CXL, CMS 2.0 utiliza NMP para minimizar el movimiento de datos entre el CPU y la memoria. Para la demostración, CMS 2.0 se aplicó al servicio de análisis de tráfico peatonal en tiempo real de SK Telecom, ilustrando su potencia de procesamiento de datos equivalente a un CPU de servidor. Además, la demostración destacó que CMS 2.0 puede mejorar el rendimiento y la eficiencia energética del procesamiento de datos.

La compañía también mostró su solución de memoria agrupada basada en CXL, que puede reducir significativamente el uso de memoria inactiva y acortar el tiempo de sobrecarga del movimiento de datos en entornos de procesamiento distribuido como la inteligencia artificial y los grandes datos. La demostración, que contó con una colaboración tecnológica con el proveedor de software MemVerge, mostró cómo las soluciones de memoria agrupada basadas en CXL pueden mejorar el rendimiento del sistema en los sistemas de procesamiento distribuido de inteligencia artificial y grandes datos.

Además, SK hynix demostró su expansor de memoria basado en CXL aplicado al motor de caché de software de Meta, CacheLib, que mostró cómo la solución de memoria basada en CXL optimiza el software para mejorar el rendimiento y el ahorro de costes.

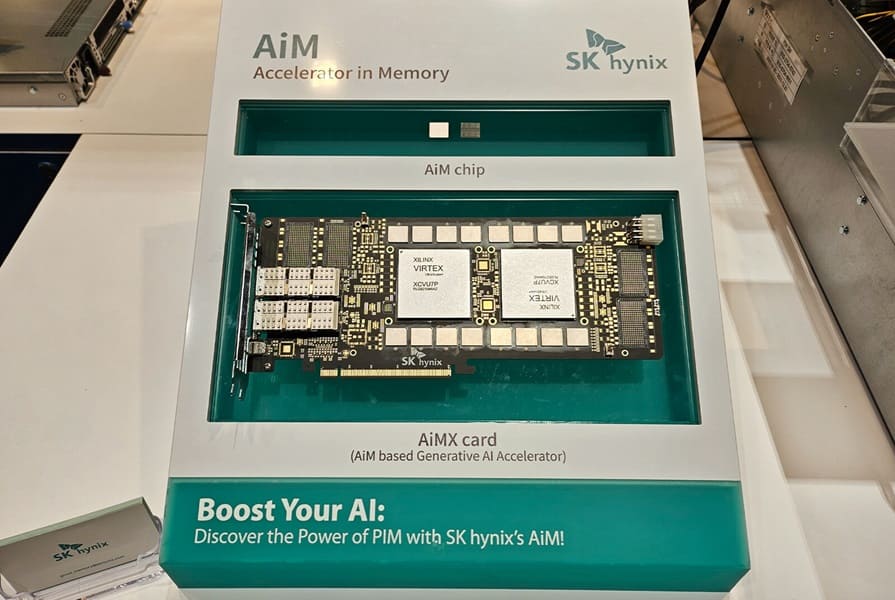

AiM, una tecnología revolucionaria que redefine el papel de la memoria en la inferencia de inteligencia artificial, también se presentó en el stand. Un subconjunto del portafolio PIM (processing-in-memory) de SK hynix, AiM promete revolucionar el aprendizaje automático, la computación de alto rendimiento y las aplicaciones de big data mientras reduce los costes operativos. La compañía demostró su GDDR6-AiM, una solución que incorpora capacidades computacionales en la memoria y mejora el rendimiento y la eficiencia de los sistemas intensivos en datos de inferencia generativa.

Vía: TechPowerUp