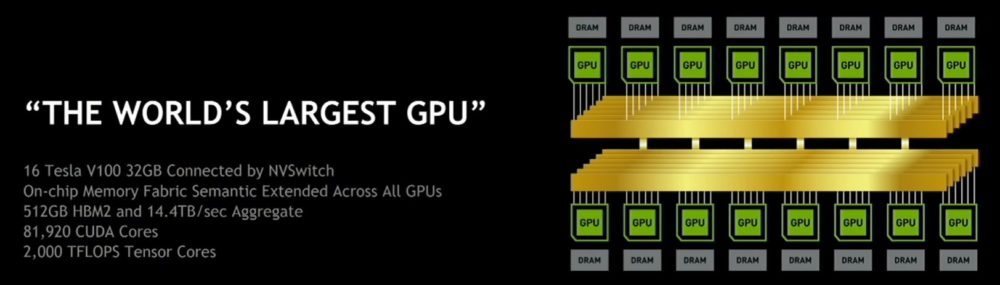

Seguimos con la GPU Technology Conference (GTC), donde NVIDIA acaba de anunciar de forma oficial la GPU más grande del mundo con 81920 CUDA cores.

Estando ante un clúster que consta de un total de 81920 CUDA cores y que es capaz de ofrecer hasta 2000 TFLOPS Tensor Cores, tratándose realmente de un conjunto de 16 GPUs Tesla V100 de 32 GB conectadas mediante NVSwitch.

Este poderoso sistema aglutina 512 GB de memoria BHM2 y un ancho de banda total de hasta 14.4 TB/s. La «GPU» se ofrece en el sistema NVIDIA DGX2, que el propio CEO Jensen Huang lo califica como «la tarjeta gráfica más grande del mundo».

NVSwitch: una revolucionaria estructura de interconexión

NVSwitch ofrece un ancho de banda 5 veces mayor que el mejor conmutador PCIe, lo que permite a los desarrolladores construir sistemas con más GPUs hiperconectadas entre sí. Ayudará a los desarrolladores a superar las limitaciones previas del sistema y ejecutar conjuntos de datos mucho más grandes. También abre la puerta a cargas de trabajo más grandes y complejas, incluida la capacitación paralela de modelado de redes neuronales.

NVSwitch amplía las innovaciones disponibles a través de NVIDIA NVLink ™, la primera tecnología de interconexión de alta velocidad desarrollada por NVIDIA. NVSwitch permite a los diseñadores de sistemas construir sistemas aún más avanzados que pueden conectar de manera flexible cualquier topología de GPUs basadas en NVLink.

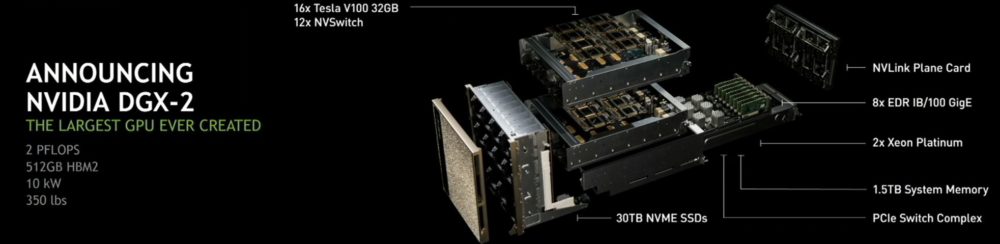

NVIDIA DGX-2: los dos primeros sistemas petaflop del mundo

El nuevo sistema DGX-2 de NVIDIA alcanzó el hito de dos petaflop gracias a una amplia gama de avances tecnológicos líderes en la industria desarrollados por NVIDIA en todos los niveles de la pila de computación.

DGX-2 es el primer sistema para presentar NVSwitch, que permite que las 16 GPUs del sistema compartan un espacio de memoria unificado. Los desarrolladores ahora tienen el poder de entrenamiento de aprendizaje profundo para abordar los conjuntos de datos más grandes y los modelos de aprendizaje profundo más complejos.

Combinado con un conjunto totalmente optimizado y actualizado de software de aprendizaje profundo NVIDIA, el DGX-2 está especialmente diseñado para científicos de datos que impulsan los límites externos de la investigación y la informática de aprendizaje profundo.

DGX-2 puede entrenar FAIRSeq, un modelo de traducción automática neuronal de última generación, en menos de dos días: una mejora de 10 veces en el rendimiento de la DGX-1 con Volta, presentado en septiembre.

Desde Fanáticos del Hardware os mantendremos totalmente al tanto de cualquier novedad que vaya surgiendo al respecto.