Buenas Fanátic@s y bienvenid@s a una nueva review, en esta ocasión tenemos entre manos la Nvidia RTX 2080 de la nueva arquitectura Turing. Cuando oímos de la arquitectura Turing por primera vez durante el año pasado, todo apuntaba a que iba a ser una arquitectura dedicada al minado de criptomonedas, mientras que Volta iba a ser la sucesora de Pascal, la cual solo ha llegado al sector profesional con la Titan V, y no podíamos estar mas equivocados.

Con la llegaba de Turing al sector domestico se marca un punto de inflexión en el sector de las tarjetas gráficas para el sector domestico destinadas a la ejecución de videojuegos, donde cada vez cuesta mas seguir la ley de Moore introduciendo el doble de transistores dentro del mismo área para aumentar el rendimiento, y dado que Nvidia esta a años luz de sus competidores en los que a rendimiento se refiere, nos sorprende con la adopción de nuevas tecnologías que aproximan el realismo en el renderizado de gráficos 3D de futuras generaciones a nuestros días.

Unboxing

La RTX 2080 llega en una caja donde predomina el color gris simulando un relieve alrededor de ella, su frontal nos indica que nos encontramos delante de la gama RTX y debajo nos muestra el modelo en concreto con el fondo en el tono verde característico de la marca.

En su interior encontramos la RTX 2080 posicionada de manera vertical como si de un estandarte se tratase, junto a una caja en la que en su interior trae la documentación y un adaptador DisplayPort a DVI-D.

Vistazo de cerca

Lo más destacable de su diseño es que por primera vez Nvidia adopta los sistemas de doble ventilador axial para sus modelos Founders Edition, descartando los modelos de turbina que traían las anteriores generaciones.

Incorpora un backplate metálico que no solo la mantiene perfectamente rígida, ademas cuenta con termal-pads para disipar el calor la parte posterior de la GPU, los VRMs y las memorias.

Requiere de una conexión de 6 pines y otra de 8 pines para su alimentación.

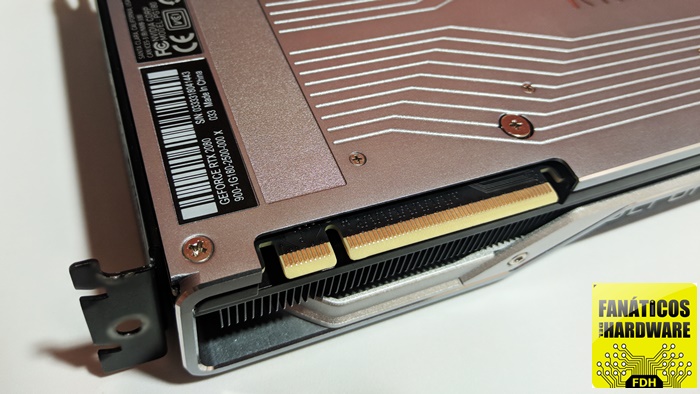

Tiene unas medidas 27 cm de largo por 11,5 cm de ancho y ocupa 2 ranuras y funciona a través del bus PCI-Express 3.0

Para la comunicación entre tarjetas gráficas montadas en SLI la arquitectura Turing estrena conexión en la gama domestica con NVLink, la cual permite enlazar dos tarjetas gráficas a través de un bus de dos vías de 50/100GB/s, un incremento importante comparado con la anterior conexión SLI (1 Gb/s) y su sucesora SLI HB (2 Gb/s), además esta conexión comunica las tarjetas gráficas punto a punto lo que reduce de manera considerable las latencias comparado con el puerto PCI-Express 3.0 convencional.

Por el lado de sus conexiones tenemos:

- Tres DisplayPort 1.4a, estándar lanzado en Abril de este año, con soporte 8K @ 30Hz utilizando un solo cable y 8K @ 60 Hz cuando DSC esta activado.

- Un HDMI 2.0b

- Conector VirtualLink, que es básicamente un USB-C con soporte DisplayPort y USB-PD para cascos de realidad virtual.

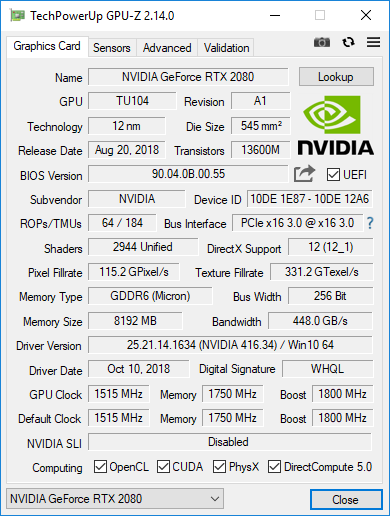

Arquitectura

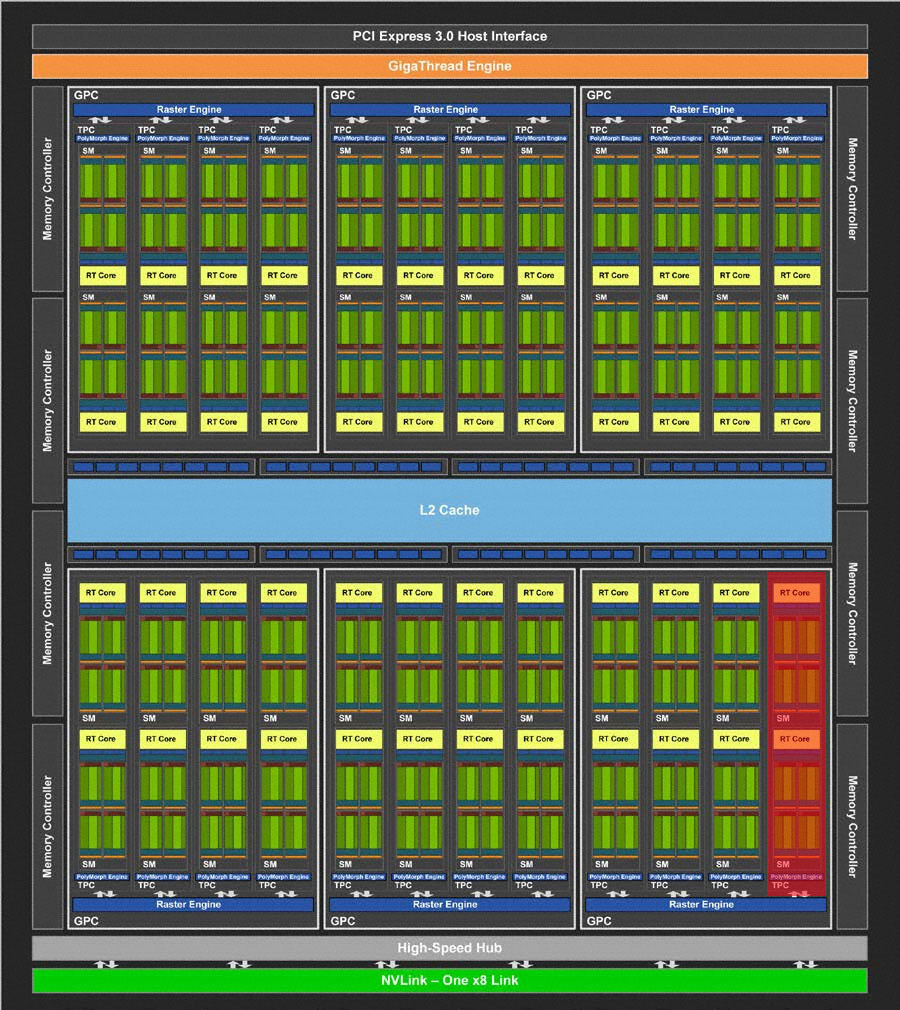

La Nvidia RTX 2080 es una tarjeta gráfica con arquitectura Turing que cuenta con chip el TU104 fabricado por TSMC bajo una litografía de 12nm, es el segundo chip más grande de la arquitectura, con un tamaño de 545mm2 y 13,6 millones de transistores en su interior, el núcleo trabaja a una frecuencia base de 1515 MHz que con el Boost se elevan automáticamente hasta los 1800 MHz, unido a 8Gb de memoria VRAM GDDR6 firmadas por Micron trabajando a una frecuencia base de 1750 MHz (14000 MHz efectivos), que a través de un bus de 256 bits arroja unas transferencias de 448 Gb/s, el resto de sus especificaciones se complementan con soporte Directx 12.1, OpenGL 4.6, Vulkan 1.1.82 y soporte SLI a través de la nueva conexión NV-Link.

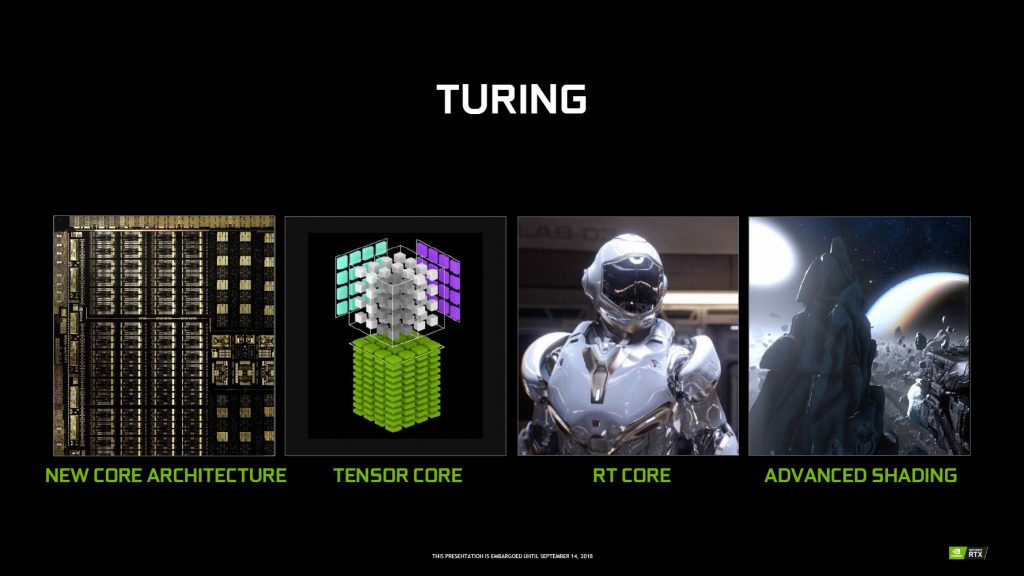

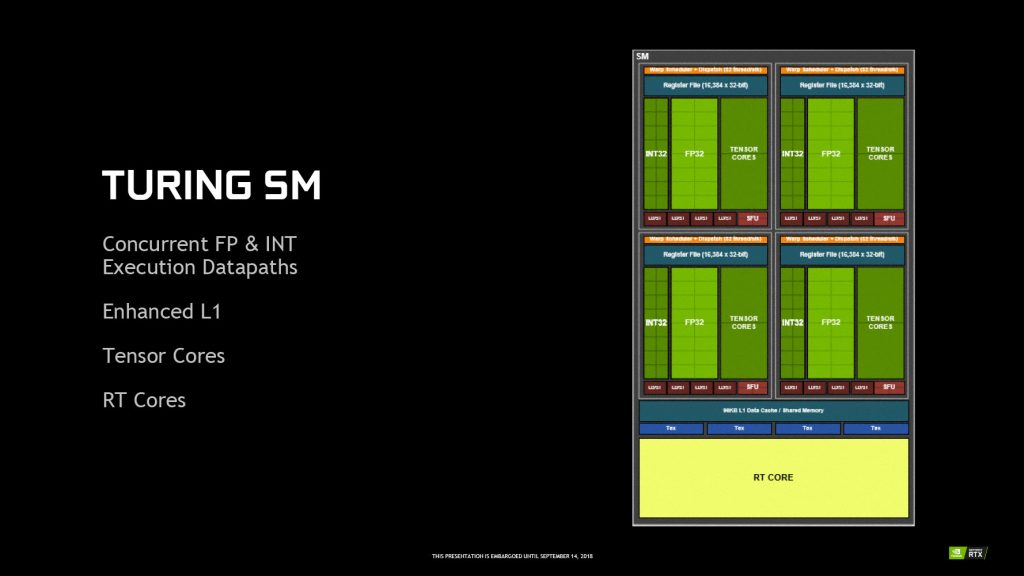

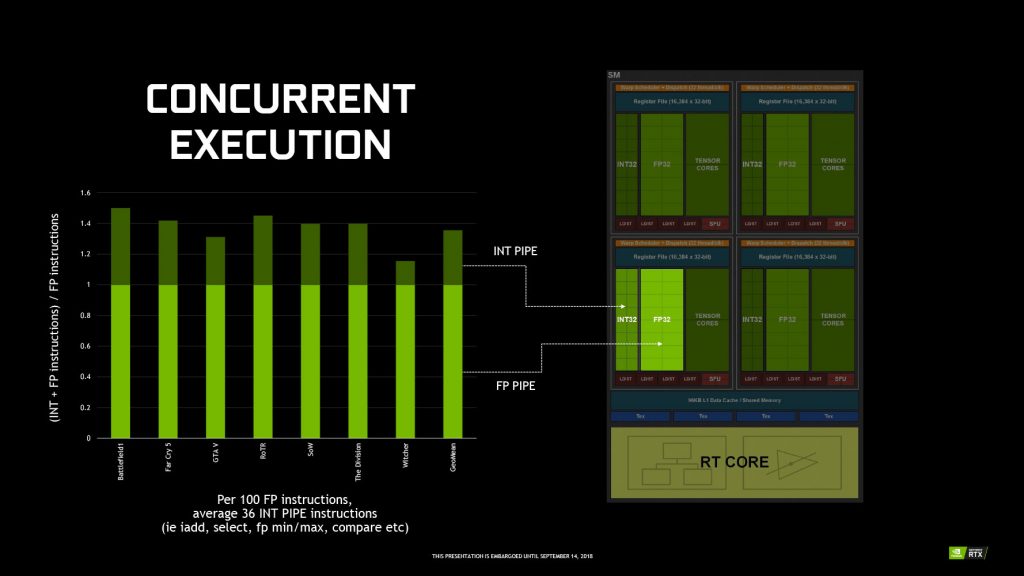

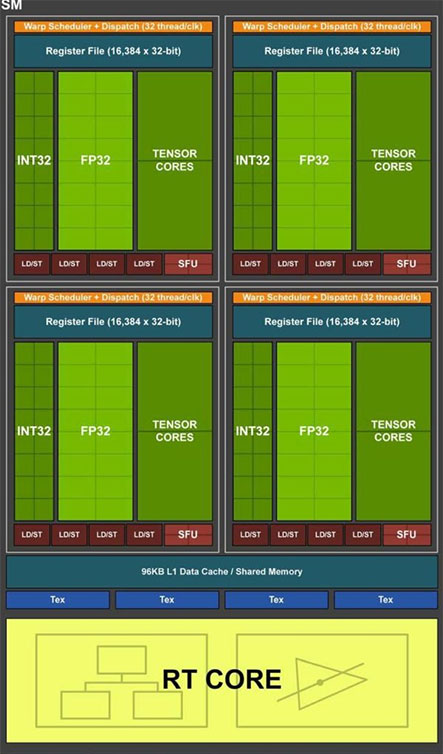

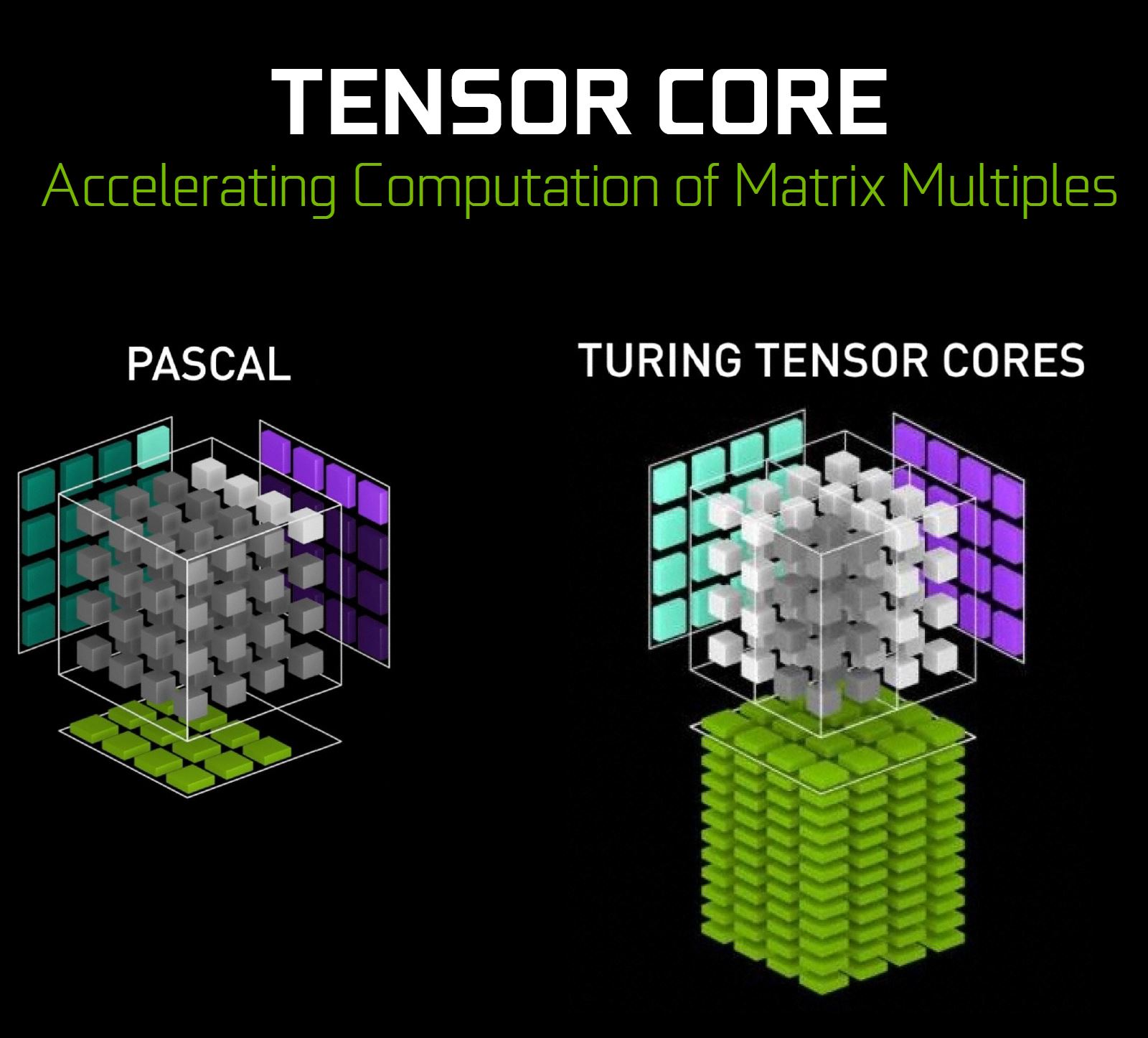

Aunque los aspectos más destacables de esta nueva arquitectura son la modificación de los SMs, parte fundamental de la GPU en la que residen los procesador CUDA, donde Nvidia entre otras cosas continua con la reducción de procesadores CUDA dentro de ellos y que tan buen resultado les dio con la transición de Kepler (192 CUDAS por SM) a Maxwell (128 CUDAS por SM, manteniendo el mismo número en Pascal), ahora dentro de cada SM además de 64 núcleos CUDA también residen 8 núcleos tensor y un núcleo RT que gracias al nuevo Warp Scheduler admite operaciones INT y FP32 que deberían de mejorar el computo asíncrono de la GPU.

Otra novedad de esta nueva arquitectura es que desde que Nvidia introdujo el concepto de clústeres de proceso gráfico (GPC) con la arquitectura Fermi en 2010, no se había aumentado su número hasta ahora, siendo un máximo de 4 GPCs los que encontrábamos dentro de la tarjetas gráficas de Nvidia, ahora con la llegada de Turing Nvidia ha aumentado el número de GPCs dentro de cada tarjeta gráfica hasta 6, en el caso del chip TU104 dentro de cada GPC encontramos 8 SM, lo que nos da 512 núcleos CUDA, 64 núcleos Tensor y 8 núcleos RT dentro de cada GPC, lo que resulta en un total de 3072 núcleos CUDA, 384 núcleos Tensor y 48 núcleos RT en el chip TU104 completo.

Dentro de la RTX 2080 Nvidia ha deshabilitado 2 SMs en su chip TU104, lo que da un total de 2944 núcleos CUDA, 368 núcleos tensor y 46 núcleos RT, sus especificaciones se complementan con 184 TMUs y 64 ROPs.

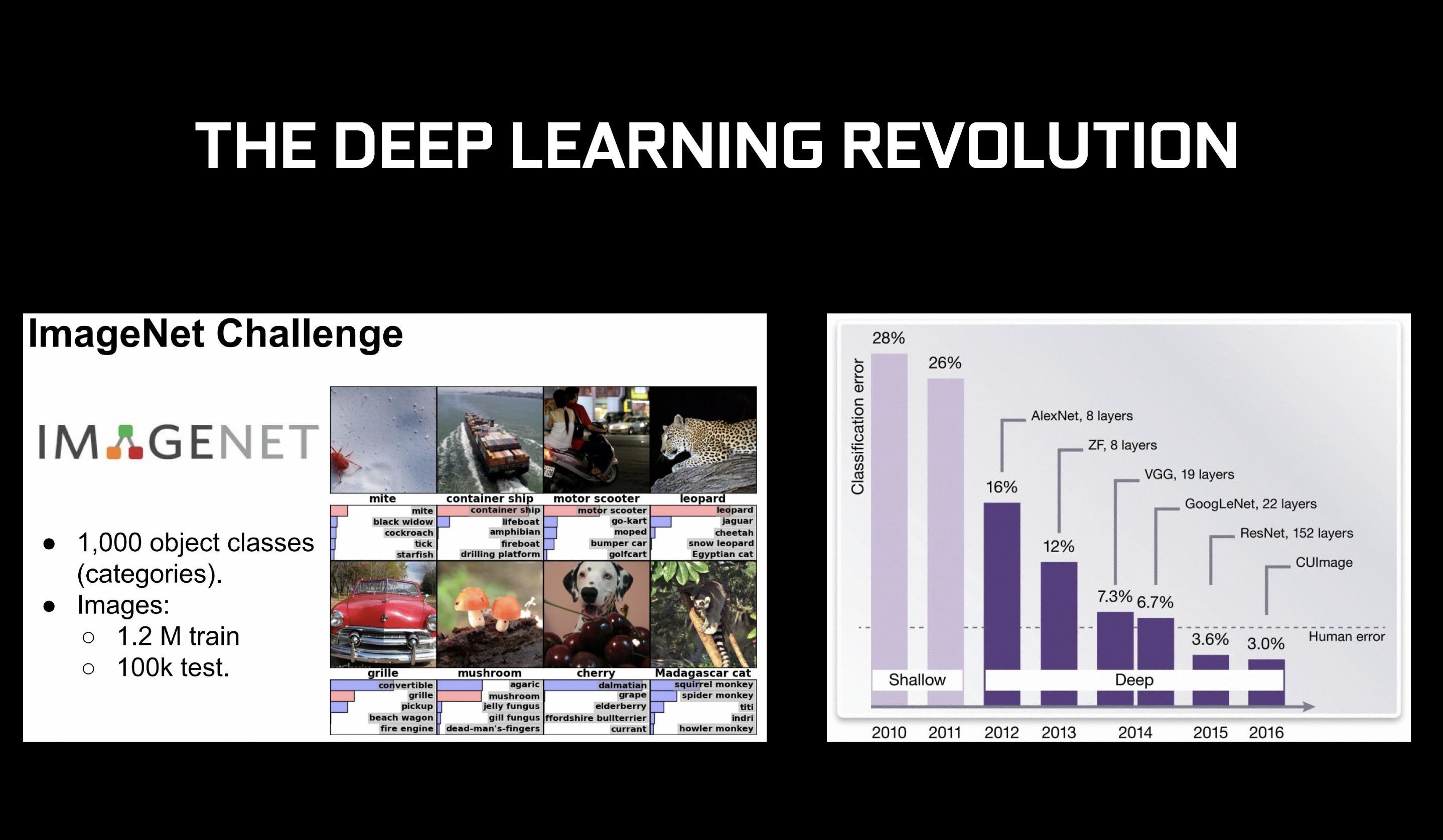

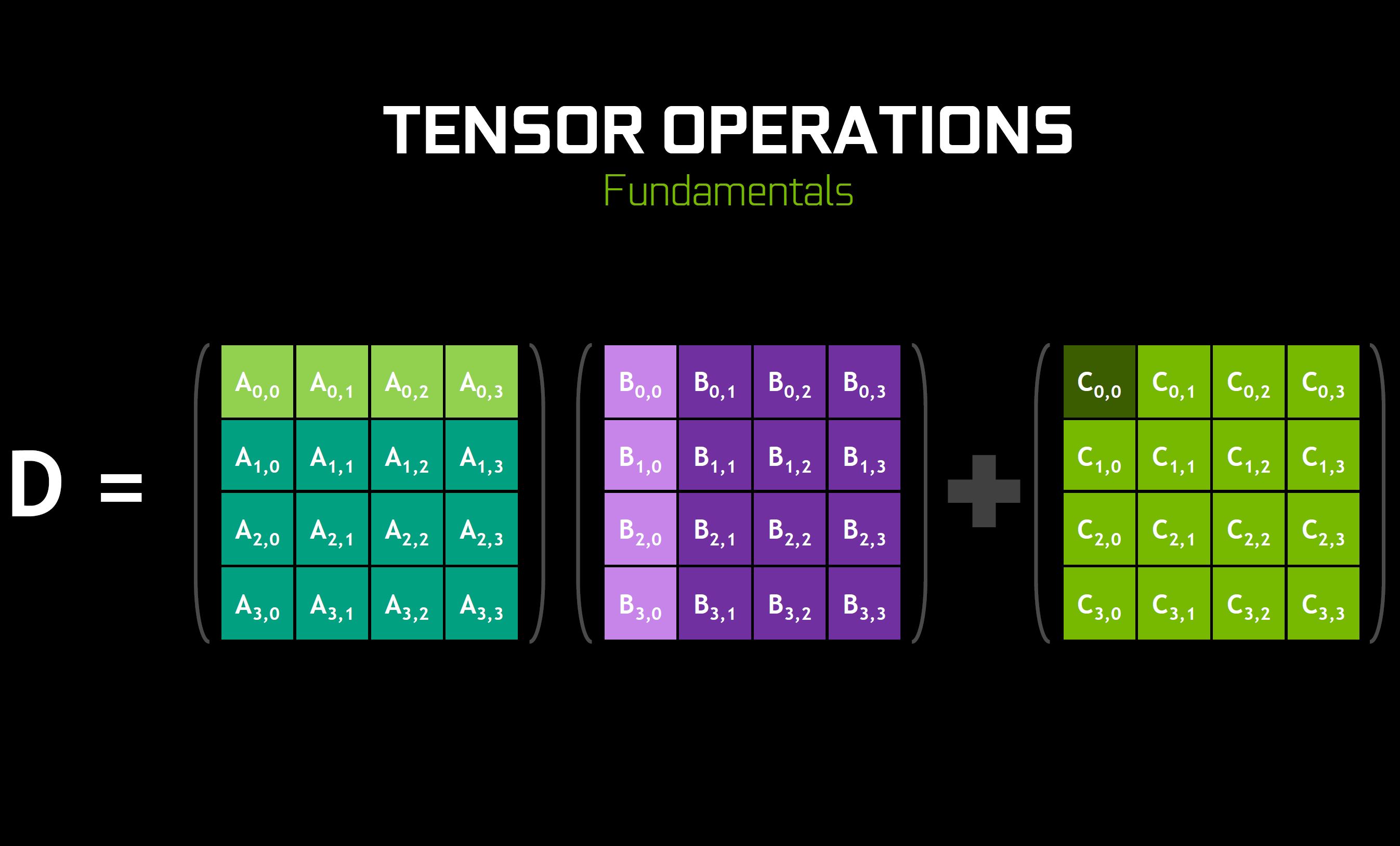

Núcleos Tensor y DLSS

Una de las tecnologías de la arquitectura Turing son los Tensor Cores (núcleos tensor), resultado de 5 años de inversión en inteligencia artificial por parte de Nvidia desarrollando sus primeros modelos de redes neuronales de aprendizaje profundo procesadas a través de GPU/CUDA y que se estrenó con el lanzamiento de la arquitectura Volta para el sector profesional, se trata de procesadores dedicados a realizar operaciones tensor y especializados en la multiplicación de matrices 3x3x3, con la intención de acelerar la formación de redes neuronales para el aprendizaje profundo de la IA, ya que CUDA requería de demasiado tiempo y recursos para la construcción y entrenamiento de redes neuronales.

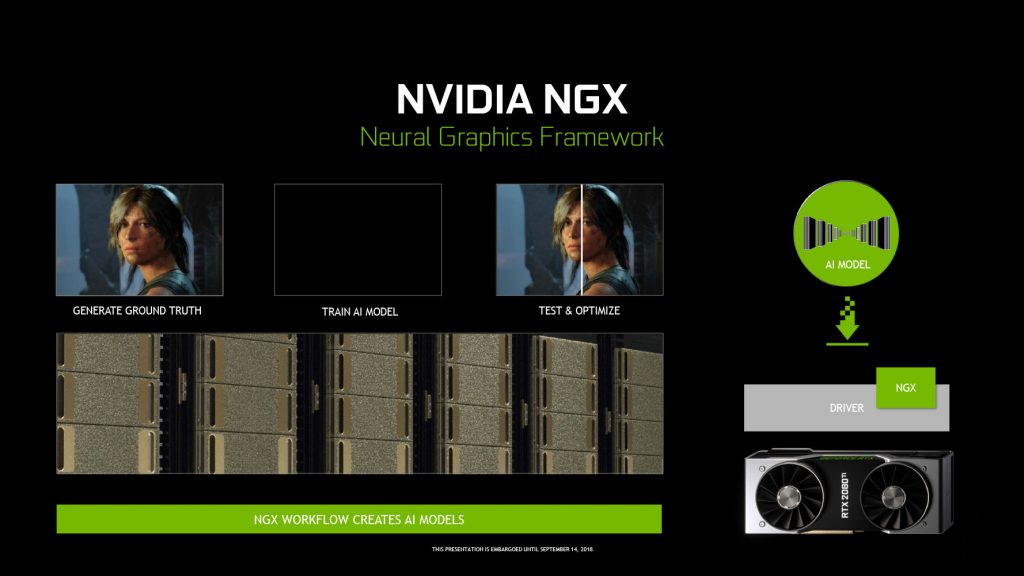

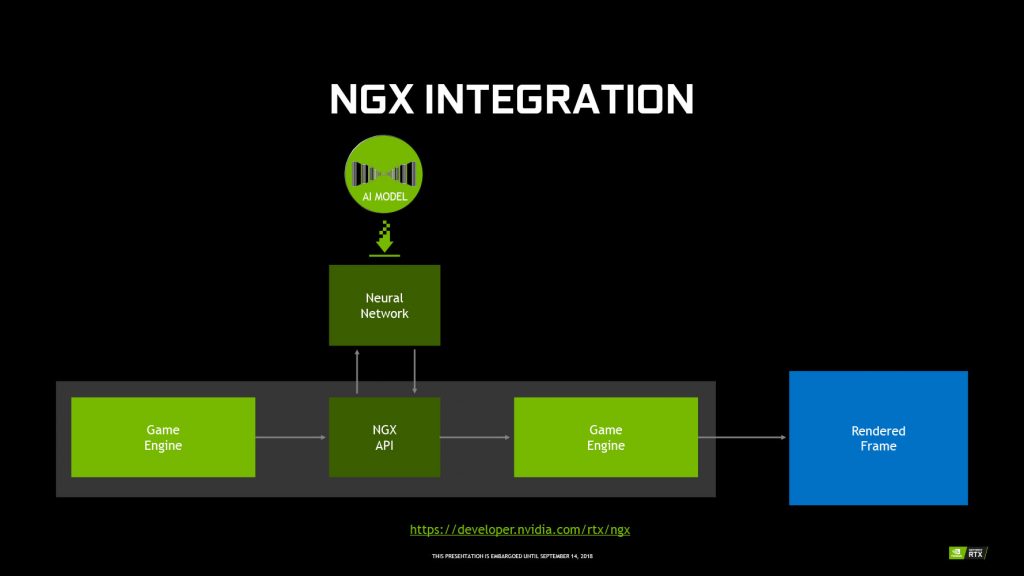

Aunque en un principio su aplicación en el sector de los videojuegos es muy limitada, Nvidia está introduciendo algunas mejoras en la calidad de imagen procesadas por IA gracias a estos núcleos tensor, como es el nuevo filtro antialiasing A DLSS (Deep Learning Anti-Aliasing), el cual promete una mejora de rendimiento significativa comparada con otros filtros que actualmente ya se encuentran implantados en muchos títulos como es TAA, según la marca la calidad de imagen con un filtro 2X DLSS es comparable a un filtro 64X super sampling clásico.

El nuevo filtro DLSS funciona a través de los núcleos Tensor, los cuales analizan los fotogramas mediante su red neuronal entrenada para eliminar los picos de sierra, para después mandar la imagen postprocesada al monitor, dicho de manera sencilla es un filtro antialiasing aplicado por una inteligencia artificial.

Lo mejor de este filtro es que Nvidia se encarga de que su inteligencia artificial no deje de aprender, a base de analizar una y otra las imágenes en un juego se compila un modelo DLSS para ese titulo, el cual es enviado a la computadora de los usuarios mediante Geforce Experience para ser procesado de manera local por los núcleos Tensor de la tarjeta gráfica.

Núcleos RTX

Desde los años 70 el trazado de rayos de luz en tiempo real (Ray Tracing) era considerado el santo grial en la evolución de los gráficos 3D, aunque en los últimos años ya hemos visto que Nvidia intentaba una aproximación mediante su API OptiX, los cuales basaban el proceso de rayos de luz en tiempo real a través de CUDA, aunque la pesada carga de proceso computacional que ello supone lleva al límite los procesadores CUDA.

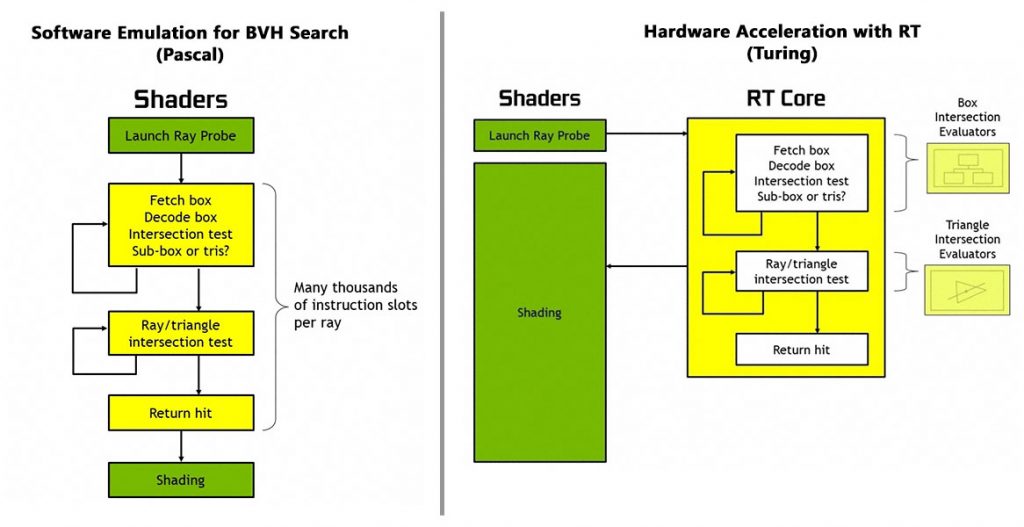

Y aquí es donde ve la luz el secreto mejor guardado de Nvidia, y que estuvo gestándose durante 15 años en las entrañas de la empresa, los núcleos RTX, se trata de hardware dedicado al proceso de Ray Tracing, especializado en la representación matemática de un rayo atravesando una escena y calcular el punto de intersección en cualquier triangulo para representarlo en pantalla, dicho de otra manera, se lanza un rayo de luz desde un pixel de la pantalla hacia el escenario 3D y este rebota hacia la fuente de luz, de manera inversa a como funciona la luz con nuestros ojos en el mundo real pero con el mismo resultado, en el caso de que el rayo después de rebotar en el objeto hacia la fuente de luz encuentre un objeto durante su trayectoria ese pixel será sombreado como un reflejo/sombra, no hace falta decir que este tipo de proceso requiere de una gran capacidad de computo.

RTX es una tecnología dedicada al proceso de la iluminación en tiempo real a través de Ray Tracing, que abarca todo y en el que se incluyen sistemas para el sombreado y la oclusión ambiental, que trabajando en conjunto con los núcleos Tensor consiguen reducir la carga de trabajo que ello supone mediante un algoritmo de jerarquía de volumen delimitador (BVH), dicho de manera sencilla, se calcula el área de la escena que se representa en pantalla mediante recuadros en los objetos y los triángulos que en ella aparecen, y mediante la división en niveles gracias a la potencia para el proceso en paralelo de las tarjetas gráficas actuales se crea un índice en forma de árbol, el cual se procesa todo a la vez para ir descartando las áreas más simples una vez procesadas y centrado la asignación de recursos en las áreas más complejas, solo las áreas donde sigue habiendo un impacto en la demanda del proceso de rayos en tiempo real se sigue procesando, reduciendo el tamaño de los recuadros dentro de esa área, y nuevamente descartando las áreas más simples una vez procesadas se vuelve a centrar la asignación de recursos en las áreas más complejas dentro de esa área, así se van descartando las áreas y los recuadros hasta que se obtiene un pixel en pantalla.

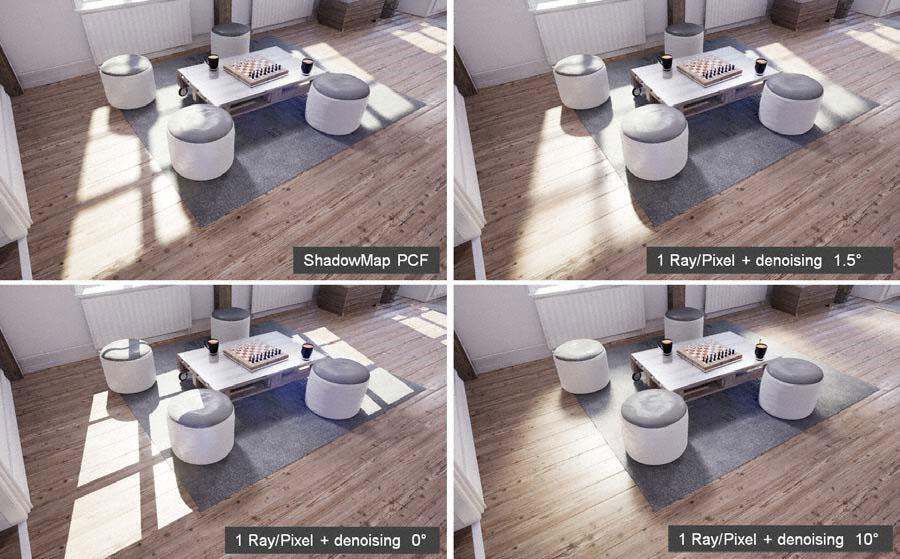

Como se puede esperar de este tipo de proceso, se generarían pixeles negros en pantalla, produciendo un molesto ruido sobre la imagen, dependiendo de la escena este ruido es eliminado mediante distintos tipos de algoritmos, entre ellos algunos procesados mediante IA.

Según la compañía la tecnología RTX supone un avance tan tangible en el realismo de los gráficos 3D como lo fueron los sombreadores programables con las Geforce 3 en el año 2001, gracias al ahorro en costes de tiempo y de recursos para los programadores, tanto en la curva de aprendizaje como en la adopción de las herramientas necesarias para implantar el proceso de rayos en tiempo en el mercado general para los consumidores de a pie, ya que de otra manera con el hardware que había disponible hasta ahora hubiera sido imposible debido a la alta demanda de proceso que ello supone.

Memoria GDDR6

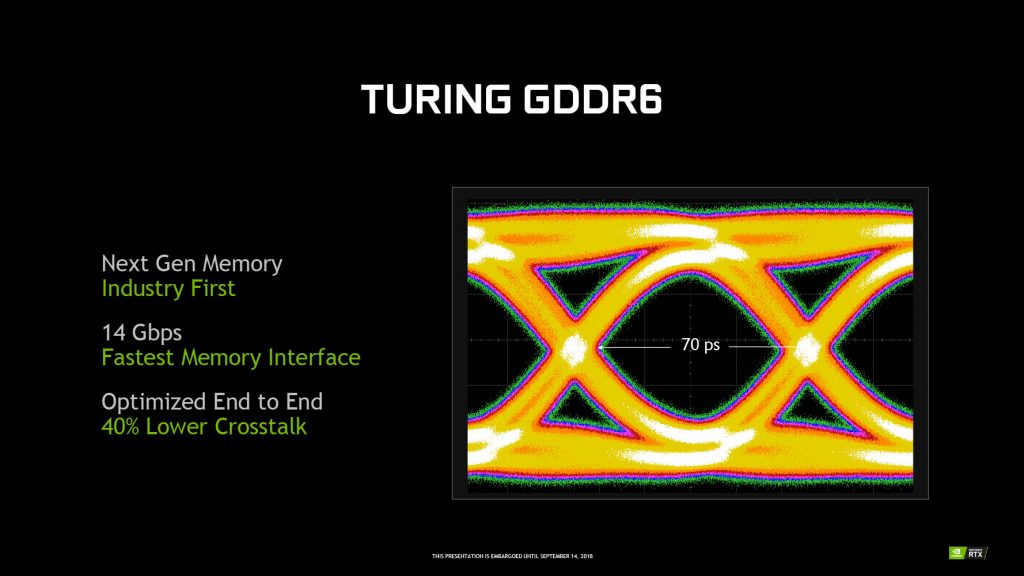

La memoria GDRR6 es la sucesora directa de la GDDR5X, pues no hay diferencias notables entre ellas más allá del aumento de la frecuencia de 10Gbps @ 16Gbps, aunque Nvidia ha optado de momento por 14Gbps, o la división de la memoria en dos canales por chip, ahora además de poder operar a 32bits cada chip podrá generar dos canales independientes de 16 bits, lo que debería de ayudar al proceso en paralelo para títulos que los soporten, por lo que la mejora no ha sido tan notable como si lo fue el paso de GDDR5 a GDDR5X, otra diferencia es su voltaje dinámico, el cual puede operar entre 1,35v y 1,25v, a diferencia de GDDR5X que funciona a un voltaje fijo de 1,35v, el voltaje de 1,25v se emplea en situaciones donde la demanda en la velocidad de datos no es muy alta.

La principal diferencia que encontramos en la memoria GDDR6 comparada con GDDR5X reside en que todos los fabricantes de DRAM adopten GDDR6 como el nuevo standard para el mercado de consumo, siendo una alternativa más económica de producir que la memoria HBM2.

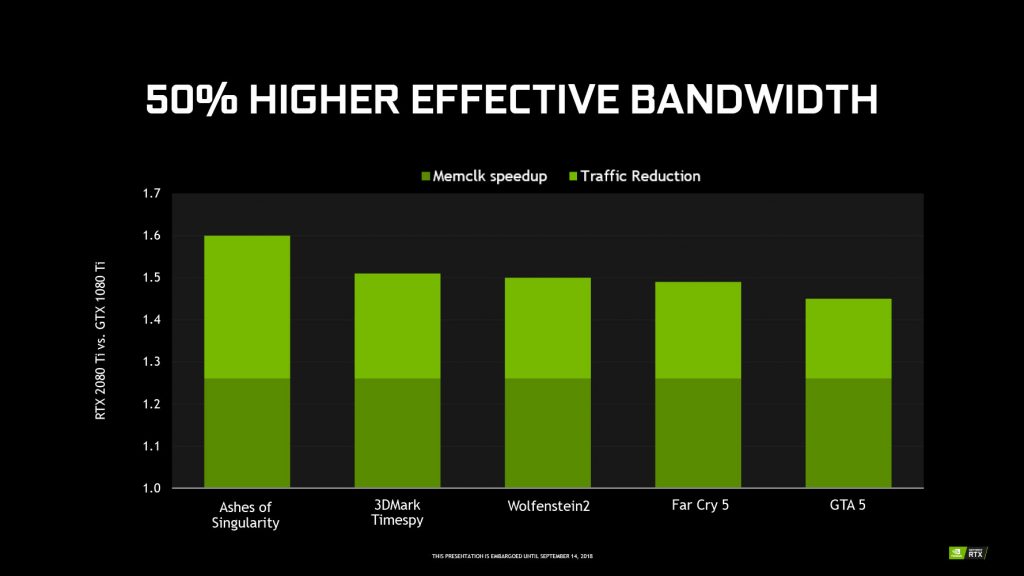

Compresión de color sin pérdida de calidad

Desde Fermi Nvidia ha ido mejorando su algoritmo para la compresión del color delta, lo que reduce los requisitos de ancho de banda de la memoria, uno de los ejemplos más claros de esta optimización en la memoria es que la GTX 1060 tiene el mismo ancho de banda bruto que una GTX 760 siendo considerablemente más potente, siendo esta su quinta generación se ha conseguido una mejora del 25% comparada con Pascal sin perder calidad de imagen, la cual ya tenía una mejora de un 20% comparada con Maxwell.

Mejoras en los sombreadores de pixeles

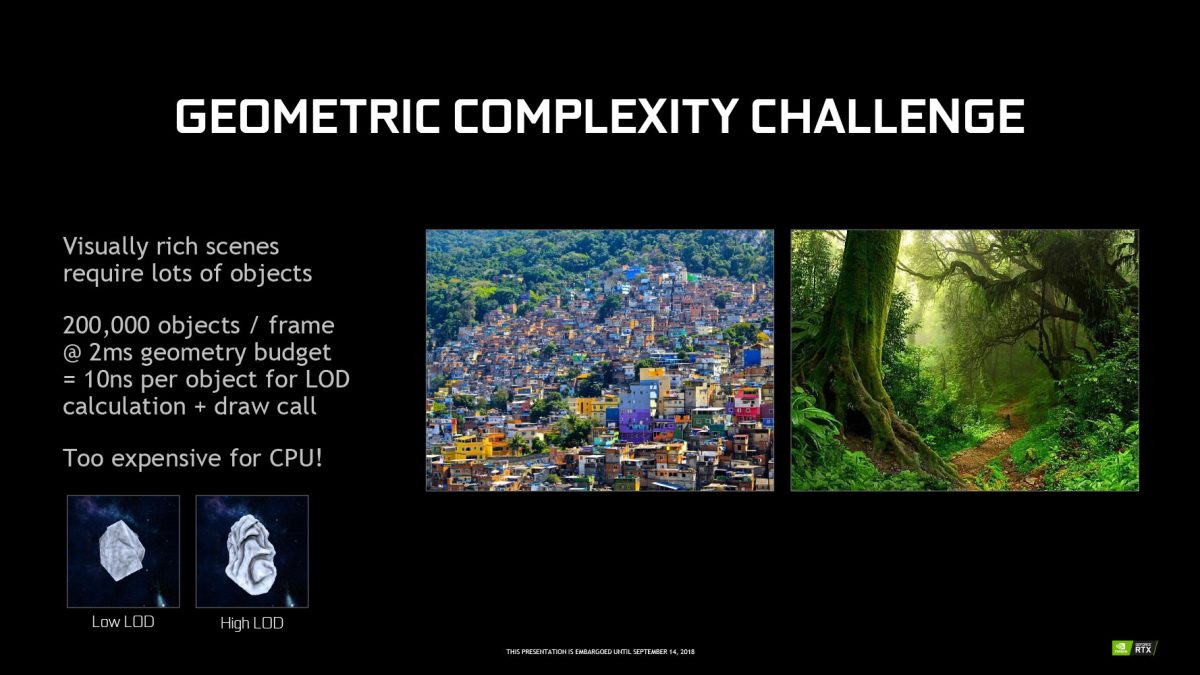

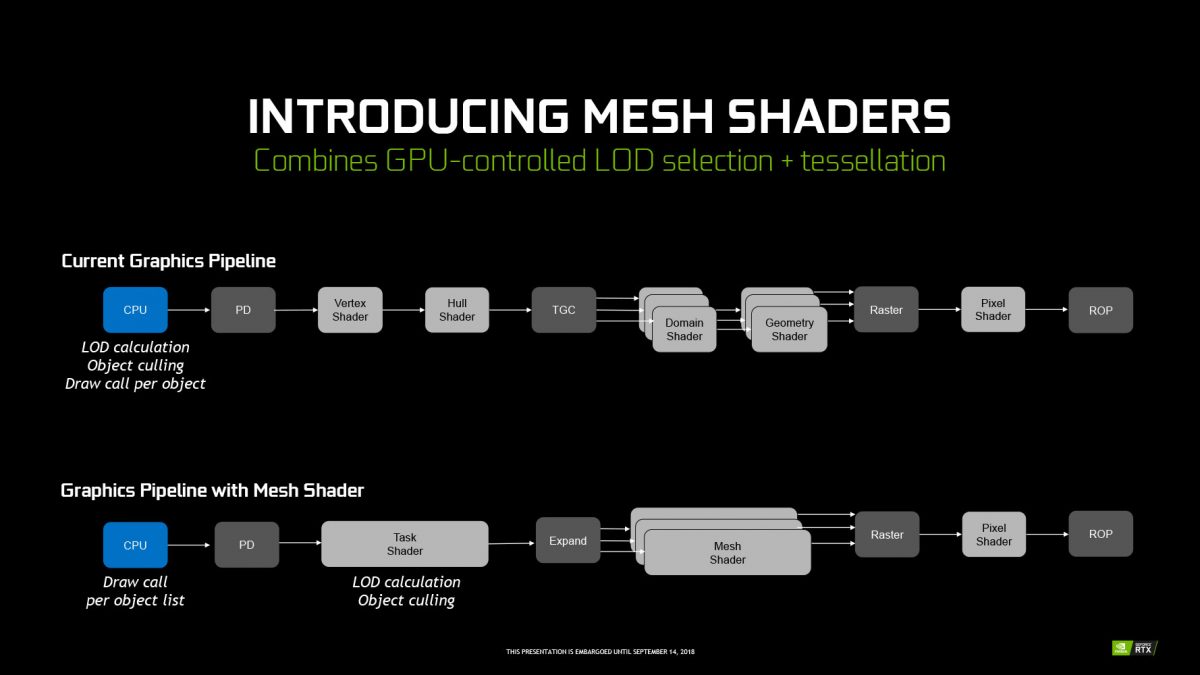

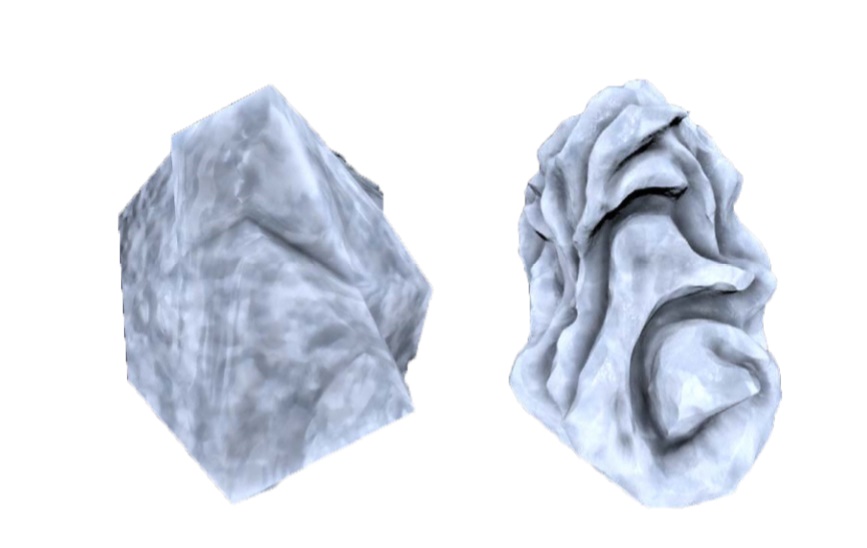

Aunque quizás las tecnologías más significativa para los usuarios de a pie reside en la mejora de los sombreadores (Shaders), como es Mesh Shading (sombreador de malla), donde entre otras cosas la GPU tiene acceso a la lista de objetos en la escena que va a procesar la CPU en vez de únicamente a los objetos individuales, lo que reduce las llamadas de dibujado al procesador y el cuello de botella que este pueda producir.

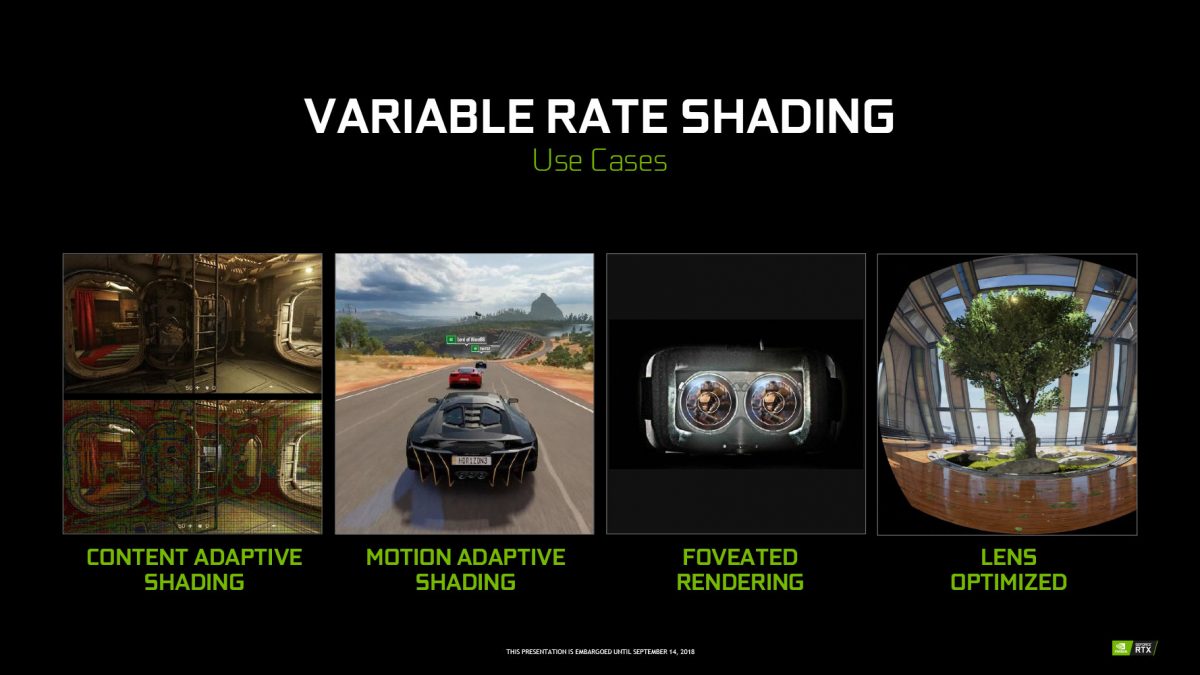

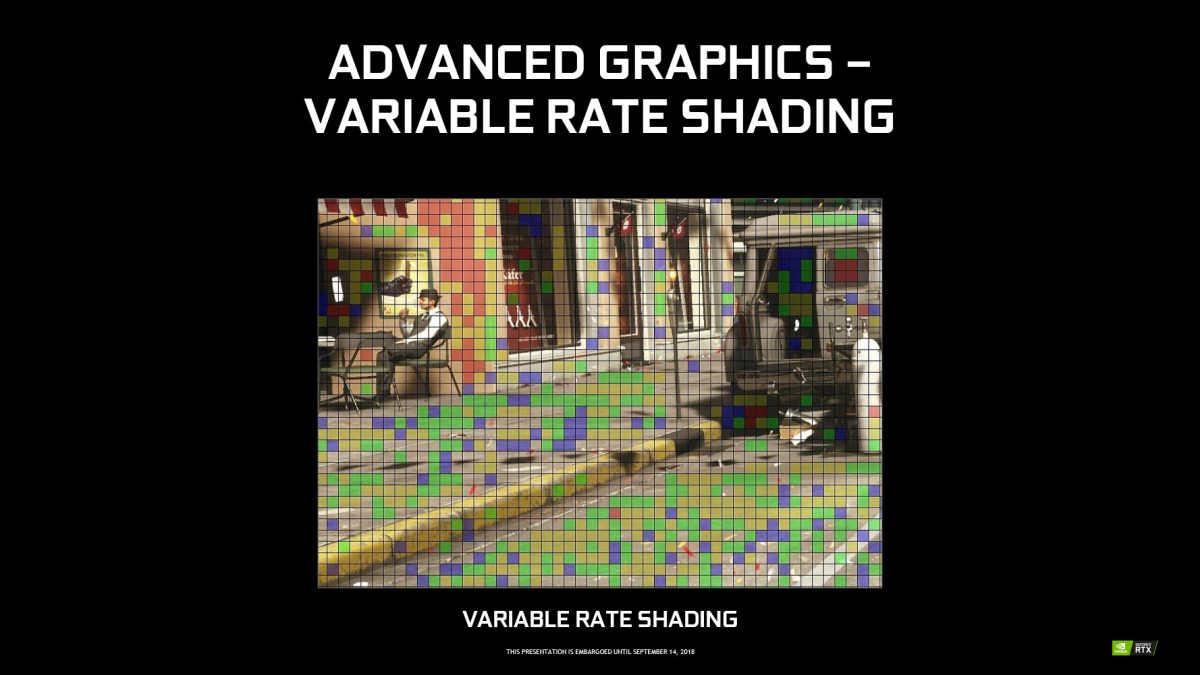

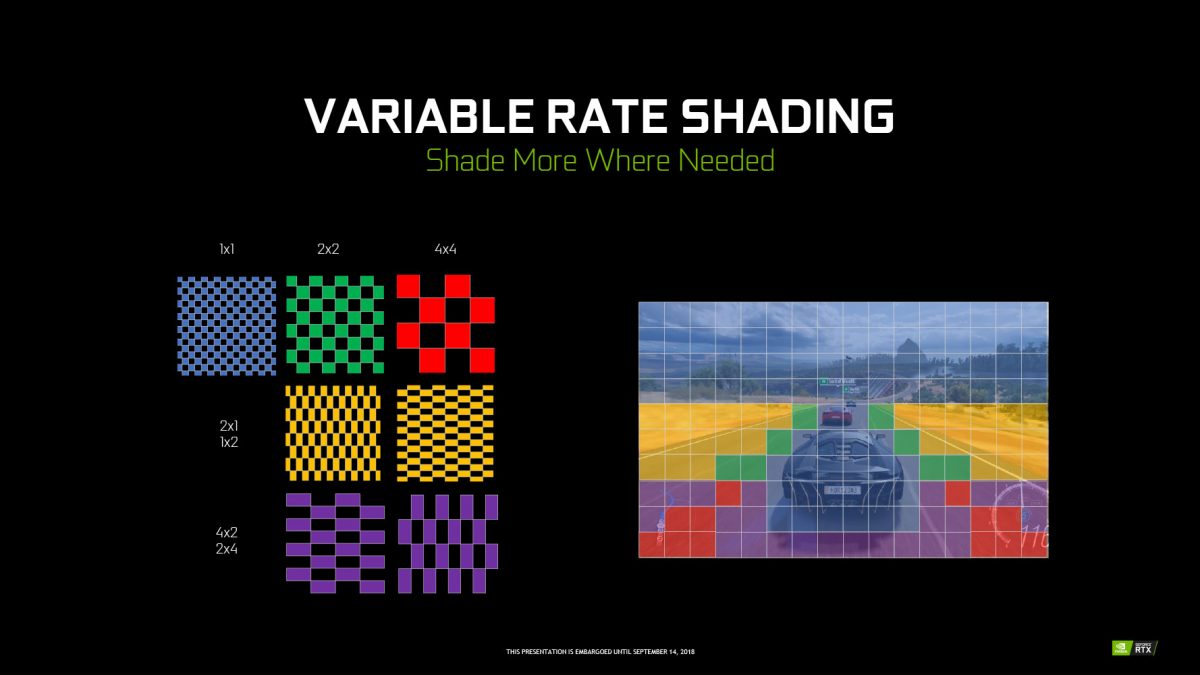

Variable Rate Shading (sombreado de tasa variable), consiste en la distribución de la carga de trabajo y proceso de la GPU dependiendo de la importancia de los objetos en escena, buscando optimizar la calidad y el rendimiento reduciendo la carga de sombreado y el nivel de detalle en las áreas que no se consideren importantes para la experiencia en general.

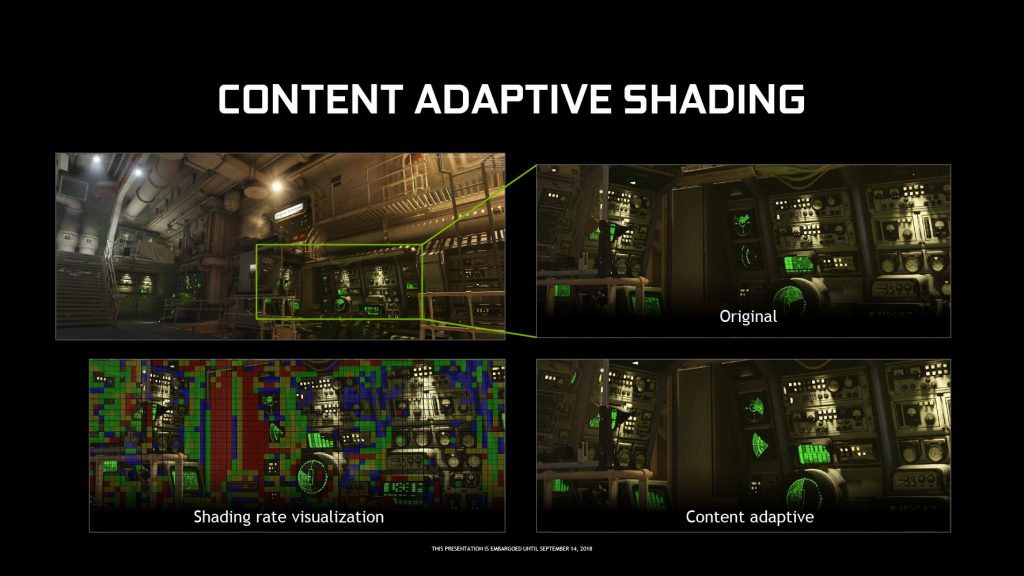

Contect Adaptive Shading (sombreado adaptativo de contenido), con el que a partir de los fotogramas anteriores se calcula que partes de la escena requieren menor carga de sombreado, como pueden ser cielos o paredes, y con ello reducir los índices de sombreado.

Motion Adaptive Shading (sombreado adaptativo al movimiento), con el que se calcula la cantidad de sombreado requerido sobre los pixeles para que la escena en movimiento tenga un nivel de detalle adecuado para nuestra percepción, normalmente los objetos que se mueven a mayor velocidad se procesan mediante técnicas de desenfoque como son Motion Blur o DoF (profundidad de campo), con las que las diferencias de sombreado son menos perceptibles, Motion Adaptive Shading calcula mediante varios algoritmos de desenfoque de manera inversa, que cantidad de trabajo de sombreado se necesita para cada situación, por ejemplo a velocidades más bajas aumentan los requisitos de sombreado.

Foveated Rendering, se trata de una técnica empleada en los cascos de realidad virtual para optimizar el renderizado el cual debe alcanzar los 90 FPS (90 Hz) para su correcto funcionamiento, aunque se puede aplicar a todas las salidas de imagen como son los monitores, consiste en aprovechar el hecho de que nuestra percepción visual se centra en los objetos que se encuentran en el centro de nuestro campo de visión, difuminando los objetos que se encuentran por la periferia, de igual manera que hace nuestro cerebro, Nvidia intenta saber qué es lo que nuestros ojos están viendo mediante el seguimiento ocular, para aumentar o reducir dinámicamente la resolución de las áreas de la escena dependiendo si están en el centro o en la periferia de nuestro campo de visión.

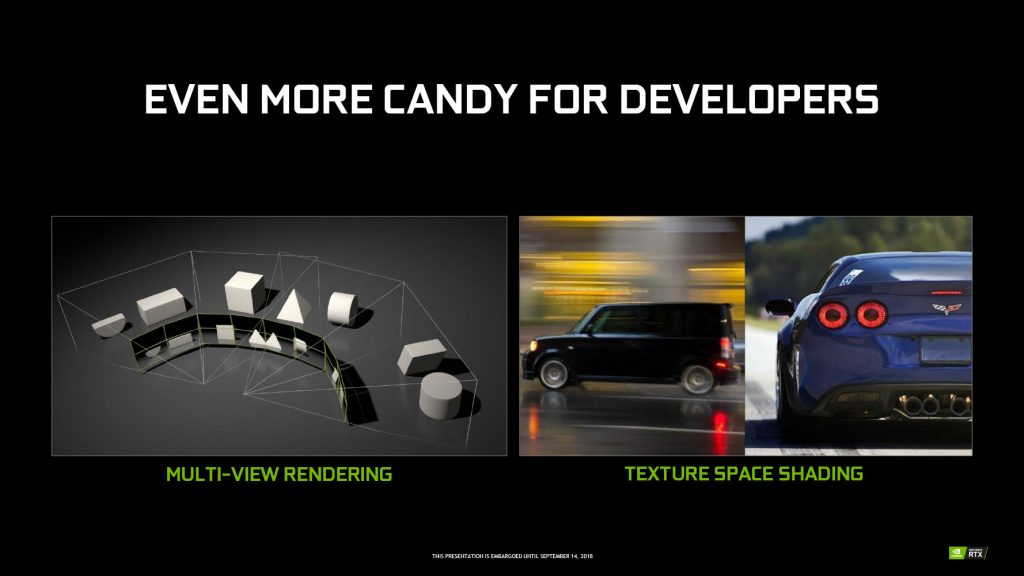

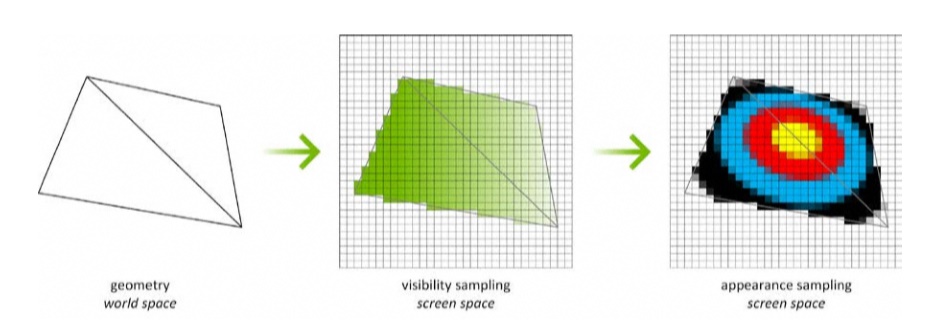

Texture Space Shading, reutiliza los pixeles previamente calculados y sombreados fotograma a fotograma, mejorando la calidad y el rendimiento, guardando dinámicamente los pixeles sombreados a resolución completa como texels en un espacio de la textura, estos pixeles se vuelven a renderizar en el siguiente fotograma como el resultado de un texel, cargándolo directamente desde el espacio de la textura, evitando tener que volver a calcularlo para cargarlo.

Pruebas de rendimiento

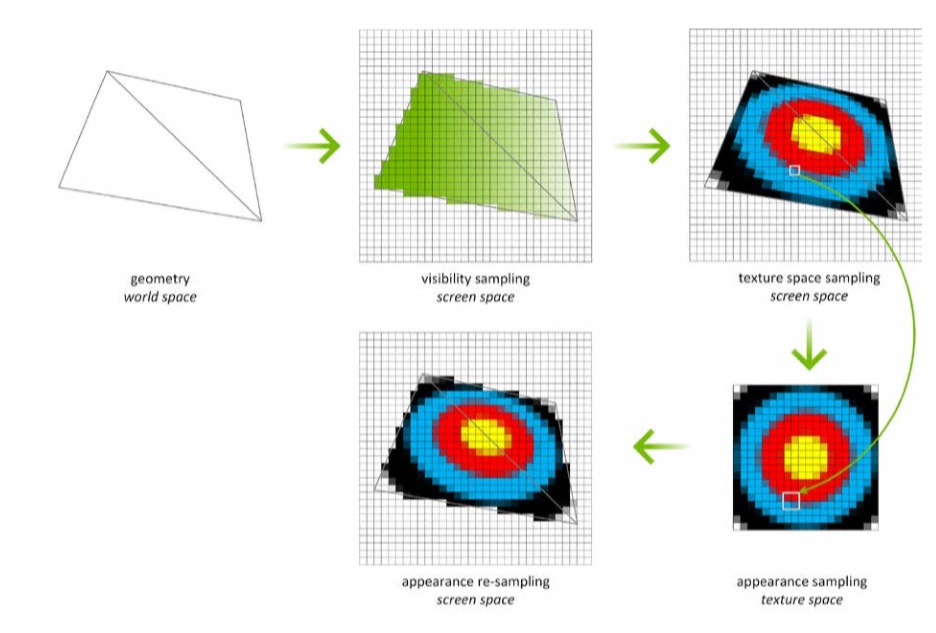

En las pruebas de rendimiento vamos a compararla con la GTX 1080Ti, el modelo mas potente de la arquitectura Pascal para el sector doméstico.

Pruebas Sintéticas

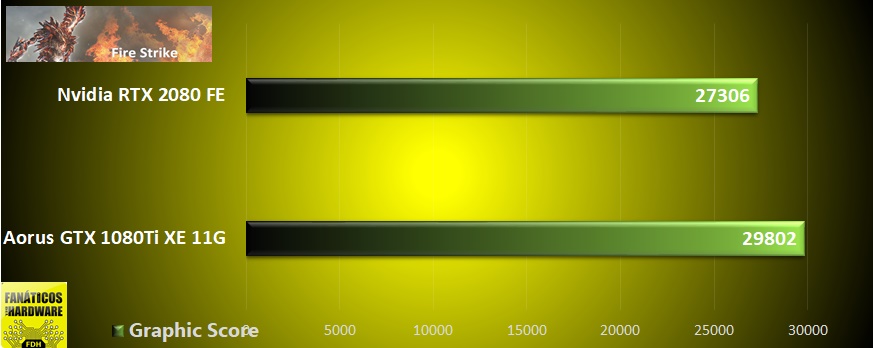

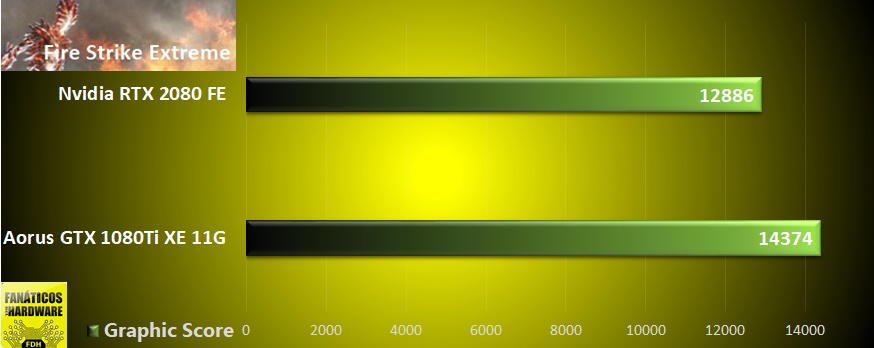

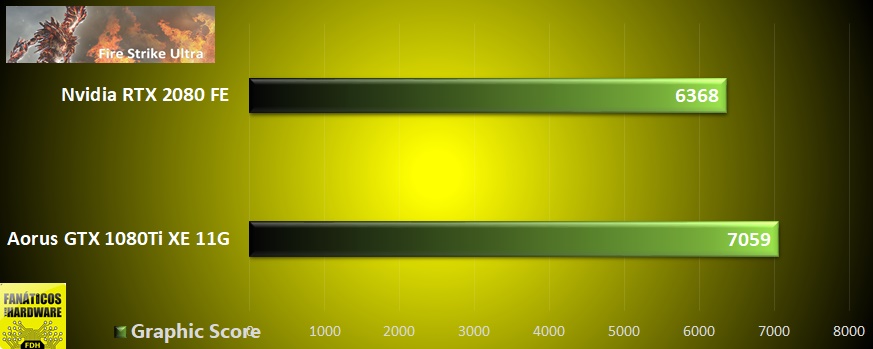

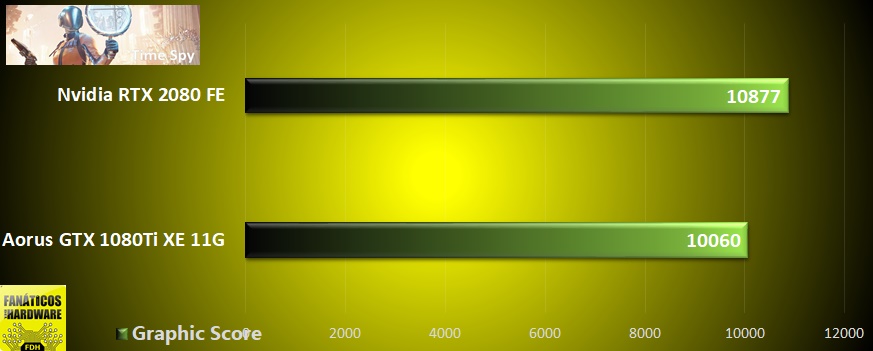

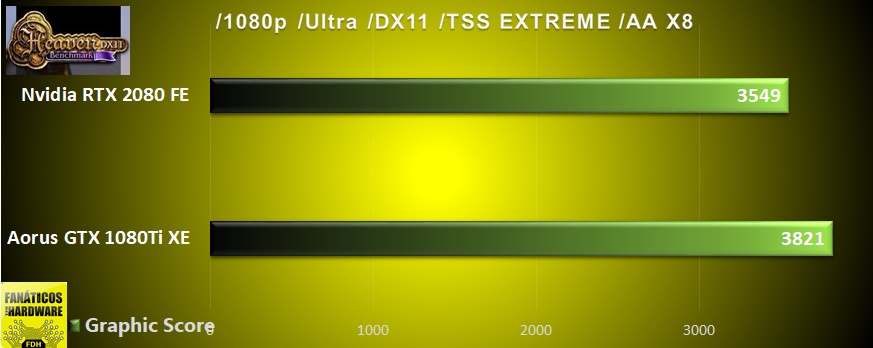

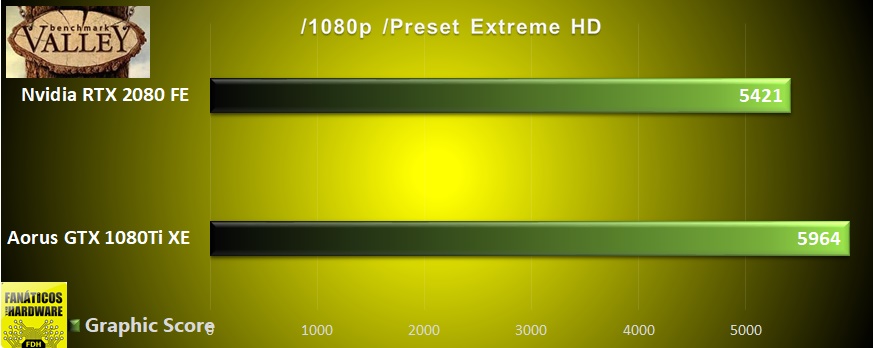

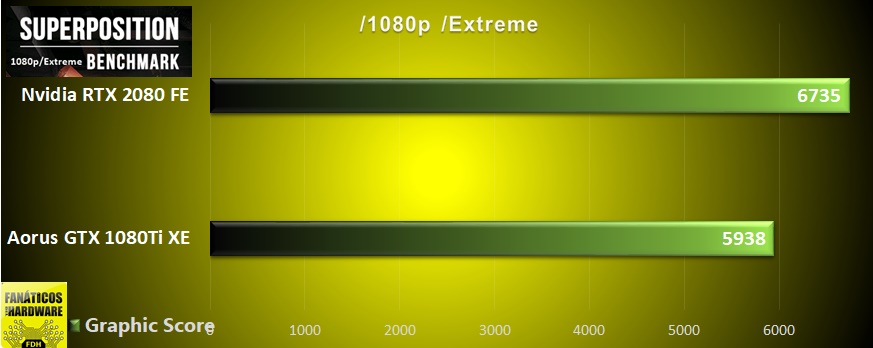

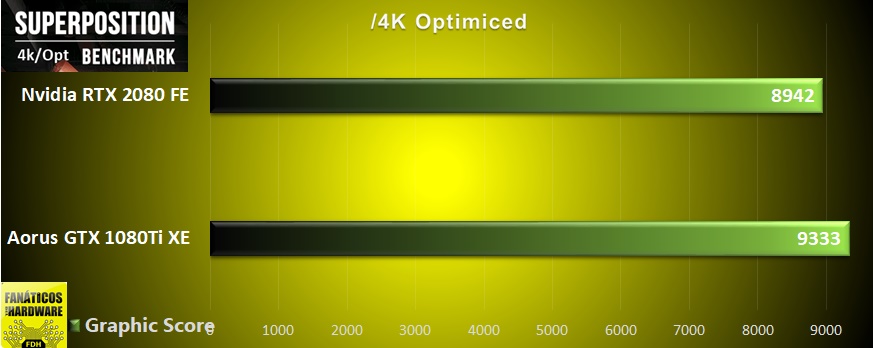

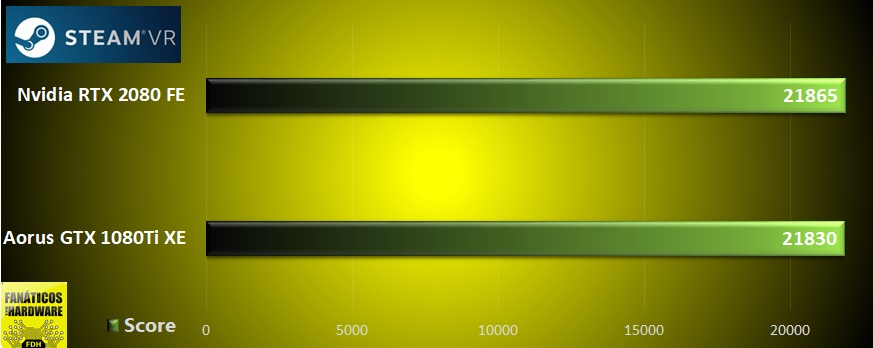

Como se puede ver en el resultado de las pruebas la RTX 2080 queda por detrás de la GTX 1080Ti en la mayoría de pruebas sintéticas, exceptuando TimeSpy, basado en la API DirectX12, la prueba Unigine Superposition con el preset 1080p/Extreme, mientras que en su preset 4k/optimized pierde, y en la prueba Steam VR Performance Test, donde la RTX 2080 demuestra estar ligeramente mejor preparada para la realidad virtual.

Pruebas en juegos

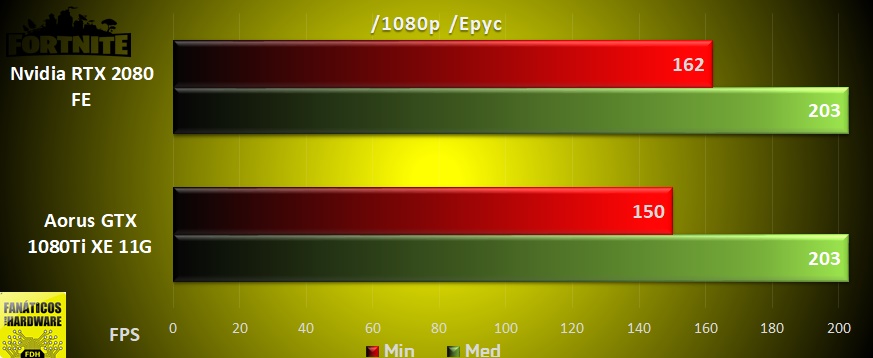

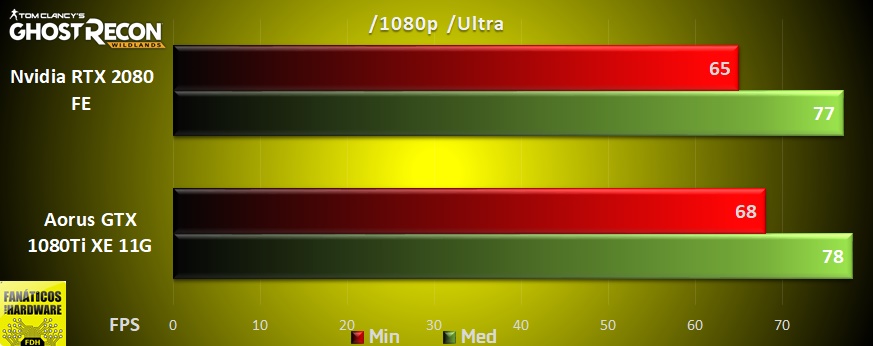

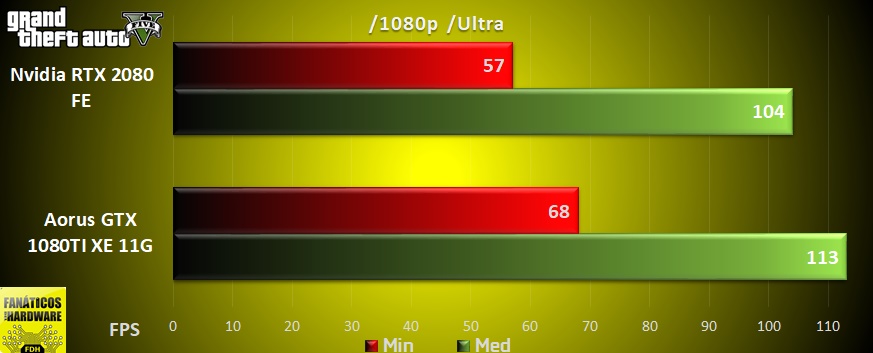

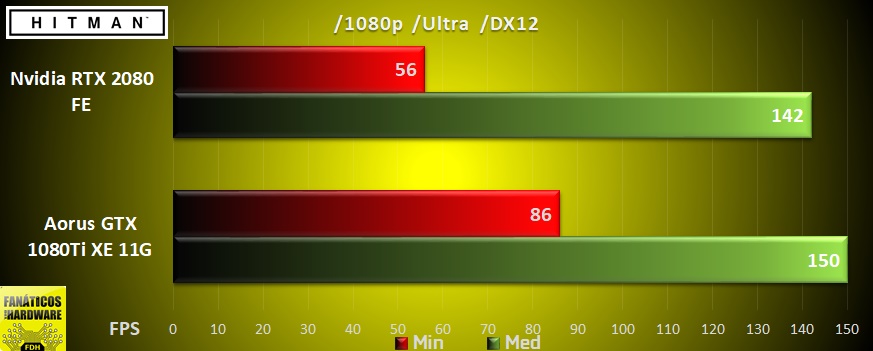

Las pruebas a 1080p se han realizado con un Intel Core i7 5960X junto a 32 Gb de RAM DDR 3200 CL14 en quad-channel y con un AMD Ryzen 7 2700 con 16 Gb de RAM a la mismas frecuencias/latencias en dual-channel, ambos procesadores de 8 núcleos / 16 hilos y funcionando a 4 GHz, y hemos elegido el mejor resultado en cada tarjeta gráfica con cada procesador, mientras que las pruebas a 1440p y 4K se han efectuado con un Intel Core i7 5930K de 6 núcleos / 12 hilos funcionando a 4,5 GHz junto a 16 Gb de RAM 3000 CL15 en quad-channel.

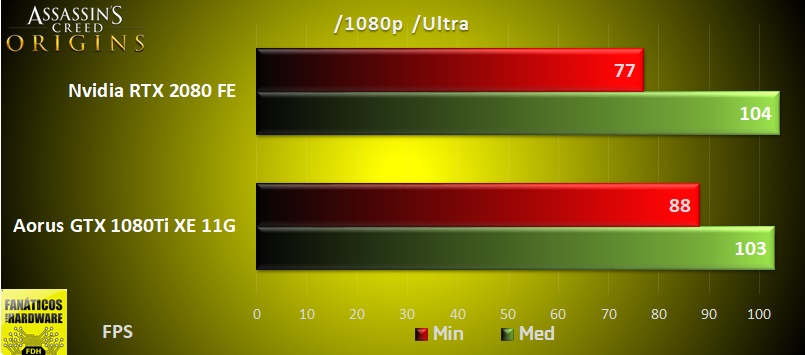

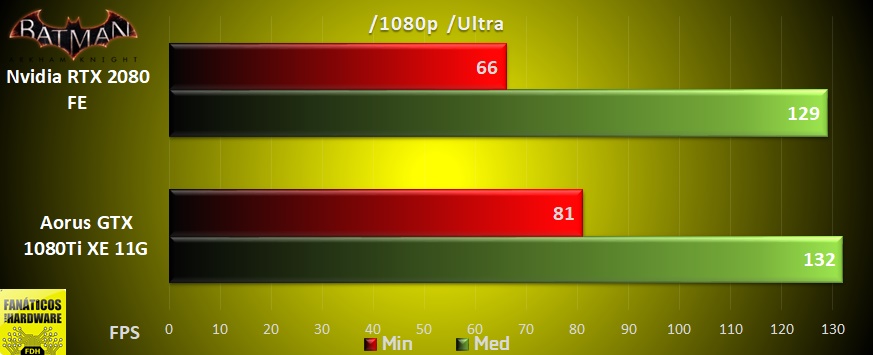

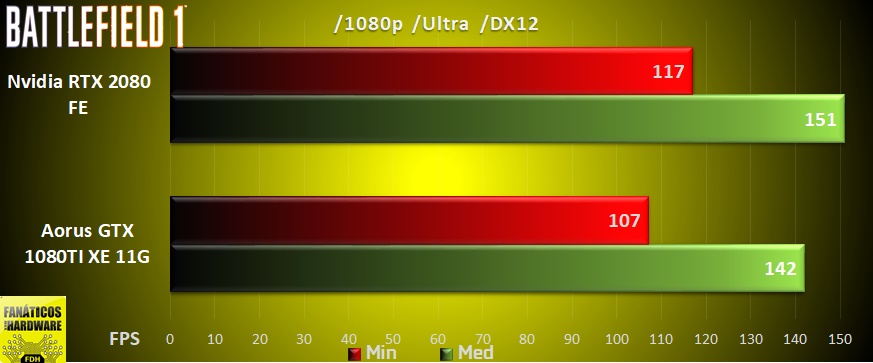

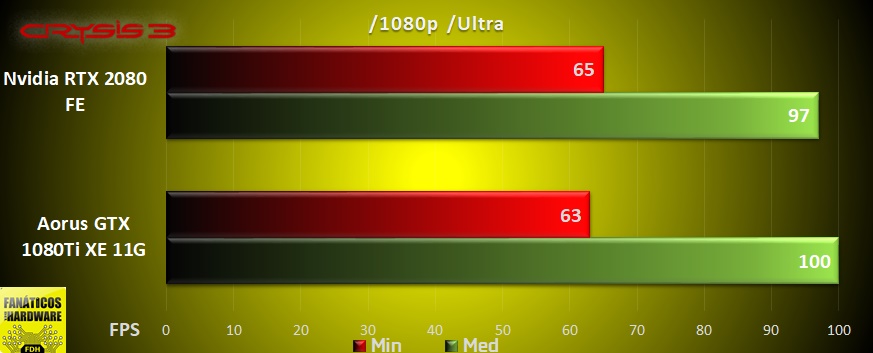

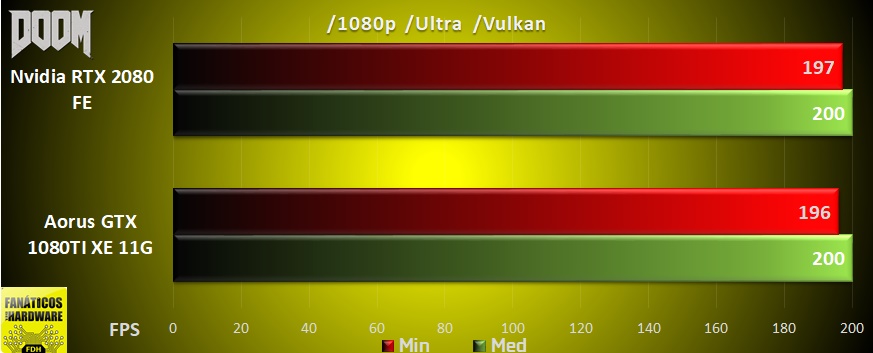

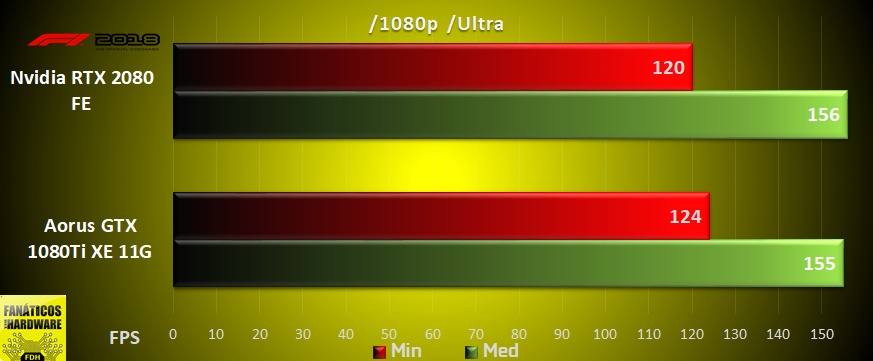

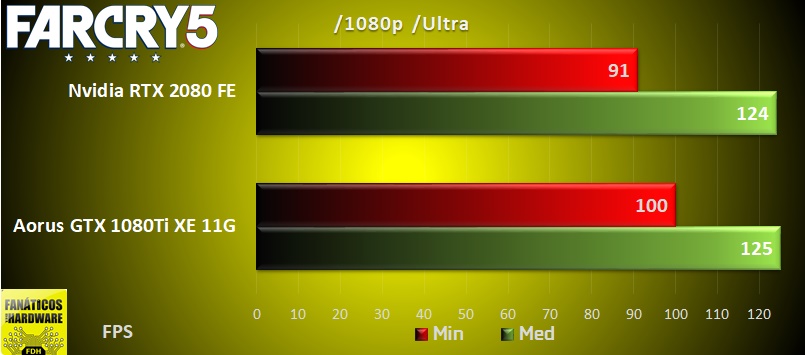

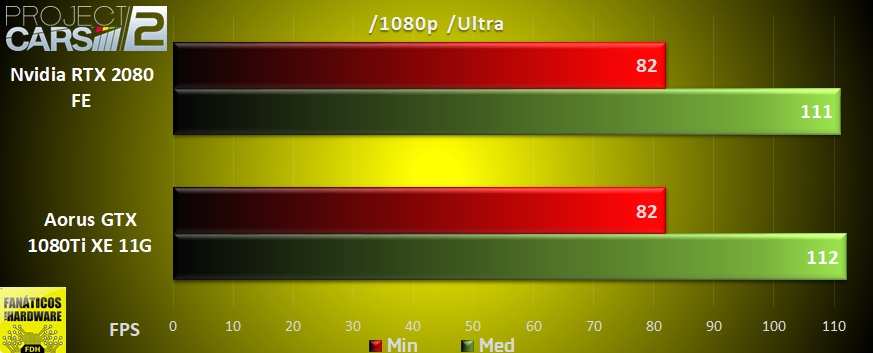

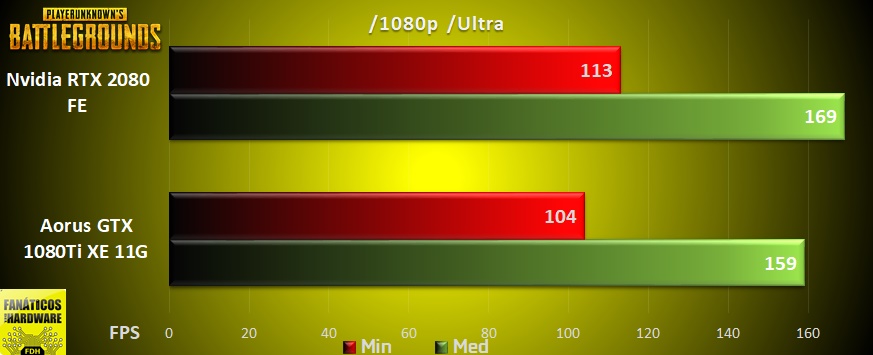

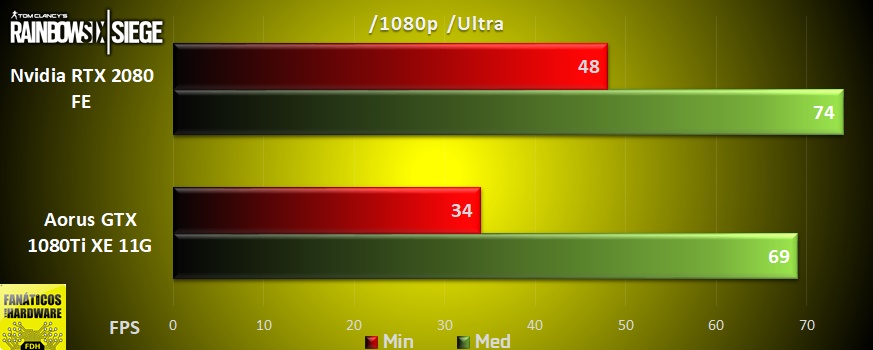

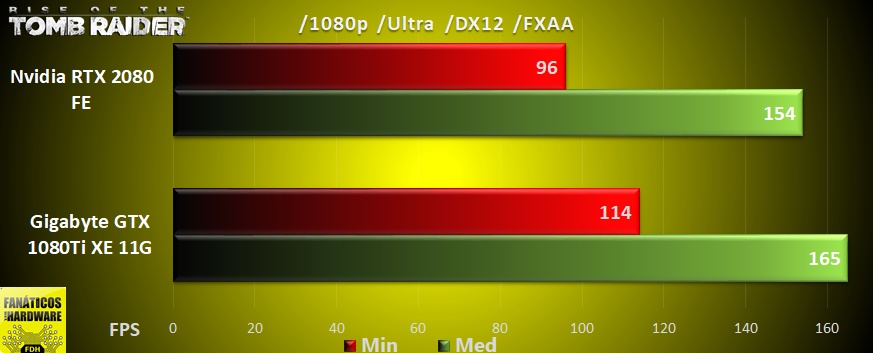

Pruebas 1080p

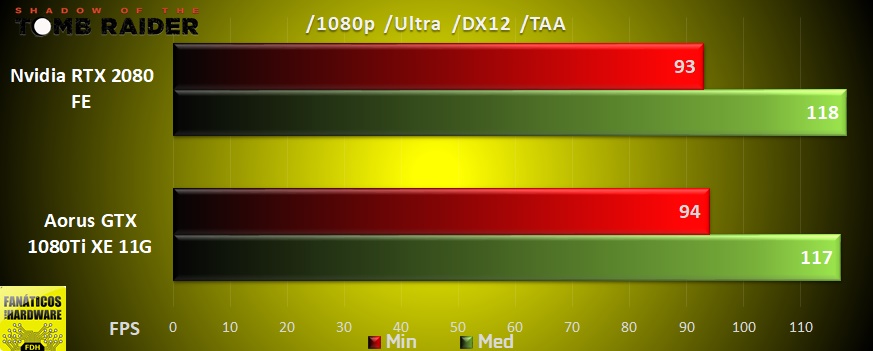

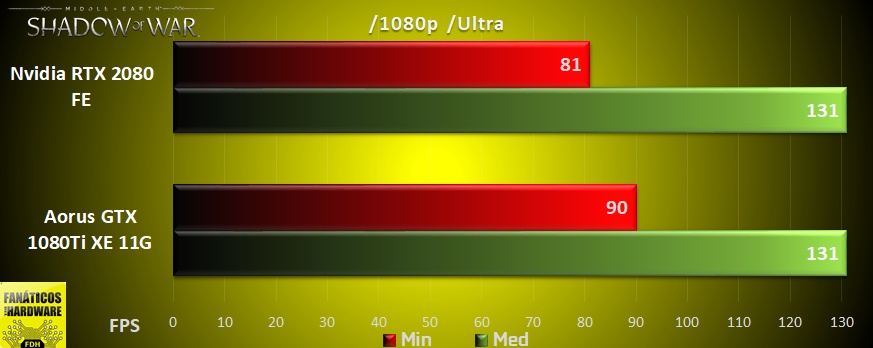

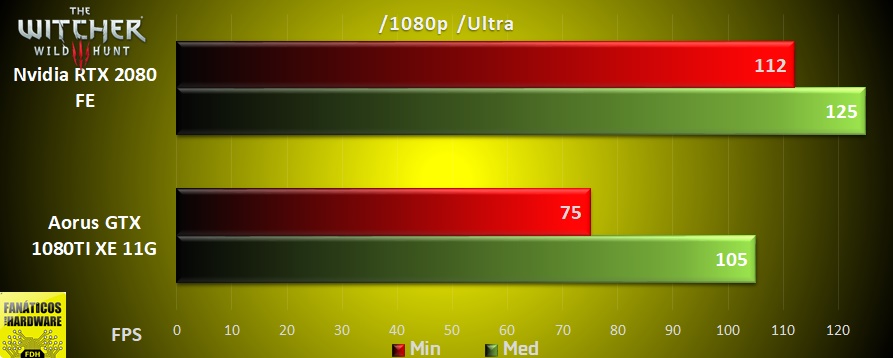

El resultado en las pruebas a resolución 1920×1080 nos da un empate en los FPS medios con la GTX 1080Ti venciendo en 5 titulos, la RTX 2080 venciendo en otros 5 y en el resto quedando en un empate (1 fps de diferencia de margen para empate), mientras que en los mínimos la GTX 1080Ti gana por un titulo.

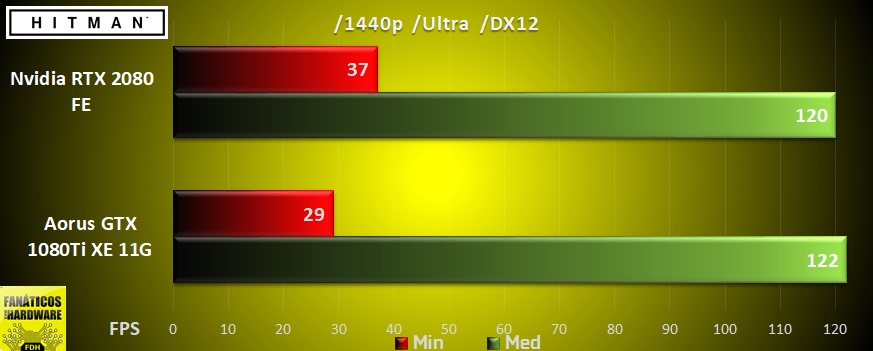

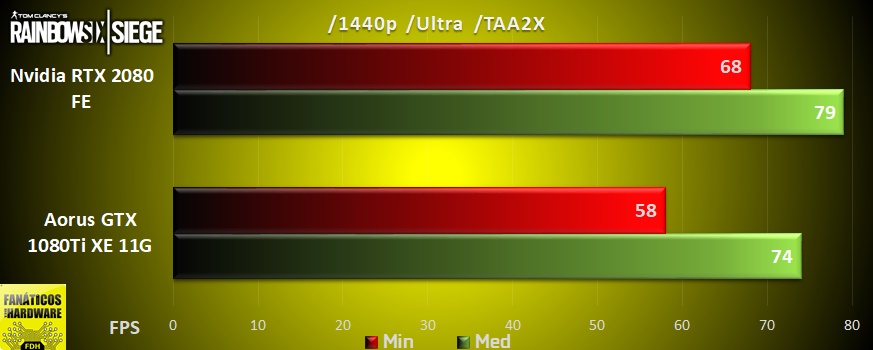

Se puede apreciar que los títulos bajo la API DirectX 12 favorecen a la RTX 2080, al igual que todos los títulos de Ubisoft y The Witcher 3 con las tecnologías GameWorks activadas al máximo.

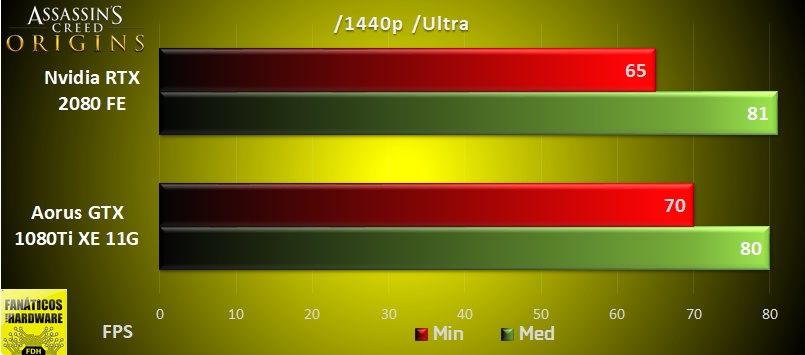

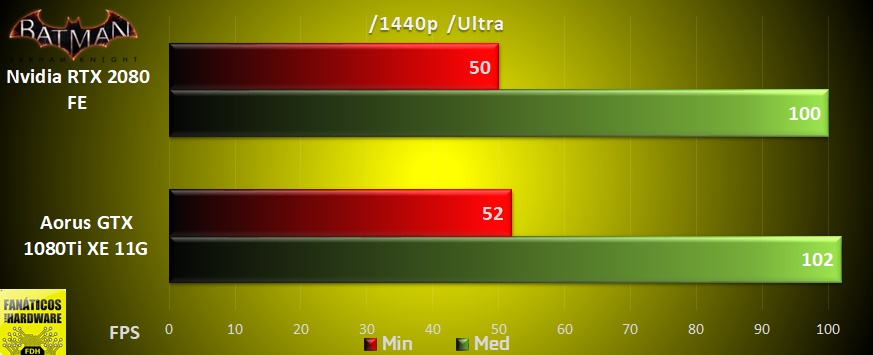

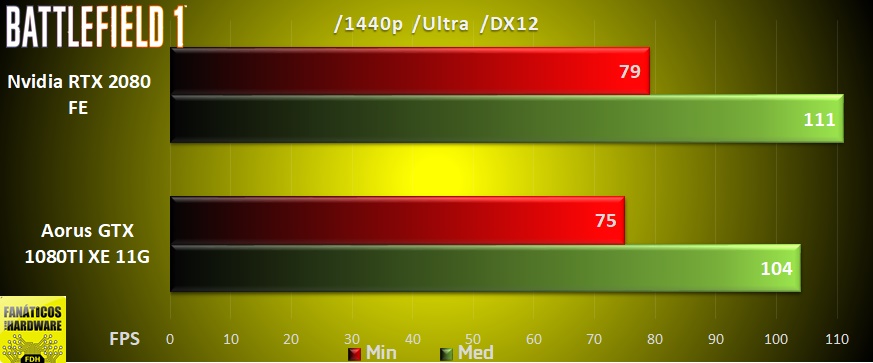

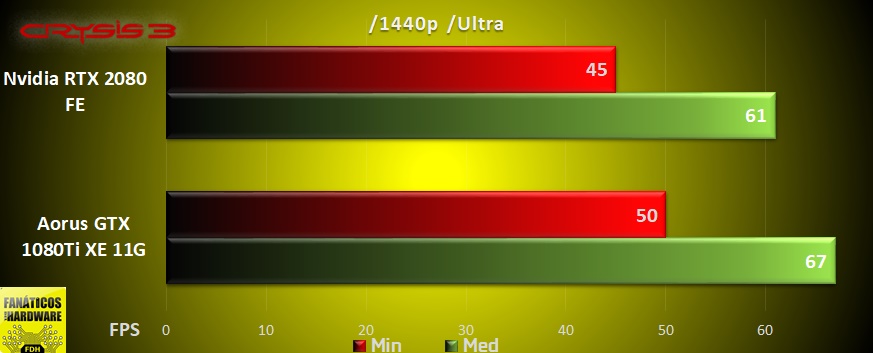

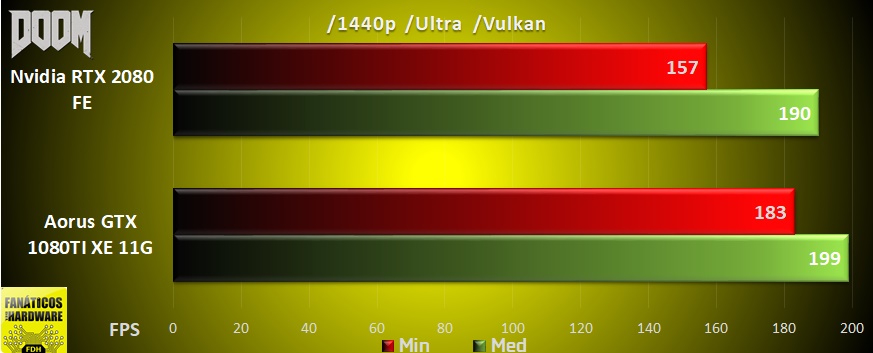

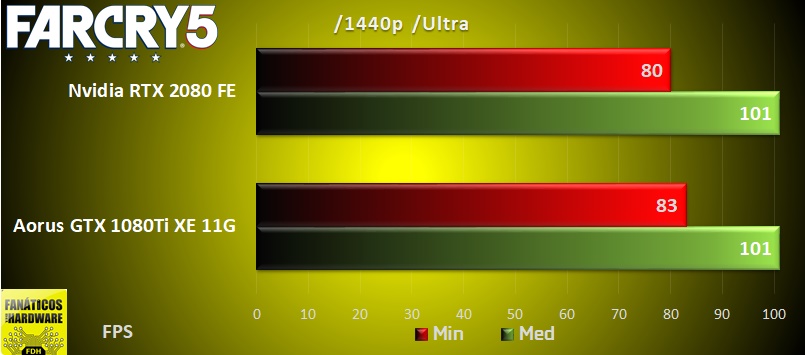

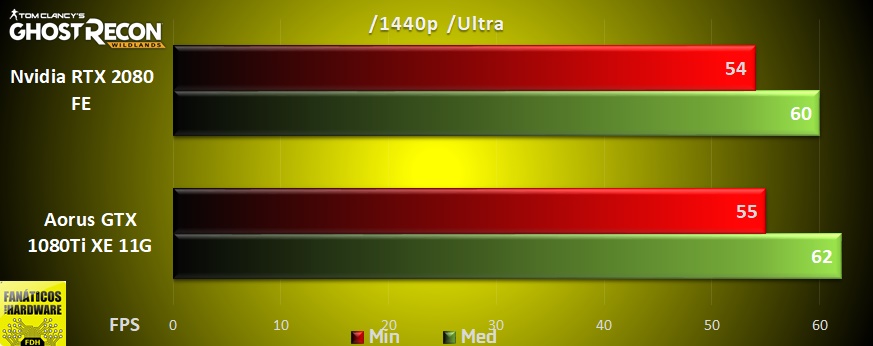

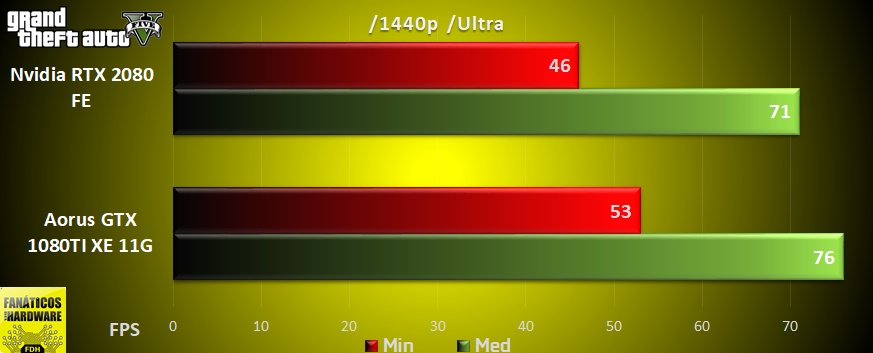

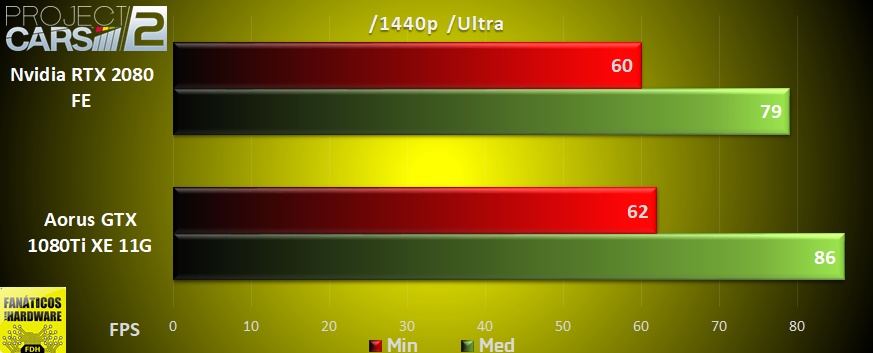

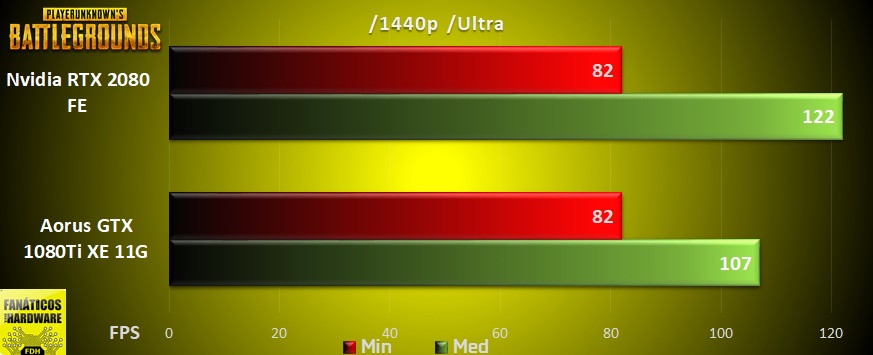

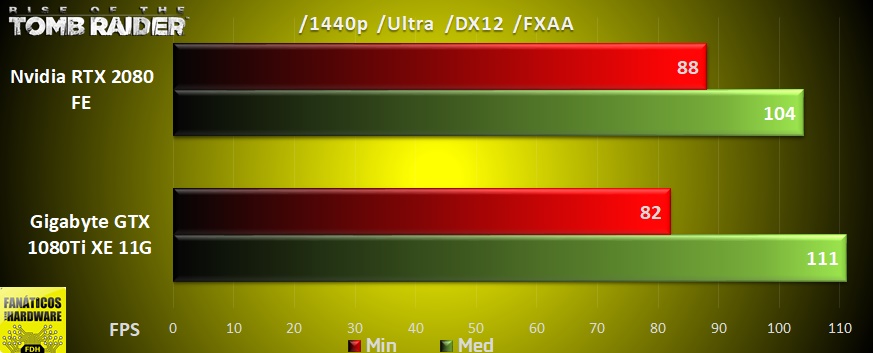

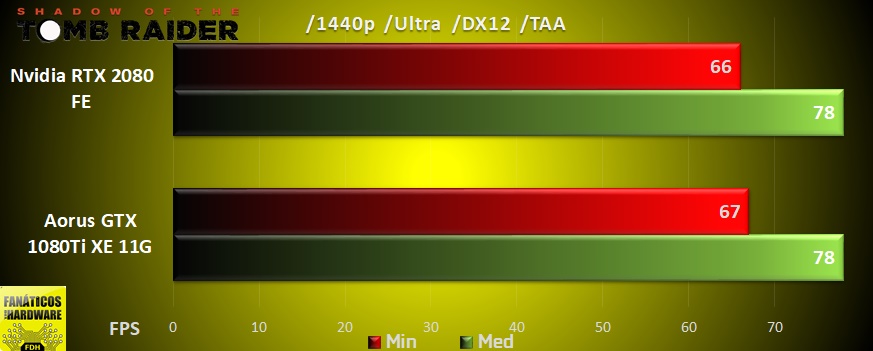

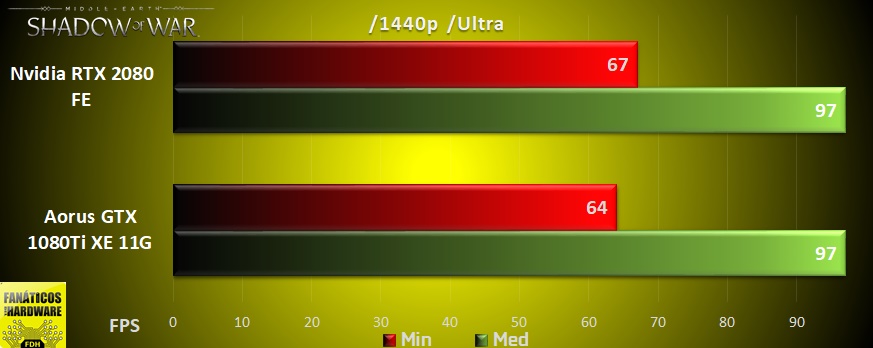

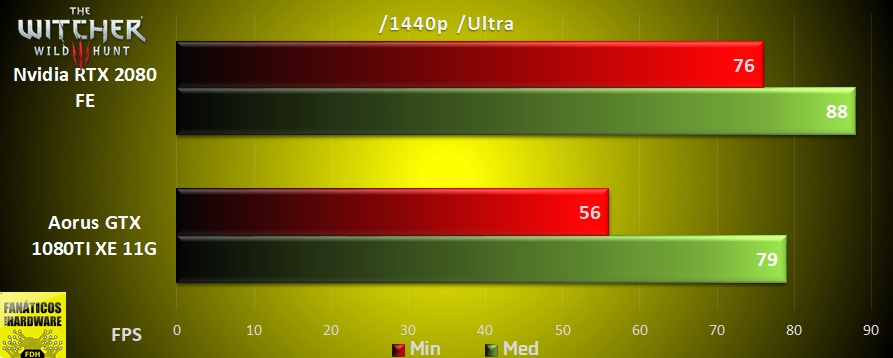

Pruebas 1440p

El resultado en las pruebas a resolución 2560×1440 arroja como clara vencedora en los FPS medios a la GTX 1080Ti, ganando en 9 títulos, mientras que la RTX 2080 vence en 4 títulos, uno de ellos DirectX12 (BF1), otro de Ubisoft (R6) y en The Witcher 3 junto a PUBG, quedando en empate en los 3 títulos restantes, en FPS mínimos repite como vencedora la GTX 1080Ti pero por un solo titulo de ventaja.

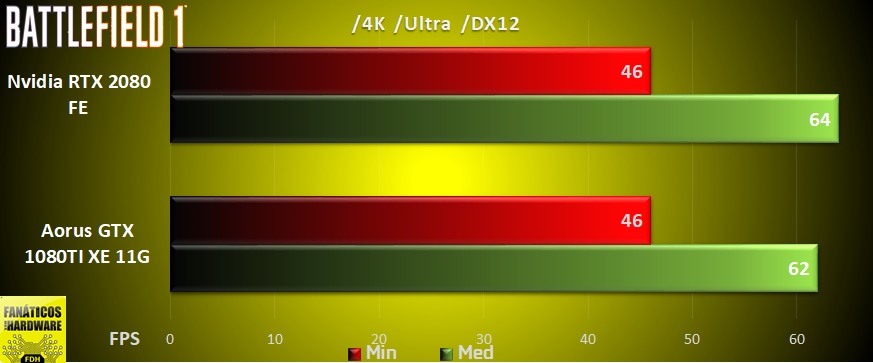

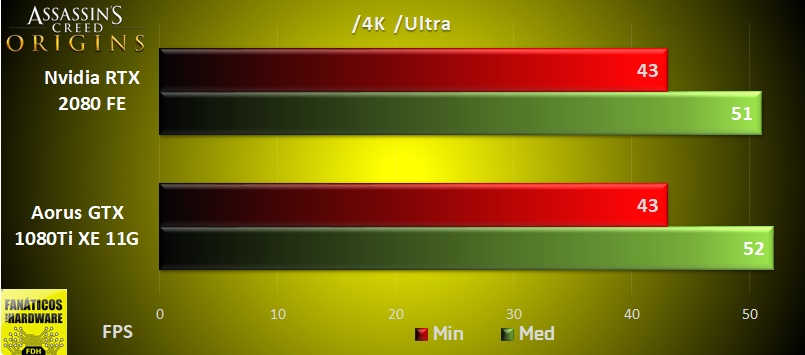

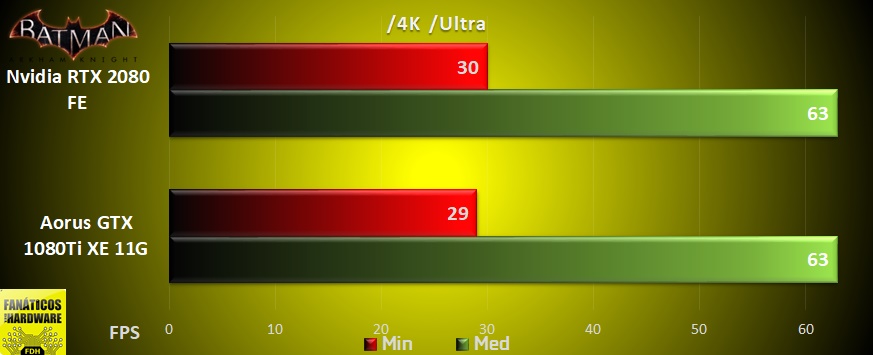

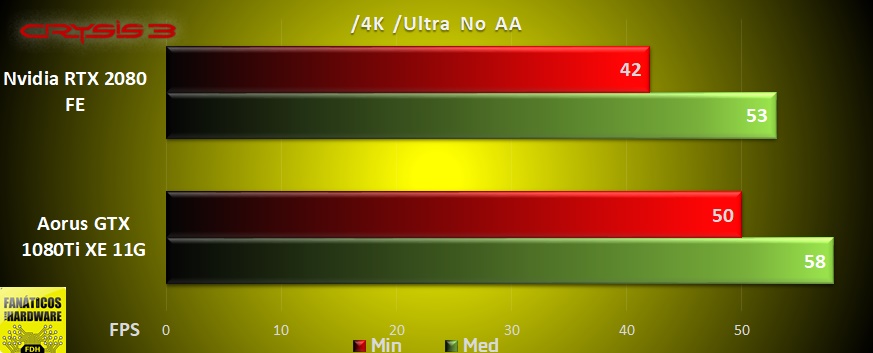

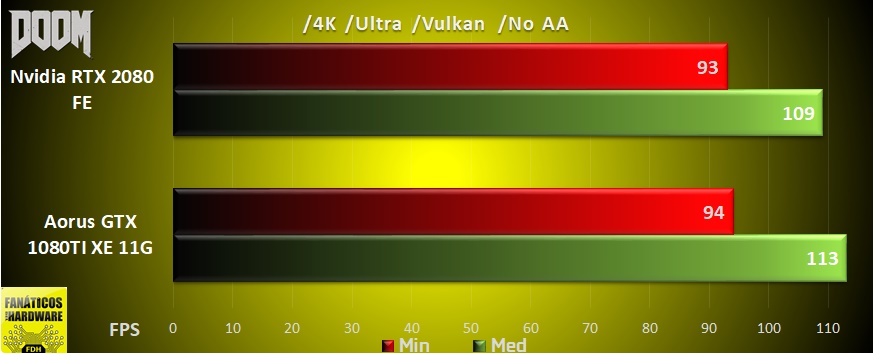

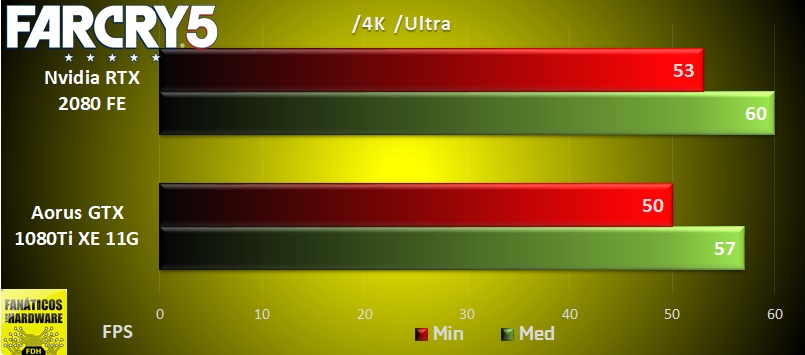

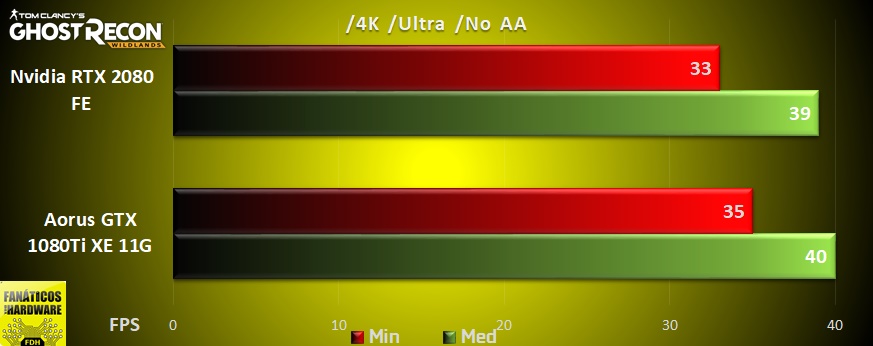

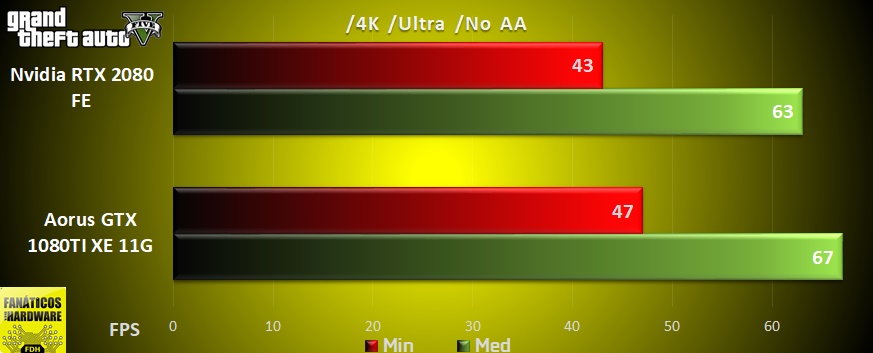

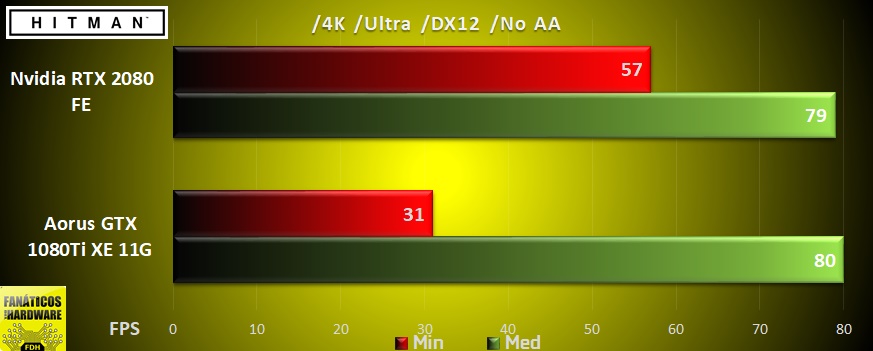

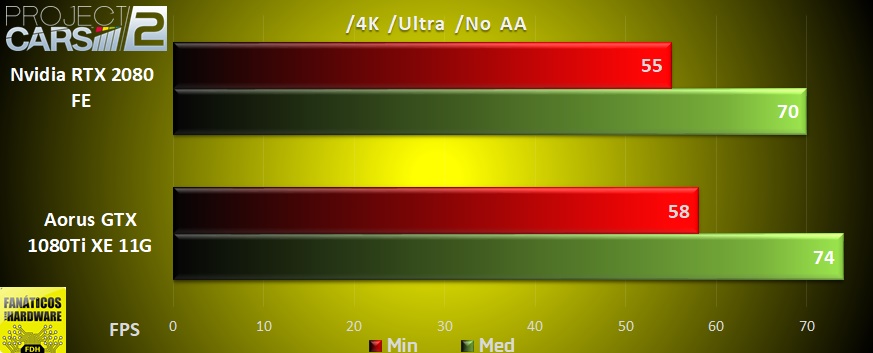

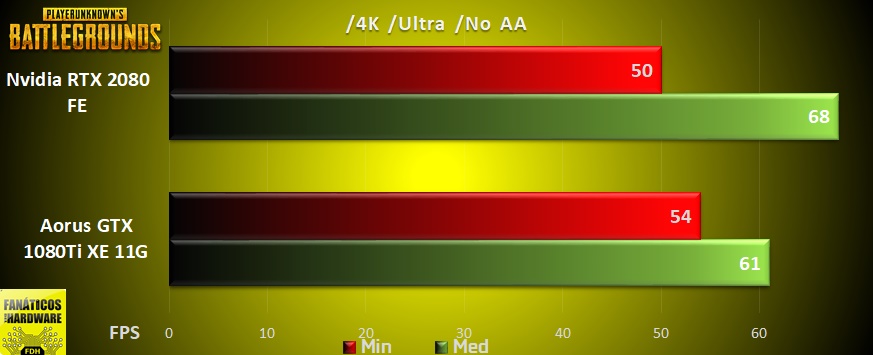

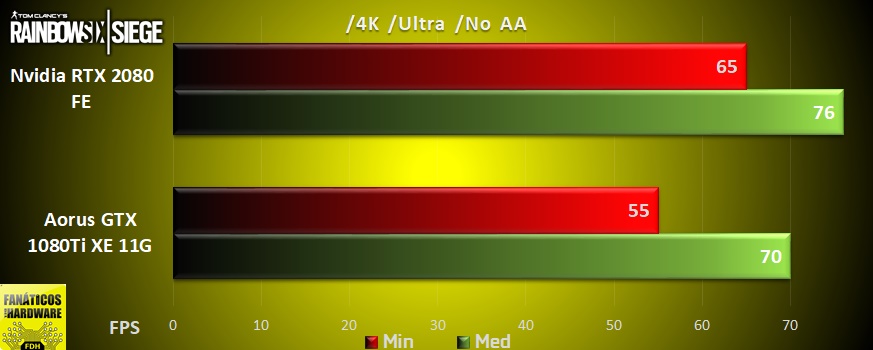

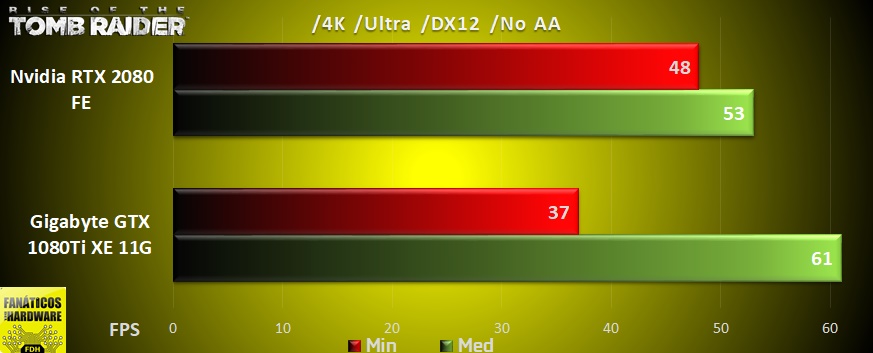

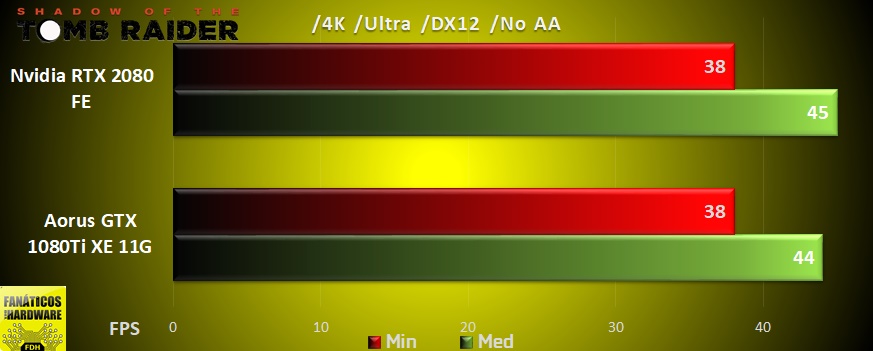

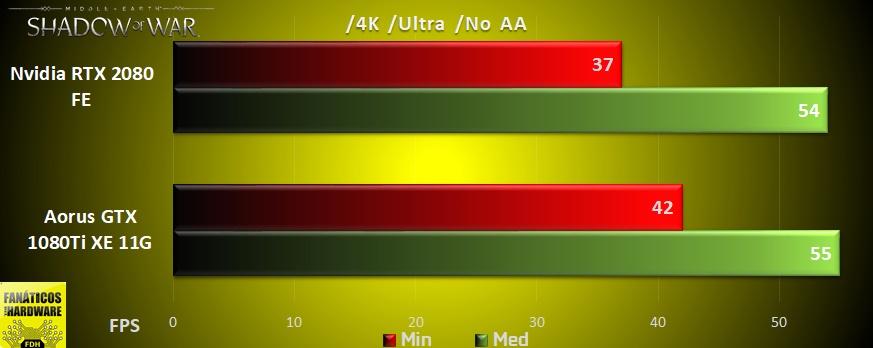

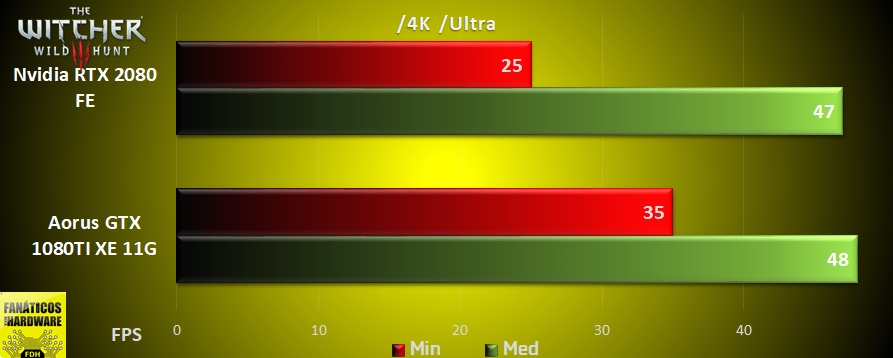

Pruebas 4K

A resolución 4K la RTX 2080 vuelve a quedar en segundo lugar frente a la GTX 1080Ti, ganando en 4 titulos, perdiendo en 6 y quedando empate en el resto de los FPS medios, aunque donde mas se ha resentido la RTX 2080 ha sido en los FPS mínimos, perdiendo en 8 títulos y ganando únicamente en 4, quedando en empate en los 2 restantes.

También cabe destacar que en muchos casos las diferencias en el rendimiento han sido mínimas, aunque la tendencia hacia el futuro es que los títulos vayan adoptando la API DirectX12, lo que marcara una diferencia a favor de la RTX 2080 comparada con la GTX 1080Ti.

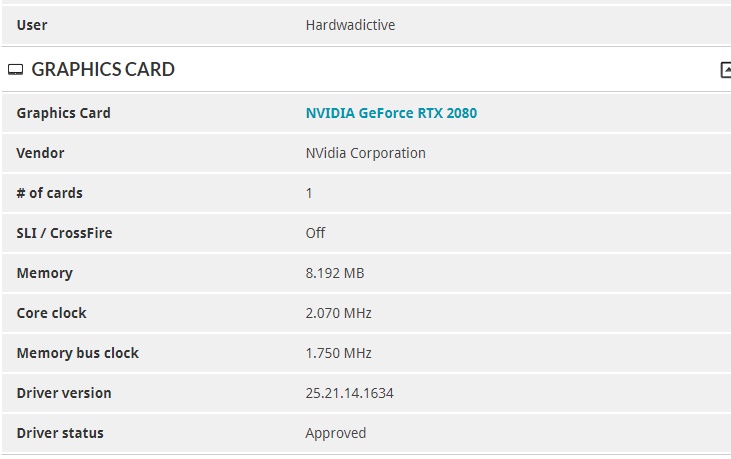

Overclock

Otra de las nuevas características de esta nueva arquitectura es la herramienta para hacerle overclock que Nvidia ha distribuido a sus socios, en nuestro caso hemos empleado el EVGA Precission X1 el cual ya la trae incorporada y con la que en dos sencillos pasos el programa automáticamente chequea cual es la mejor frecuencia en relación a su voltaje/temperatura para cada situación, gracias a ella hemos conseguido elevar el núcleo de la RTX 2080 hasta los 2070 MHz, aunque esta frecuencia se reduce automáticamente cuando la temperatura se va a aproximando a los 60º.

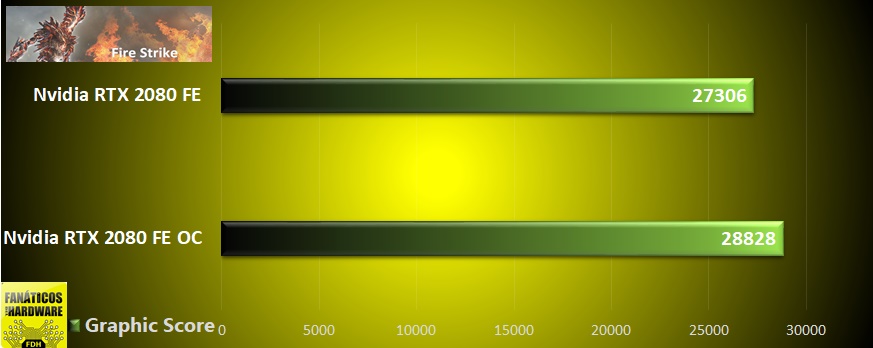

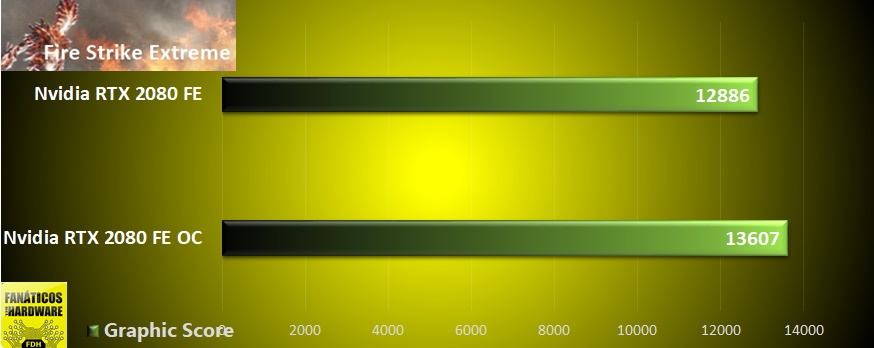

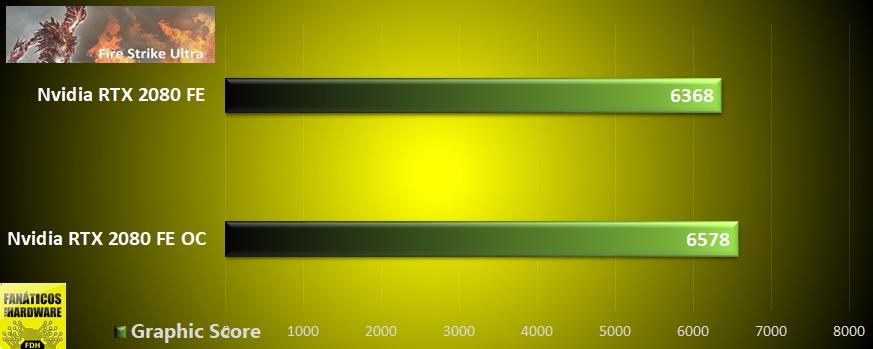

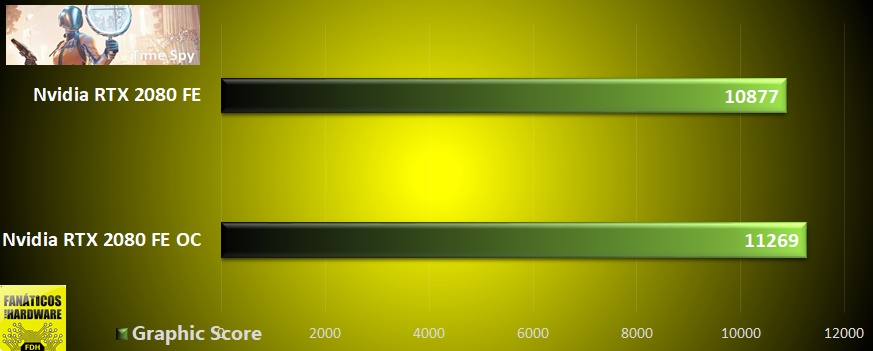

La mejora de rendimiento obtenida es de casi 1500 puntos en el test gráfico del benchmark FireStrike, poco mas de 700 puntos en el test FireStrike Extreme y de poco mas de 200 puntos en su versión FireStrike Ultra, mientras que en TimeSpy la mejora es de poco menos de 400 puntos.

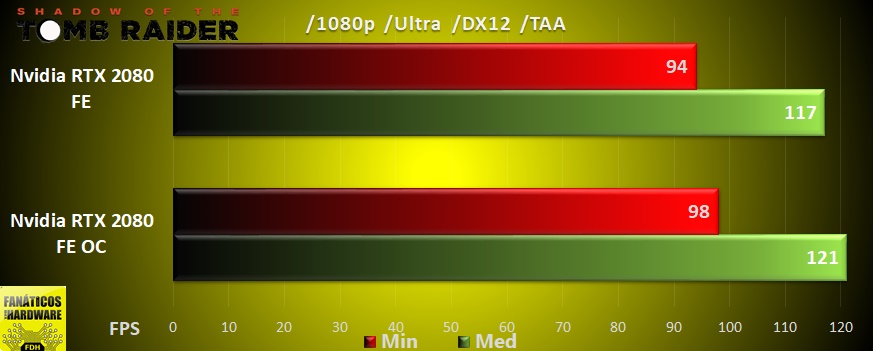

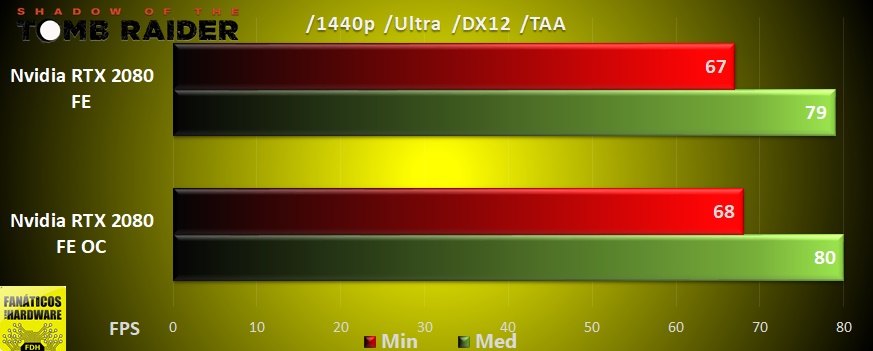

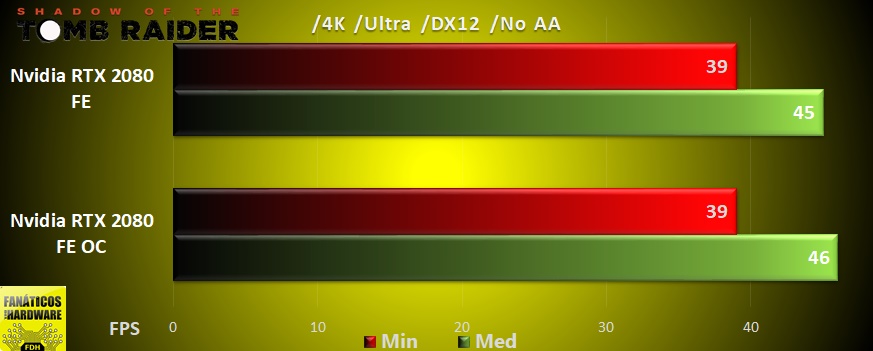

Esta mejora de rendimiento se traduce en juegos como el Shadow of Tomb Raider en un aumento de 4 FPS a resolución 1080p, y de un único FPS de mejora a resolución 1440p y 4K.

Temperatura y sonoridad

Con el overclock automático aplicado hemos pasado el Furmark a resolución 4K con el filtro 8X MSAA durante 9 minutos alcanzando una temperatura máxima de 72º, aunque por normal general es muy raro verla por encima de 70º, principalmente debido a que va reduciendo su frecuencia conforme la temperatura va aumentando.

Mientras que la sonoridad de sus ventiladores bajo carga se mantiene dentro de lo que podríamos decir parámetros normales por debajo de las 2000 RPM, siendo ligeramente mas audible que la Aorus GTX 1080Ti.

Conclusión

Como hemos podido ver en las pruebas y gracias las nuevas tecnologías que incorpora, la RTX 2080 tiene un futuro prometedor, pero un presente muy oscuro, principalmente debido a su precio, el cual ronda los 850€, encontrando a la GTX 1080Ti con un rendimiento prácticamente idéntico, incluso superior en algunos casos a un menor precio.

Por lo que ante esta situación es difícil recomendar esta tarjeta gráfica a los usuarios que normalmente suelen adquirir las series X80 de Nvidia, como pueden ser por ejemplo aquellos que actualmente contemplasen la posibilidad de actualizar sus GTX GTX 980 a una nueva generación después de 4 años, los cuales pagaron aproximadamente 550€ por una tarjeta gráfica superior a la GTX 780Ti, siendo la mas potente de la generación anterior, o los usuarios que actualmente posean una GTX 1080 y hallan estado esperando dos años a la nueva generación con la esperanza de adquirir una tarjeta gráfica de la serie x80 con un rendimiento superior al de la GTX 1080Ti con un precio mas reducido al de esta, pues la diferencia de rendimiento y de precio no justifica de ninguna manera adquirir actualmente una RTX 2080 en vez de una GTX 1080Ti.

Y su rendimiento no es que sea malo, todo lo contrario, esta a la altura de toda una GTX 1080Ti, aunque en ese aspecto deje algo que desear comparado con transiciones entre anteriores arquitecturas, es una tarjeta gráfica que se mueve con soltura a resolución 1440p, superando en algunas ocasiones los 100 FPS con todas las opciones gráficas al máximo, y que se queda muy cerca de los 60 FPS a resolución 4K omitiendo los filtros antialiasing.

Quizás para principios de año y tras vaciar gran parte de los almacenes con las tarjetas gráficas Pascal que quedan todavía por vender su valor baje a lo que podríamos decir una buena relación precio/rendimiento, y entonces podamos recomendar su compra.

Como conclusión podemos decir que la RTX 2080 es el resultado de la falta de competencia que actualmente hay en el mercado de las tarjetas gráficas, donde Nvidia con Volta ya se dio cuenta de que no necesita invertir en tecnologías para incrementar la potencia de sus GPUs, pues no lo necesita para mantenerse por encima de sus competidores, algo que tiene pinta de que va a durar bastante tiempo, por lo que viendo la situación ha decidido que es el momento de invertir en tecnologías para acercar el futuro del realismo gráfico al mercado del consumidor de a pie, quizás parezca un futuro demasiado precipitado, pero también hay que tener en cuenta de que nos llega dos años y medio después del lanzamiento de su anterior arquitectura Pascal.

Antes de terminar con la review quisiéramos agradecer a Nvidia la confianza puesta en nosotros al dejarnos la RTX 2080 para su análisis.

Fanáticos del Hardware otorga la medalla de PLATA a la Nvidia RTX 2080 Founders Edition pero no por que se la considere un mal producto, si no por la mala relación rendimiento/precio que ofrece actualmente.