Microsoft ha presentado durante su conferencia Ignite un par de silicios con diseño personalizado concebidos para acelerar la IA y destacar en cargas de trabajo en la nube. El primero de los dos es el CPU Microsoft Azure Cobalt 100, un chip de 128 núcleos con un conjunto de instrucciones ARMv9 de 64 bits, implementado en un diseño cloud nativo que formará parte de la oferta de Microsoft.

Aunque no existen muchos detalles sobre la configuración, la compañía afirma que el objetivo de rendimiento es de hasta un 40% con respecto a la actual generación de servidores ARM que se ejecutan en la nube Azure. El SoC ha hecho uso de la plataforma ARM Neoverse CSS personalizada para Microsoft, presumiblemente con núcleos ARM Neoverse N2.

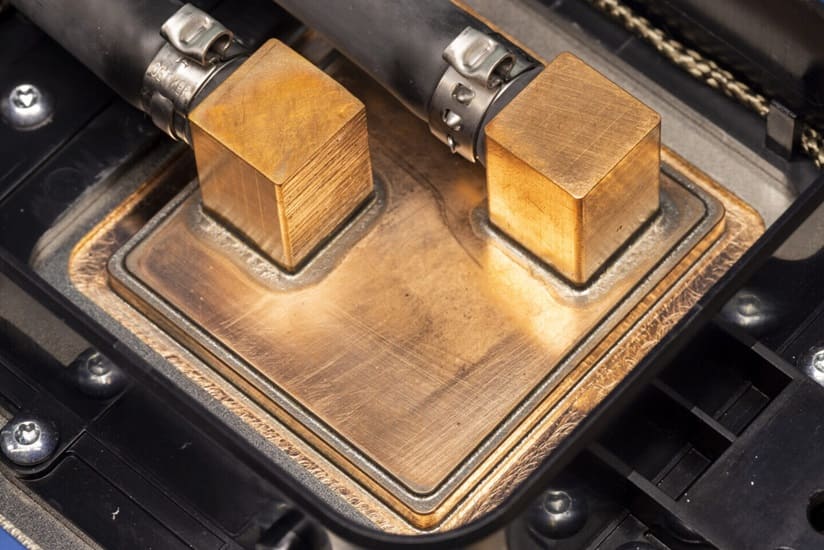

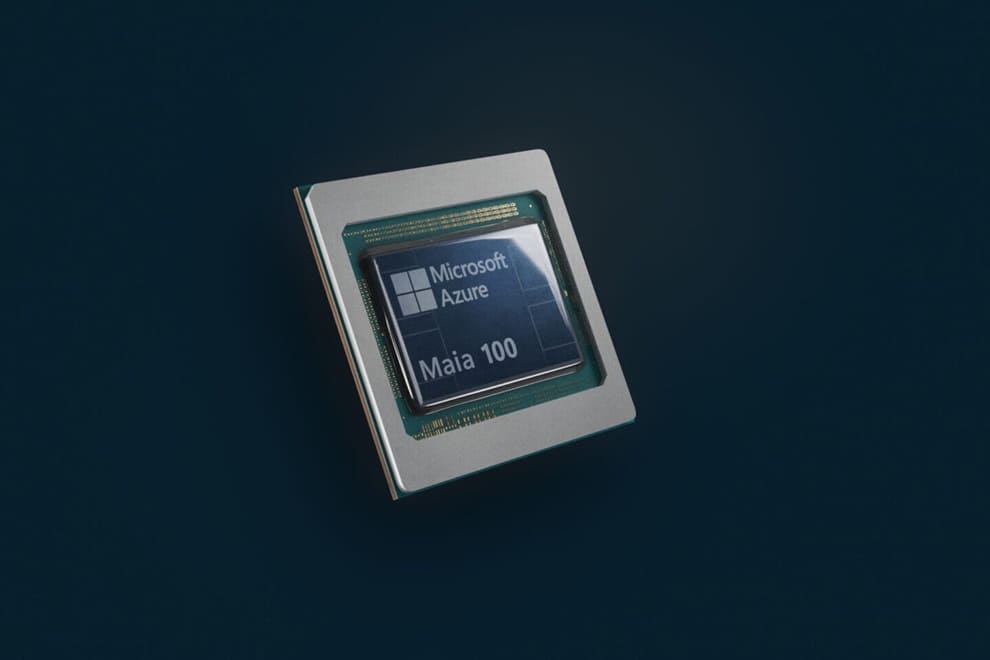

Otro de los temas más candentes en el ámbito de los servidores es la aceleración de la IA, necesaria para ejecutar los grandes modelos lingüísticos actuales. Microsoft alberga ChatGPT de OpenAI, Copilot de Microsoft y muchos otros servicios de IA. Para ayudar a que funcionen lo más rápido posible, el proyecto Athena de Microsoft pasa a denominarse acelerador de IA Maia 100, fabricado en el proceso de 5 nm de TSMC. Dispone de 105.000 millones de transistores y admite varios formatos de datos MX, incluso los inferiores a 8 bits, para proporcionar el máximo rendimiento.

Puesto a prueba actualmente en GPT 3.5 Turbo, todavía estamos por ver las cifras de rendimiento y las comparativas con el hardware de la competencia por parte de NVIDIA, como H100/H200 y AMD, con MI300X. El Maia 100 presenta un ancho de banda agregado de 4,8 Terabits por acelerador, que se sirve de un protocolo de red personalizado basado en Ethernet para el escalado. Se prevé que dichos chips lleguen a los centros de datos de Microsoft a principios del próximo año, con lo que esperamos obtener próximamente ciertos datos sobre su rendimiento.

Vía: TechPowerUp