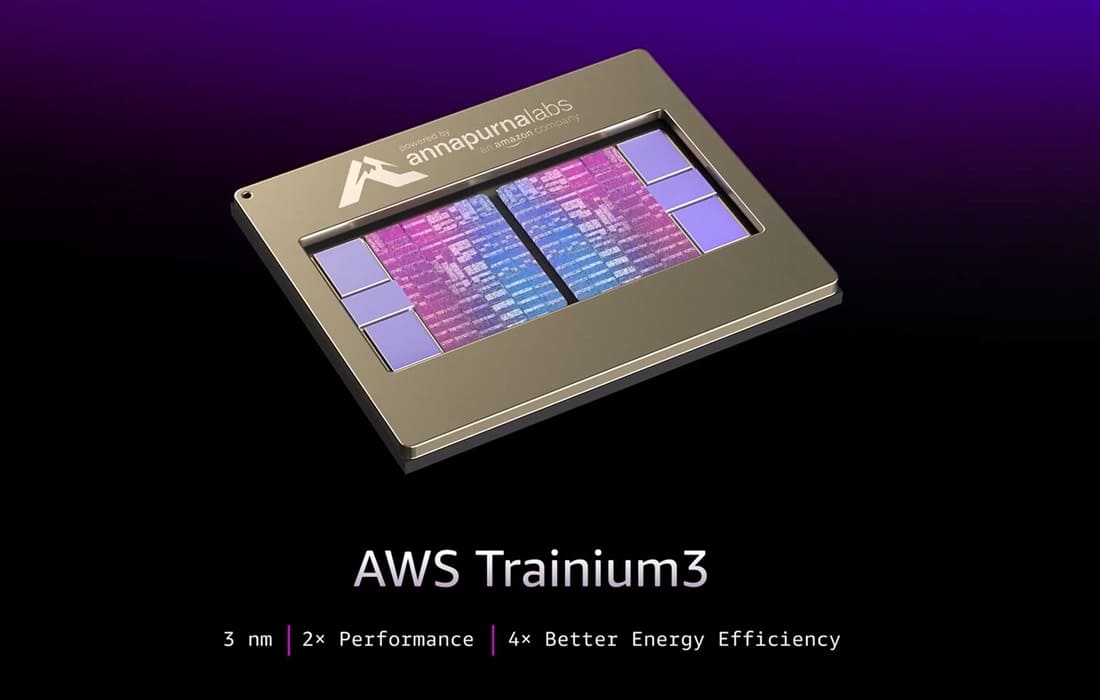

AWS ha presentado durante su conferencia re:Invent 2025 en Las Vegas su nuevo ASIC Trainium3, diseñado tanto para tareas internas de IA como para clientes externos de alto nivel. Este chip ofrece 2,52 PetaFLOPS de rendimiento FP8 por unidad, integrando 144 GB de memoria HBM3E con un ancho de banda de 4,9 TB/s. Desarrollado bajo el nodo N3 de 3 nm de TSMC, el Trainium3 introduce nuevos tipos de dato compactos (MXFP8 y MXFP4) que optimizan la relación entre memoria y cómputo para modelos multimodales y razonamiento de largo contexto.

El nuevo procesador soporta arquitecturas de modelos densos y expert-parallel, permitiendo una ejecución más eficiente de grandes redes neuronales. Gracias a su arquitectura personalizada, se reducen los cuellos de botella entre memoria HBM3E y núcleos Tensor, logrando un uso más equilibrado de los recursos en entornos de entrenamiento e inferencia de gran escala.

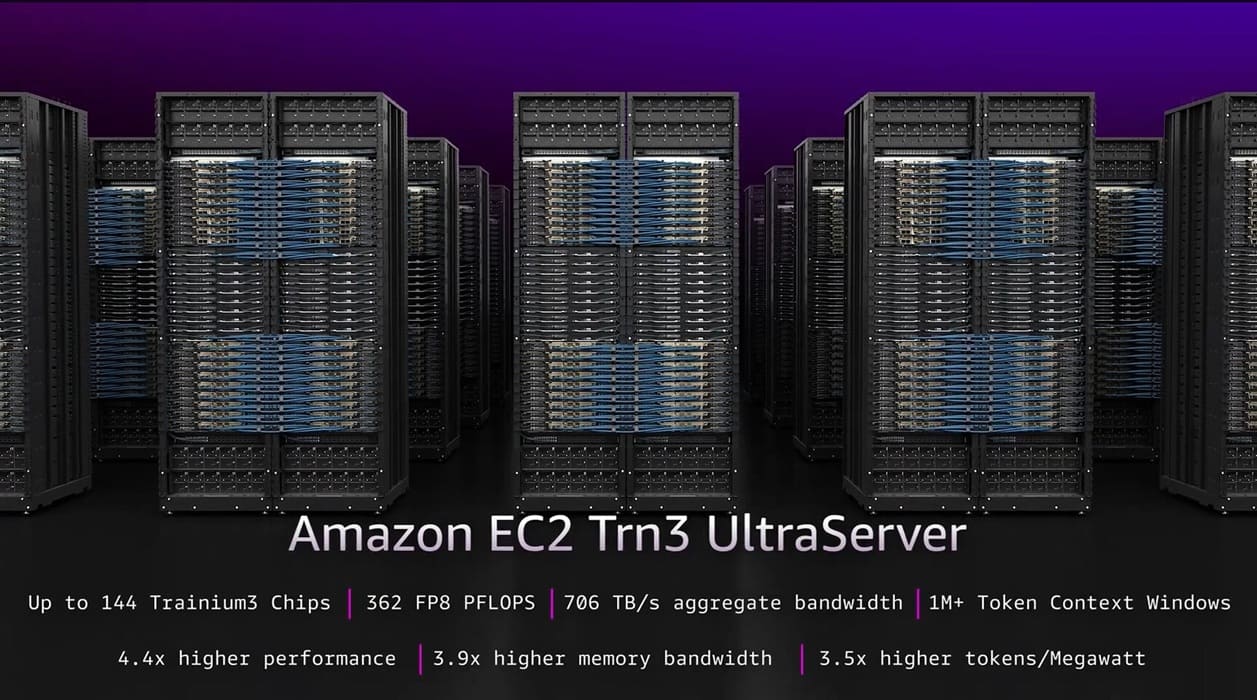

Escalabilidad masiva en Trn3 UltraServers

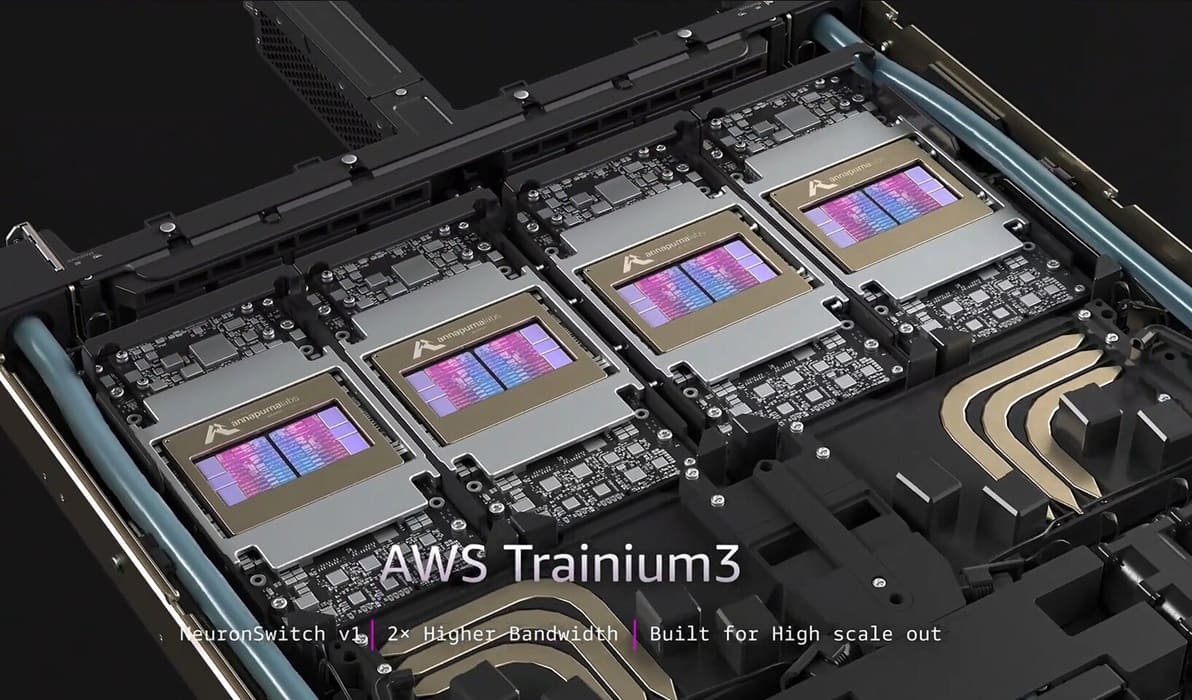

Los nuevos Trn3 UltraServers pueden escalar hasta 144 chips Trainium3 en una única unidad, alcanzando unos 362 PetaFLOPS FP8. Cada servidor integra 20,7 TB de memoria HBM3E y un ancho de banda agregado de 706 TB/s, lo que duplica las capacidades de la generación anterior. Además, el nuevo interconector NeuronSwitch-v1 mejora la comunicación entre chips con una ancho de banda 2 × superior.

Según AWS, el Trainium3 proporciona 4,4 × más rendimiento, 3,9 × más ancho de banda y 4 × mejor eficiencia energética frente al Trainium2, estableciendo un nuevo referente en rendimiento por vatio y reduciendo los costes operativos de entrenamiento masivo.

Hacia una infraestructura de IA más diversificada

El objetivo de Amazon Web Services con Trainium3 es ofrecer una alternativa real a las GPU de NVIDIA y AMD, reduciendo la dependencia del mercado respecto a estas arquitecturas. La compañía utiliza estos ASIC en sus propios modelos de IA y ya los pone a disposición de laboratorios externos, entre ellos Anthropic, que ha recibido una inversión de unos 8.000 millones de dólares. Con el salto al Trainium3, se esperan mejoras notables en rendimiento y eficiencia, abriendo la puerta a una adopción mayor de la infraestructura AWS para IA de gran escala.

Vía: TechPowerUp