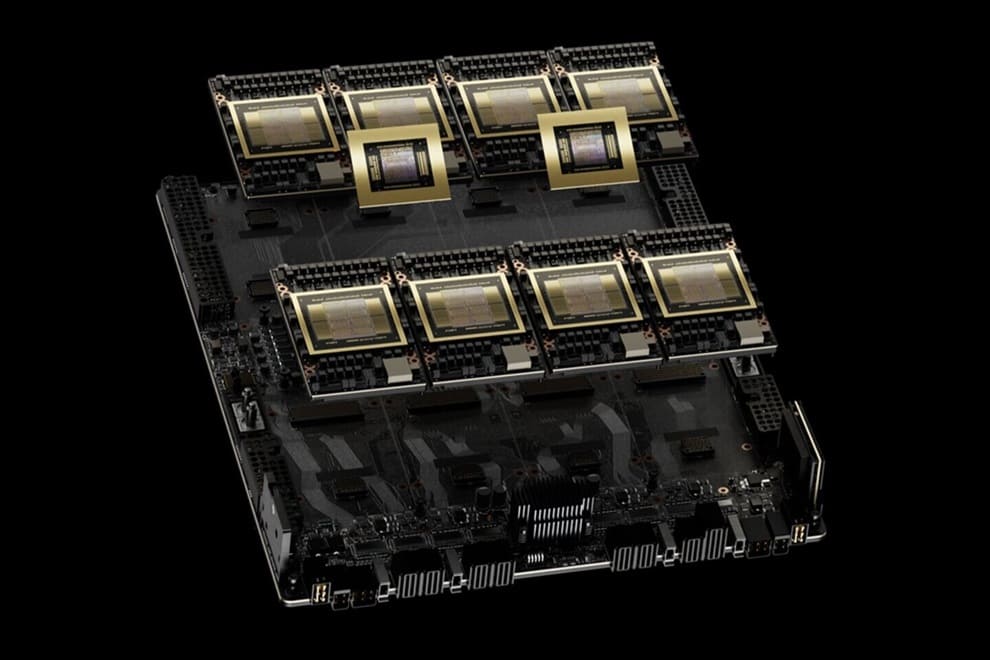

Según los últimos resultados de MLPerf Training v4.1, la plataforma HGX B200 Blackwell de NVIDIA ha demostrado un enorme incremento del rendimiento, con una mejora de hasta el doble por GPU con respecto a su predecesora, la HGX H200 Hopper.

Según los últimos resultados verificados por MLCommons, se han alcanzado importantes avances en el entrenamiento de grandes modelos lingüísticos (LLM). Gracias a la arquitectura Blackwell, dotada de memoria de gran ancho de banda HBM3e y tecnología de interconexión NVLink de quinta generación, se ha logrado duplicar el rendimiento por GPU en el preentrenamiento GPT-3 y duplicar el rendimiento en el ajuste fino de Llama 2 70B con respecto a la anterior generación, Hopper.

Cada uno de dichos equipos contaba con ocho GPUs Blackwell con un TDP de 1.000W, conectadas a través de NVLink Switch para facilitar el escalado.

Para ello, se utilizaron SuperNICs NVIDIA ConnectX-7 y switches InfiniBand Quantum-2, lo que permitió una comunicación de nodo a nodo de alta velocidad para las cargas de trabajo de entrenamiento distribuidas.

Si bien los anteriores equipos basados en Hopper requerían de 256 GPUs para optimizar el rendimiento en el benchmark GPT-3 175B, en el caso de Blackwell se logró la misma tarea con solamente 64 GPUs, gracias a la mayor capacidad y ancho de banda de su memoria HBM3e.

Un aspecto a tener en cuenta es el próximo equipo GB200 NVL72, que promete mejoras aún más significativas que el 2,2x. Presenta dominios NVLink ampliados, mayor ancho de banda de memoria y una estrecha integración con las CPUs NVIDIA Grace, todo ello complementado con las tecnologías de conmutación ConnectX-8 SuperNIC y Quantum-X800.

Gracias a una conmutación más veloz y un movimiento de datos mejorado con la inclusión de Grace-Blackwell, podríamos ver aún más optimizaciones a nivel de software por parte de NVIDIA para superar los límites del rendimiento.

Vía: TechPowerUp