La firma surcoreana ha desvelado su estrategia de próxima generación para memoria AI durante el SK AI Summit 2025, celebrado en Seúl los días 3 y 4 de noviembre. El encuentro, organizado por SK Group, reunió a expertos del sector y directivos de empresas globales para analizar los retos de la infraestructura de inteligencia artificial y la evolución de la memoria como elemento clave de rendimiento.

La nueva hoja de ruta eleva la ambición de SK hynix: pasar de ser un proveedor de memoria full-stack a un creador integral de soluciones AI. La compañía apuesta por un modelo colaborativo con socios tecnológicos y fabricantes de semiconductores para impulsar arquitecturas de memoria adaptadas a la expansión del ecosistema AI.

Estrategia de memoria AI y nuevas arquitecturas

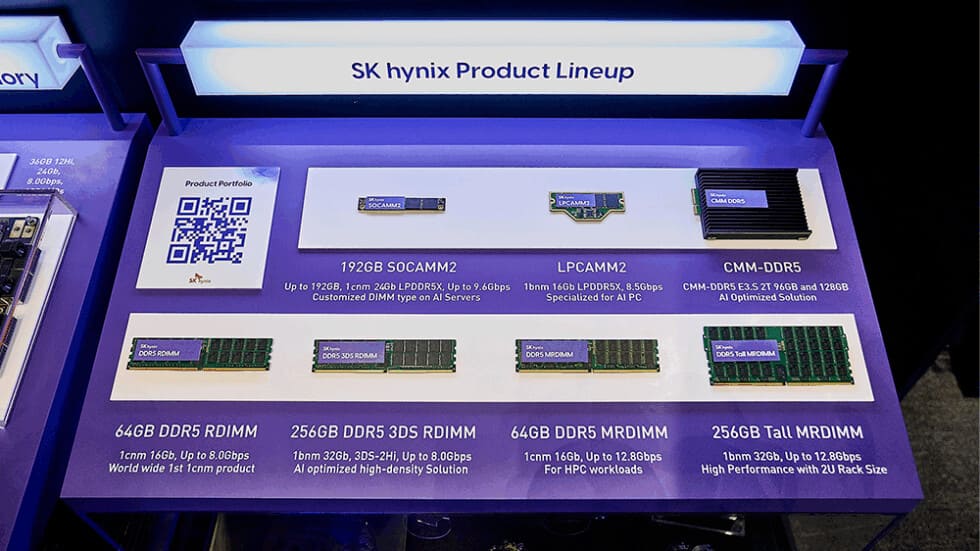

La propuesta de SK hynix se articula en torno a tres pilares: custom HBM, AI-DRAM (AI-D) y AI-NAND (AI-N). Cada línea aborda diferentes cuellos de botella del procesamiento AI actual, donde la transferencia de datos y la eficiencia energética se han convertido en factores críticos.

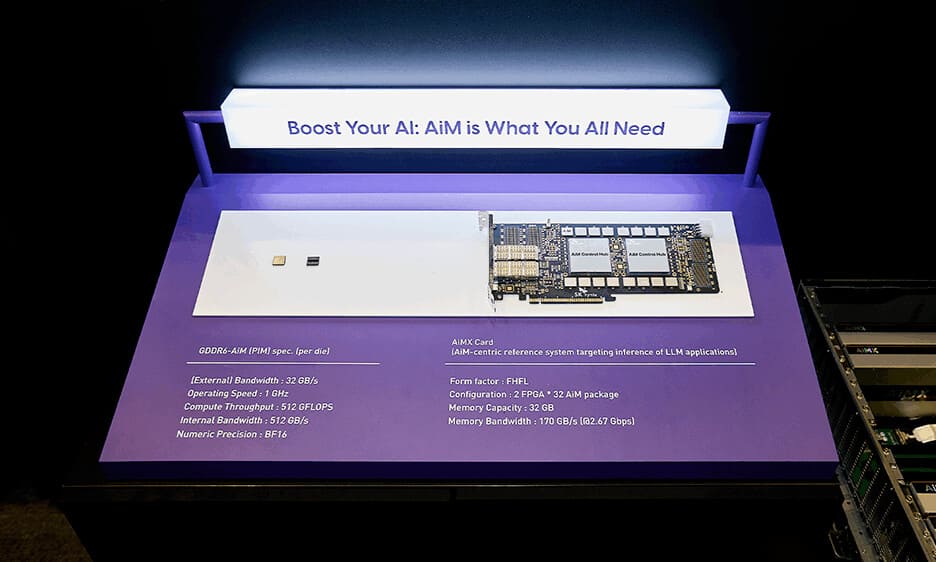

La custom HBM busca integrar funciones de cálculo directamente en el die base de la memoria, reduciendo la dependencia de GPU y ASIC en determinadas operaciones. Este enfoque mejora el rendimiento de inferencia y reduce el consumo energético asociado al movimiento de datos entre procesador y memoria.

En paralelo, la gama AI-D segmenta las futuras memorias DRAM según uso y eficiencia:

- AI-D O (Optimization): módulos de bajo consumo orientados a data centers y reducción de costes operativos.

- AI-D B (Breakthrough): soluciones de alta capacidad y procesamiento en memoria (PIM), diseñadas para superar el memory wall.

- AI-D E (Expansion): versiones destinadas a robótica, automoción e industria fuera del entorno de servidores.

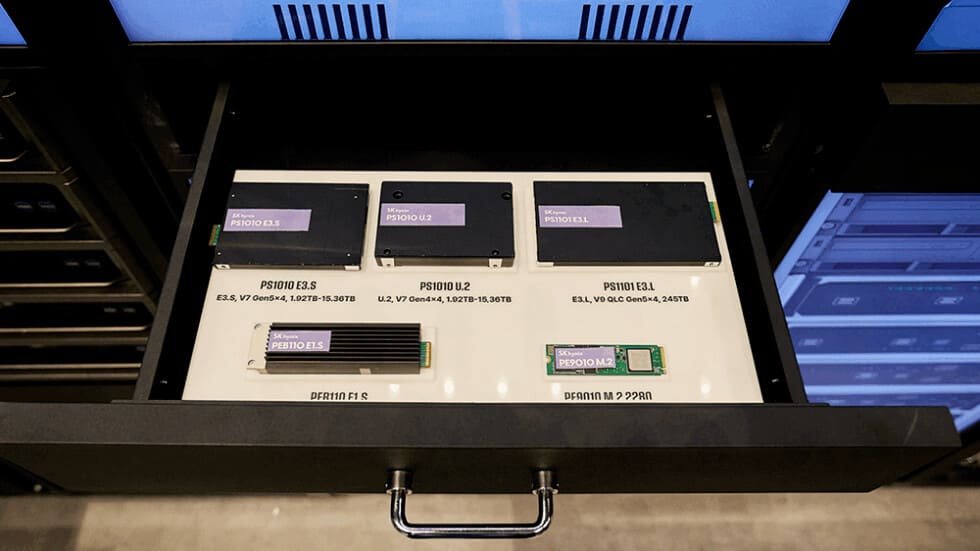

AI-NAND: almacenamiento de nueva generación para IA

El tercer pilar, AI-NAND, redefine la función del almacenamiento en sistemas AI. La compañía trabaja en tres líneas de desarrollo:

- AI-N P (Performance): SSD de alto rendimiento con IOPS optimizados para inferencia a gran escala.

- AI-N B (Bandwidth): soluciones de gran ancho de banda, aplicando estructuras apiladas tipo HBM en NAND.

- AI-N D (Density): unidades de alta densidad basadas en QLC, enfocadas a almacenamiento masivo con bajo consumo.

Estas familias están diseñadas para equilibrar rendimiento, capacidad y eficiencia energética, abordando la brecha entre la velocidad de cómputo y la transferencia de datos que limita los sistemas de IA de nueva generación.

Memoria centrada en la arquitectura AI

Durante las ponencias técnicas del SK AI Summit, la empresa destacó la necesidad de arquitecturas centradas en la memoria que prioricen el movimiento eficiente de datos frente al incremento de potencia bruta. Se abordaron conceptos como CXL Memory Module (CMM) y Processing-in-Memory (PIM), junto con propuestas de colaboración entre diseñadores de ASIC y GPU para adaptar las interconexiones a las nuevas cargas de trabajo.

También se discutieron los límites estructurales de las interconexiones eléctricas y el avance hacia Co-Packaged Optics (CPO), que permitirá enlaces ópticos con mayor ancho de banda y menor consumo. Este enfoque se perfila como una solución a los cuellos de botella que enfrenta la computación masiva basada en IA.

Prototipos y demostraciones

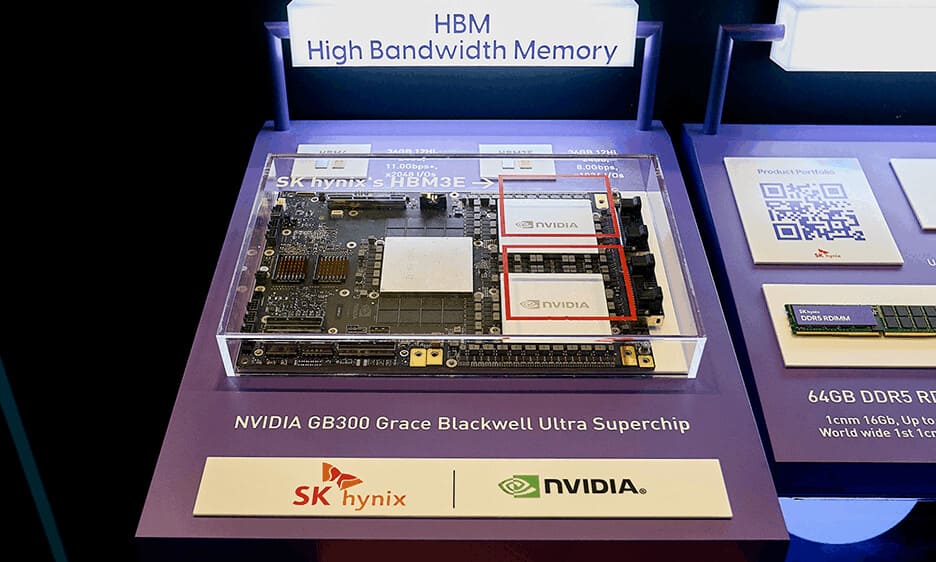

En la zona expositiva del evento, SK hynix mostró una amplia gama de desarrollos alineados con esta estrategia. Entre ellos destacaron el HBM4 de 12 capas, la integración del NVIDIA GB300 Grace Blackwell Superchip con HBM3E de 36 GB, y módulos RDIMM, MRDIMM y CXL-DDR5 optimizados para cargas de IA.

La compañía también presentó un sistema de inferencia LLM distribuido basado en memoria agrupada CXL, demostrando mejoras en la comunicación entre GPU y servidores frente a métodos de red tradicionales. En paralelo, se exhibieron eSSD de nueva generación como los PS1010 E3.S y PEB110 E1.S, junto con sistemas de detección de obleas mediante visión AI, aplicando modelos YOLOv8-OBB dentro de cámaras de proceso semiconductor.

Con esta hoja de ruta, SK hynix busca posicionarse como un referente en memoria para IA, combinando innovación en hardware con un enfoque colaborativo junto a los principales actores del sector.

Vía: TechPowerUp