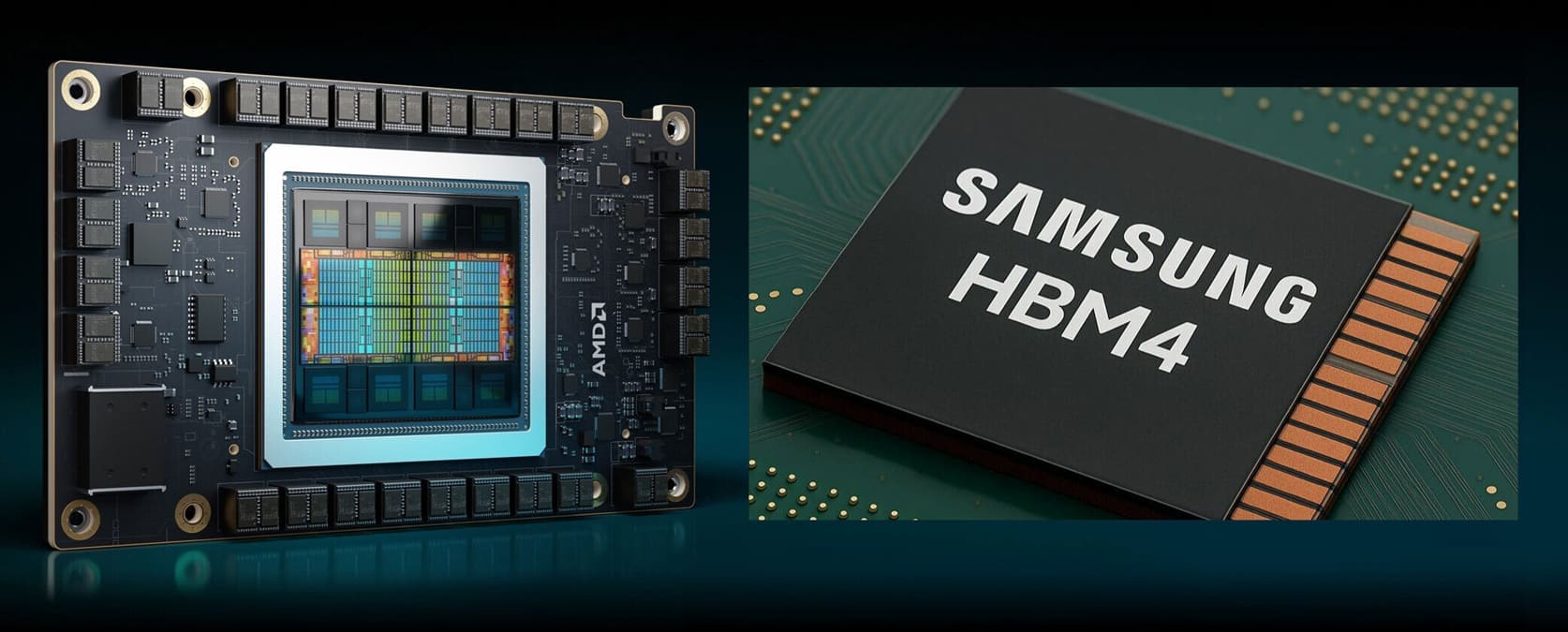

Según un informe de TrendForce, citando fuentes de SeDaily, Samsung se convertirá en el proveedor principal de memoria HBM4 para las próximas GPU AMD Instinct MI450, marcando un nuevo capítulo en la colaboración entre ambas compañías. La noticia llega pocos días después de que AMD anunciara un acuerdo plurianual con OpenAI, que incluye una asociación energética de 6 gigavatios y la opción de que la empresa de Sam Altman adquiera hasta un 10% de AMD.

Samsung y AMD refuerzan su cooperación estratégica

La colaboración entre Samsung y AMD no es nueva. Las actuales GPU MI350X y MI355X ya integran memoria HBM3e de 12 alturas (12-high) fabricada por Samsung y Micron, ofreciendo un ancho de banda excepcional para cargas de trabajo de IA y HPC. La introducción de HBM4 supondrá un salto importante en densidad, consumo energético y ancho de banda efectivo, con mejoras diseñadas específicamente para procesamiento de modelos de IA de gran escala.

De acuerdo con las fuentes, Samsung liderará la producción inicial de HBM4 destinada a las AMD MI450, consolidando su posición frente a SK hynix y Micron en el segmento de memoria de alto ancho de banda.

OpenAI, el epicentro de la demanda global de memoria

El anuncio llega tras los recientes movimientos de OpenAI, que la semana pasada firmó acuerdos iniciales con Samsung y SK hynix para asegurar el suministro de memoria DRAM y HBM destinada a su gigantesco centro de datos Stargate. Según Reuters, las necesidades de OpenAI podrían alcanzar los 900.000 obleas DRAM, equivalente a casi el 40% de la producción mundial actual.

Además de HBM, Samsung planea suministrar memoria GDDR, SSDs de alta capacidad y módulos LPDDR5X-PIM (memoria DRAM de bajo consumo con computación integrada) para optimizar el rendimiento energético en tareas de IA.

AMD busca contrarrestar el dominio de NVIDIA

Mientras tanto, AMD sigue impulsando su iniciativa UALink (Ultra Accelerator Link), una alternativa abierta a NVLink, el estándar propietario de NVIDIA. Este proyecto, lanzado en mayo, ya cuenta con el apoyo de Apple, Google, Microsoft, Synopsys, Meta e incluso Intel, aunque la continuidad de esta última en el consorcio está en duda tras su reciente acuerdo estratégico con NVIDIA.

El avance de HBM4 representa un paso clave en la batalla por la infraestructura de IA, donde el equilibrio entre potencia computacional, eficiencia térmica y ancho de banda de memoria definirá la próxima generación de aceleradores para inteligencia artificial.

Vía: TechPowerUp