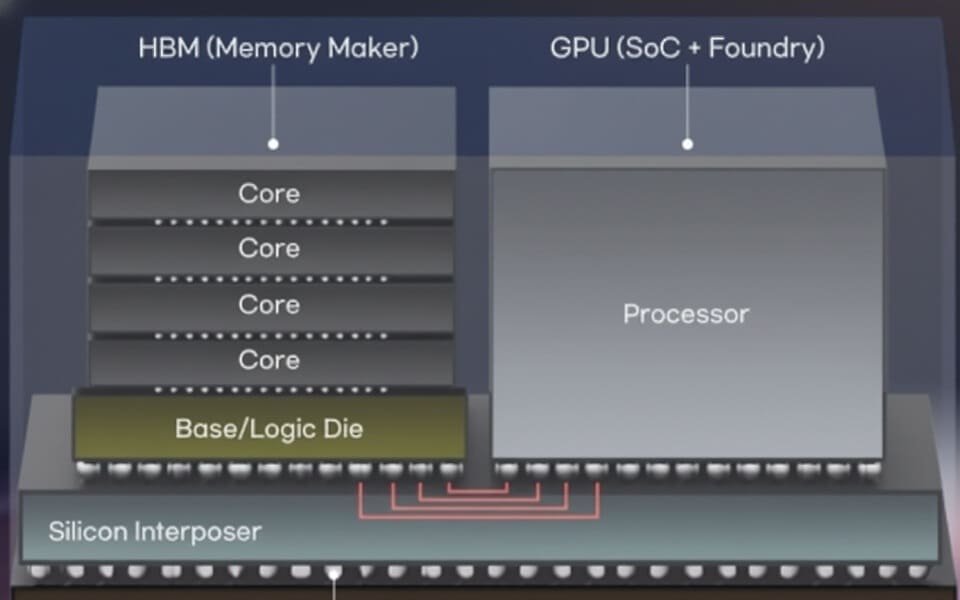

El sector de semiconductores se prepara para un cambio profundo: grandes tecnológicas como Meta y NVIDIA están evaluando integrar núcleos de GPU directamente en los apilamientos de memoria HBM de próxima generación. Según medios surcoreanos, SK Hynix y Samsung participan en conversaciones iniciales para desarrollar esta llamada custom HBM, que trasladaría parte del cómputo al propio silicio de memoria, reduciendo el consumo y acortando las distancias entre procesamiento y almacenamiento de datos.

Esta idea extendería el principio de la HBM4, prevista para producción masiva en 2026, que ya incluirá un controlador integrado en el die base para mejorar el ancho de banda y la eficiencia. Al añadir núcleos de GPU en esa capa inferior, la arquitectura podría evolucionar hacia un modelo híbrido que combine almacenamiento, cómputo y comunicación dentro del mismo encapsulado.

Una nueva frontera en el diseño de memoria para IA

El concepto busca resolver uno de los mayores cuellos de botella en sistemas de IA y HPC: el movimiento constante de datos entre GPU y memoria. Al integrar lógica de GPU en la base del apilamiento HBM, la distancia física entre unidades de cálculo y celdas DRAM se reduciría drásticamente, lo que supondría mayor rendimiento y menor consumo.

Sin embargo, los desafíos son enormes. Los apilamientos basados en Through-Silicon Vias (TSV) disponen de un espacio limitado y la entrega de potencia a los núcleos integrados es compleja. Además, la refrigeración de un die con lógica densa dentro de la pila representa un obstáculo crítico para su viabilidad industrial. Estas limitaciones podrían retrasar la adopción de la tecnología hasta que surjan soluciones de encapsulado térmico más eficientes.

Reacciones del sector académico e industrial

El profesor Kim Joung-ho, de la KAIST, destacó que “la frontera entre la memoria y los semiconductores de sistema colapsará con la evolución de la IA”, subrayando la necesidad de que los fabricantes nacionales amplíen su alcance más allá de la memoria hacia el sector lógico para anticiparse al mercado de próxima generación de HBM.

Compañías con experiencia en encapsulado avanzado y diseño de lógica, como AMD, Intel o la propia NVIDIA, serían las más beneficiadas. En cambio, los fabricantes centrados exclusivamente en memoria deberán invertir en tecnologías de integración a nivel de sistema si quieren mantener su competitividad en el nuevo ecosistema de cómputo híbrido.

Ejemplos recientes y rumbo del mercado

El acelerador AMD Instinct MI430X, basado en la arquitectura CDNA de última generación, incorpora 432 GB de memoria HBM4 con un ancho de banda de 19,6 TB/s, demostrando la magnitud que puede alcanzar esta tecnología. Por su parte, el NVIDIA Vera Rubin Superchip adopta un enfoque distinto: cada GPU integra dos chiplets de cómputo de tamaño reticular junto con ocho pilas HBM4, ofreciendo unos 288 GB de HBM4 por GPU y aproximadamente 576 GB en todo el conjunto.

El camino apunta a una convergencia entre cómputo y memoria, donde la proximidad física se convertirá en el principal motor de eficiencia. Si la integración de núcleos de GPU en HBM se materializa, supondrá un salto estructural en la arquitectura de hardware para IA, alterando la cadena de valor del sector de semiconductores y redefiniendo la frontera entre procesador y memoria.

Vía: TechPowerUp