Los modelos de IA están avanzando con rapidez hacia arquitecturas MoE (Mixture of Experts), un enfoque que mejora la eficiencia del cómputo, pero que introduce enormes desafíos de escalado, latencia y comunicación entre nodos. En este nuevo escenario, NVIDIA parece haber tomado una clara delantera con sus racks Blackwell GB200 NVL72, que según un nuevo análisis logran ventajas muy amplias frente a las soluciones actuales de AMD.

Un informe de Signal65, apoyado en datos de SemiAnalysis InferenceMAX, señala que los sistemas Blackwell de NVIDIA se han consolidado como la opción preferente para hiperescaladores que buscan el mejor rendimiento por dólar en entornos MoE, un punto crítico para despliegues de inferencia a gran escala.

MoE: eficiencia a cambio de complejidad extrema

Las arquitecturas MoE funcionan activando solo una parte del modelo en cada inferencia, delegando el trabajo en subredes especializadas conocidas como experts. Este enfoque reduce el coste computacional frente a modelos densos, pero exige un intercambio masivo de datos all-to-all, generando una fuerte presión sobre ancho de banda y latencia.

En este contexto, la capacidad de escalar de forma eficiente se convierte en el factor diferencial. Según Signal65, el GB200 NVL72 destaca precisamente por resolver estos cuellos de botella mejor que sus rivales, situándose como la referencia actual para cargas MoE complejas.

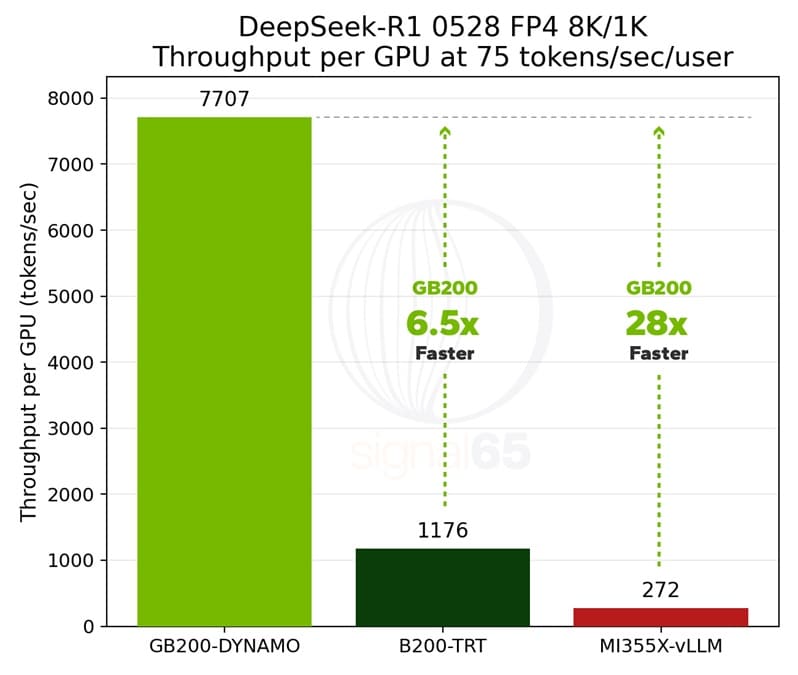

Hasta 28 veces más rendimiento por GPU frente a MI355X

Los datos citados por el informe son contundentes. En pruebas de inferencia MoE, los servidores Blackwell GB200 NVL72 alcanzan hasta 28 veces más rendimiento por GPU, con cifras cercanas a 75 tokens por segundo, frente a clústeres equivalentes basados en Instinct MI355X.

Esta diferencia no se explica únicamente por la potencia bruta del silicio de GPU, sino por el enfoque de diseño adoptado por NVIDIA. La compañía ha apostado por lo que denomina “co-diseño extremo”, integrando hardware, interconexión y memoria como un sistema único, optimizado desde el inicio para este tipo de cargas.

Co-diseño extremo y memoria compartida masiva

El corazón del GB200 NVL72 es una configuración de 72 chips Blackwell trabajando de forma cohesionada, acompañados por 30 TB de memoria compartida de alta velocidad. Esta arquitectura permite llevar el paralelismo de expertos a un nivel muy superior, reduciendo drásticamente los costes de comunicación entre nodos.

Este planteamiento resulta especialmente eficaz en MoE, donde la eficiencia no depende solo del número de aceleradores, sino de cómo se comunican y cómo acceden a los datos. NVIDIA ha logrado convertir este punto crítico en una ventaja estructural frente a soluciones más modulares.

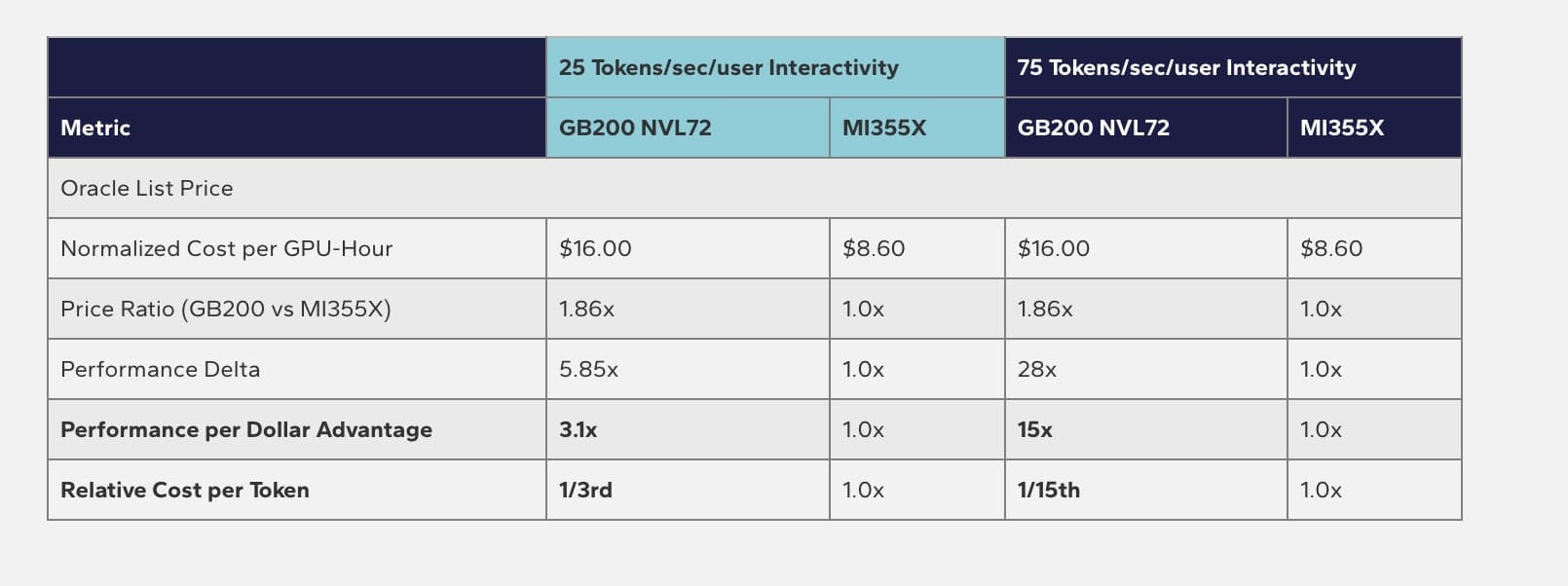

Ventaja clara en coste por token y TCO

Más allá del rendimiento puro, la economía de la IA juega un papel decisivo. Según Signal65, citando precios de Oracle Cloud, los racks GB200 NVL72 ofrecen hasta 1/15 del coste relativo por token, manteniendo además una mayor interactividad en inferencia.

Este dato ayuda a explicar por qué el stack de hardware de NVIDIA es uno de los más adoptados por hiperescaladores y grandes proveedores de servicios de IA. La combinación de alto rendimiento, bajo coste por token y un ritmo anual de lanzamientos permite a la compañía dominar cada nueva fase del ciclo de la IA, desde prefill hasta decode e inferencia a gran escala.

AMD sigue siendo competitiva, pero no en MoE a gran escala

El propio informe matiza que estos resultados no zanjan el debate entre AMD y NVIDIA en el sector de IA. Las soluciones Instinct MI355X siguen siendo muy competitivas en entornos densos, especialmente gracias a su elevada capacidad de HBM3e.

Sin embargo, en cargas MoE puras, NVIDIA mantiene actualmente una posición dominante. La situación podría cambiar con la llegada de nuevas soluciones a escala de rack, donde se espera una competencia más directa entre futuras plataformas como Helios y Vera Rubin.

Por ahora, los datos refuerzan la idea de que el co-diseño extremo de NVIDIA ha marcado el camino en arquitecturas MoE, ampliando la brecha con AMD en uno de los frentes más críticos del futuro de la IA.

Vía: Wccftech