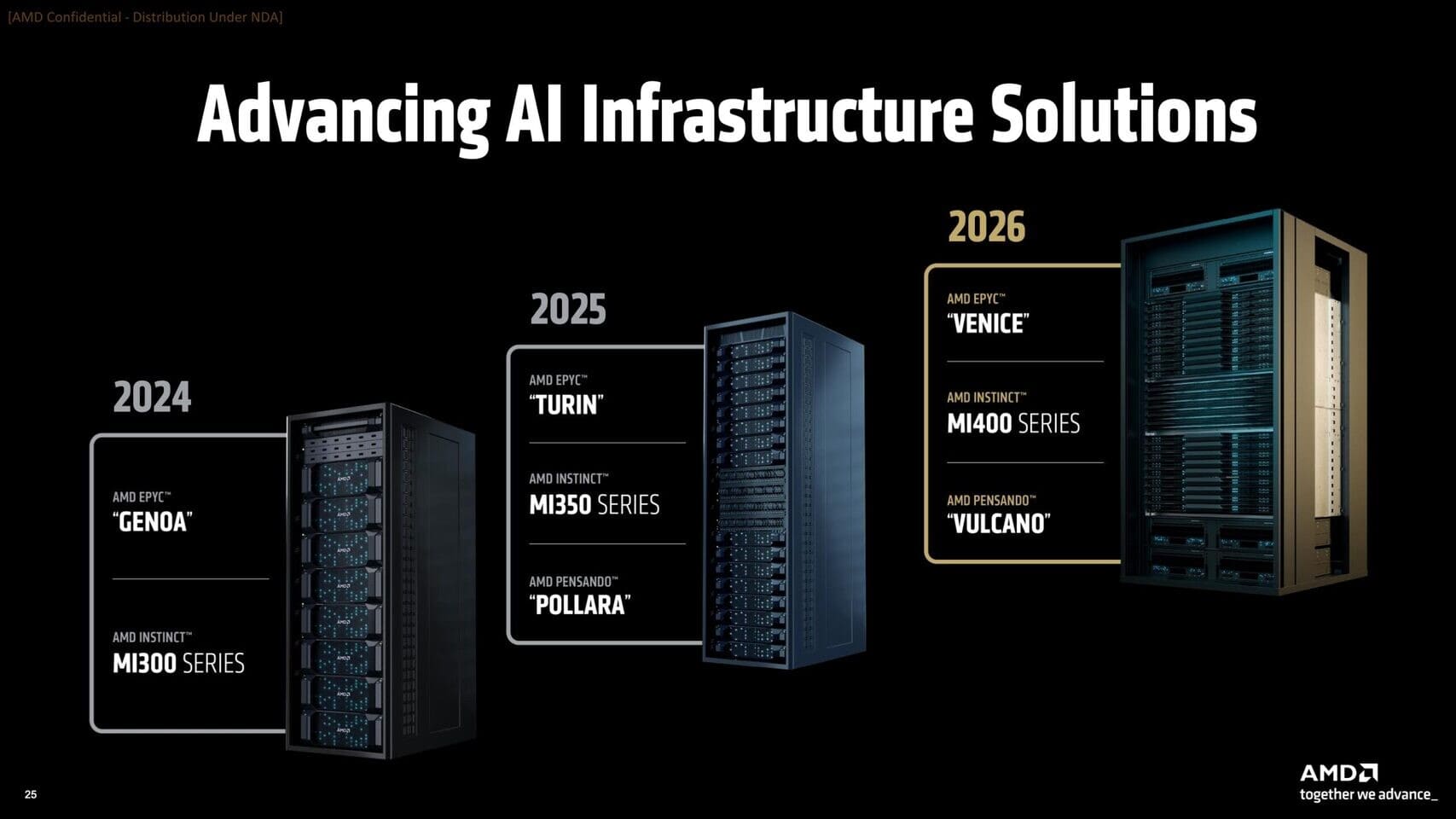

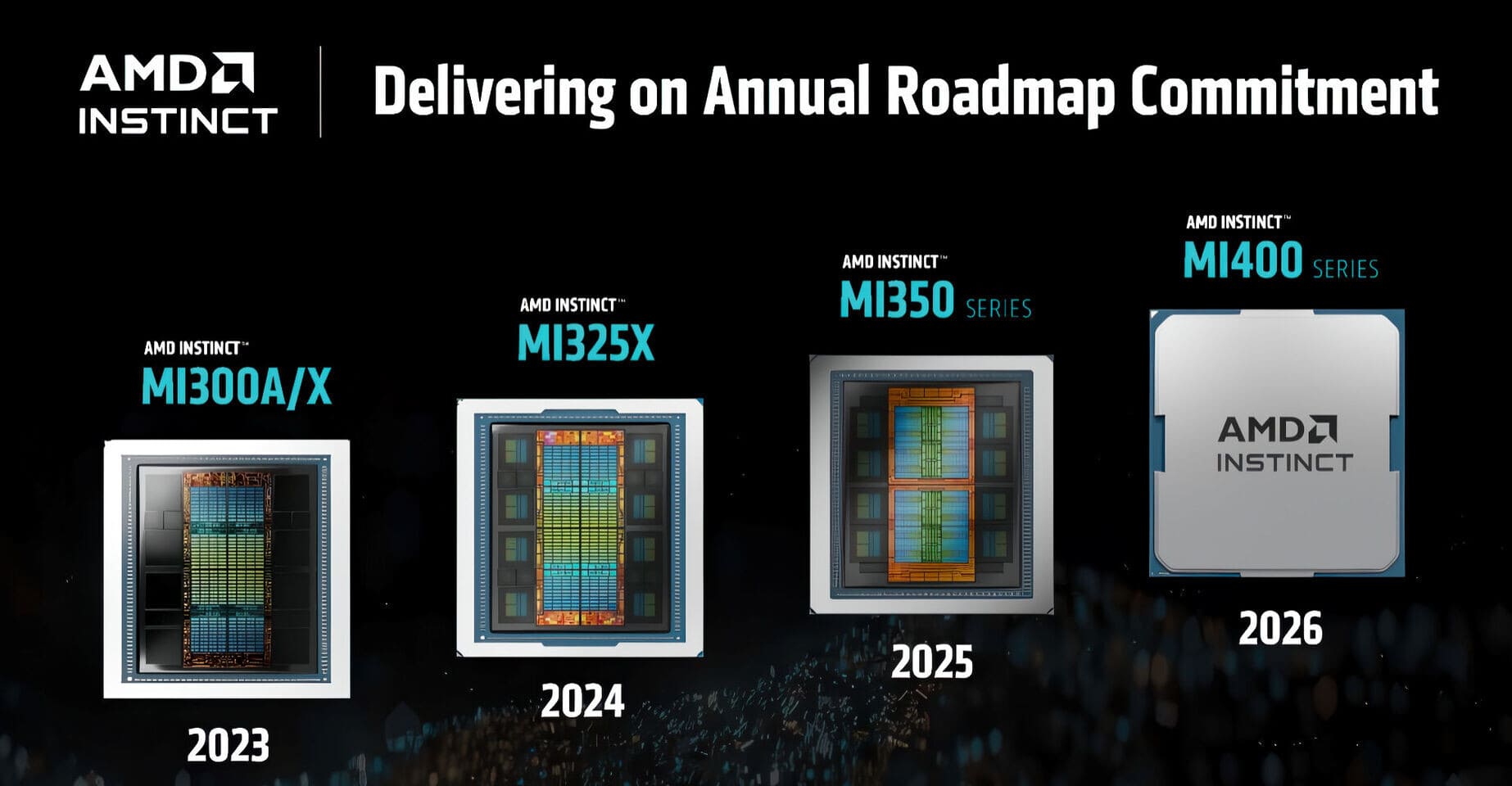

AMD ha levantado el telón de lo que será su gran apuesta en IA para 2026: la serie Instinct MI400. Esta nueva generación de aceleradores basados en la arquitectura UDNA sucederá a la recién presentada Instinct MI350 (CDNA 4) y promete duplicar el rendimiento en cálculo de matrices dispersas con una mejora significativa en memoria y ancho de banda.

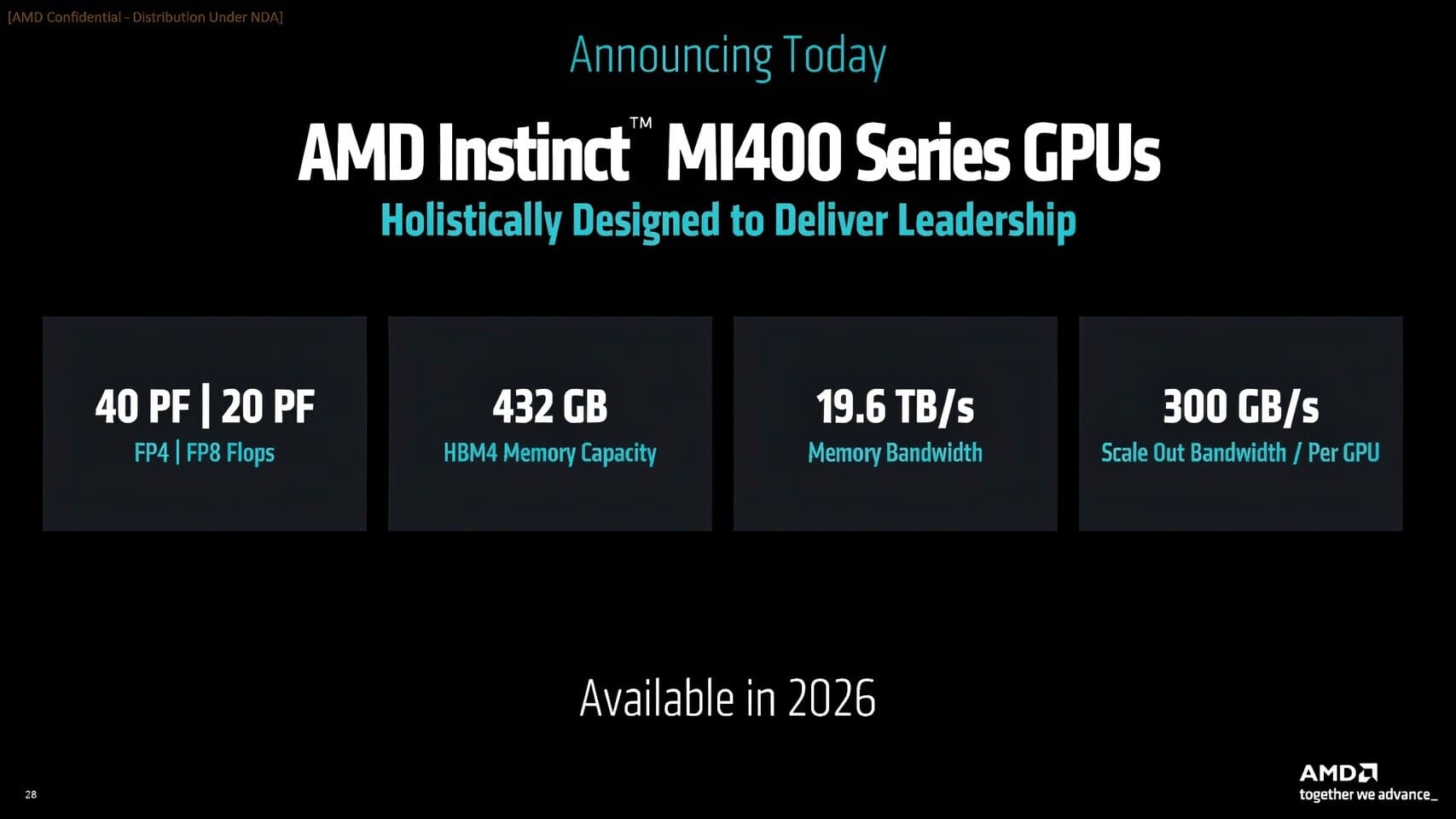

Cada tarjeta Instinct MI400 estará equipada con doce módulos HBM4, proporcionando un total de 432 GB de memoria integrada, muy por encima de los 288 GB presentes en la serie MI350. Estas primeras pilas de HBM4 ya alcanzan una velocidad de aproximadamente 1.6 TB/s por módulo, situándose cerca del objetivo de los 2 TB/s por stack.

Potencia bruta y nuevo enfoque de escalado

En términos de cálculo, AMD apunta a un rendimiento de 20 PetaFLOPS en precisión FP8 y 40 PetaFLOPS en FP4, lo que supone el doble de rendimiento en tareas de IA respecto a la actual MI355X. Pero donde realmente rompe esquemas es en la escalabilidad.

La actual arquitectura de Infinity Fabric permite conectar hasta ocho GPUs en un nodo. Sin embargo, todo lo que excede ese límite tiene que pasar por redes Ethernet. Con la MI400, eso cambia. AMD ha duplicado el ancho de banda de su interconexión con un nuevo fabric link de 300 GB/s, lo que habilita clústeres completos sin cuellos de botella, directamente a través de Infinity Fabric.

Helios: la solución AI integrada de AMD

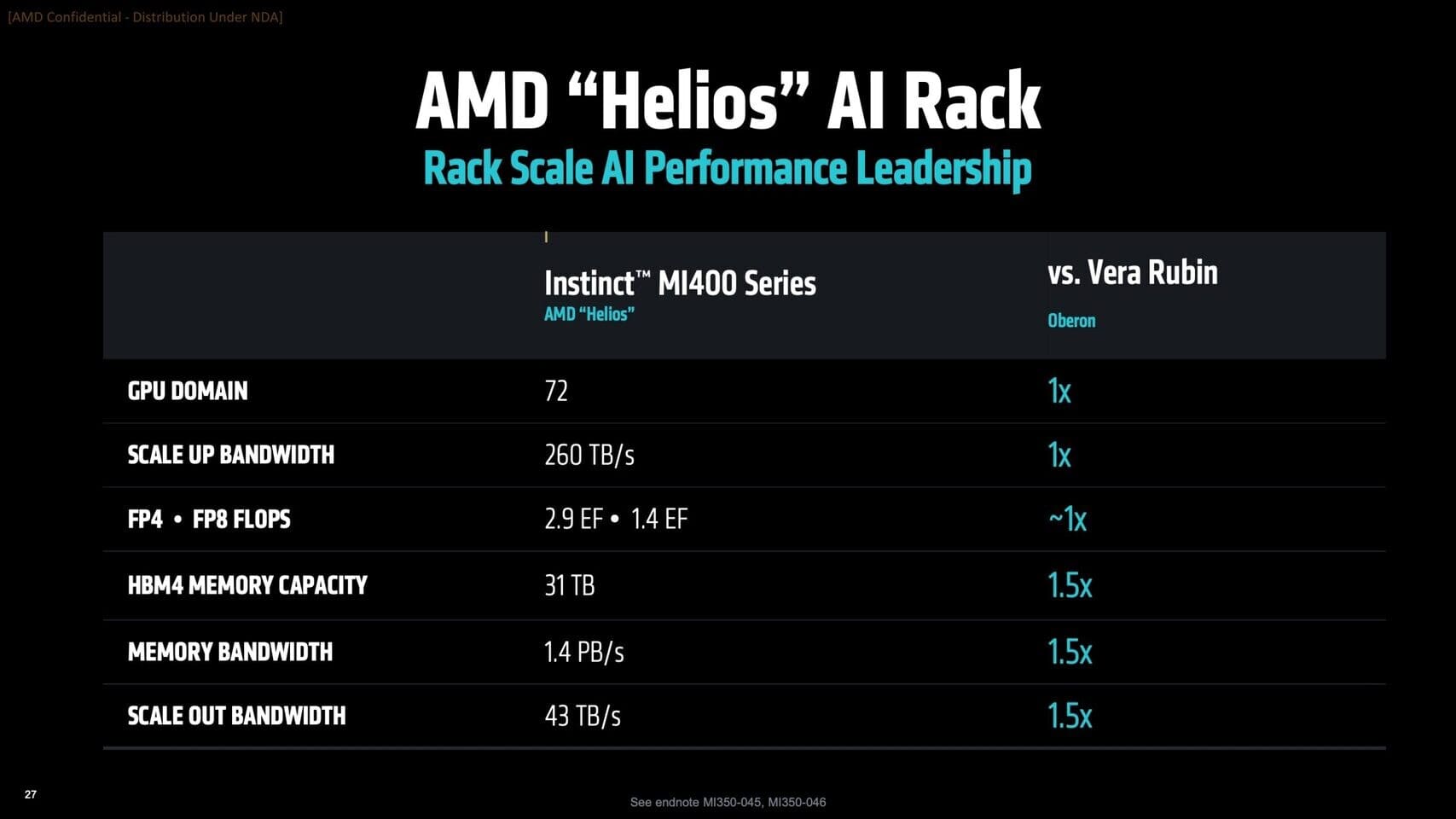

Este avance da paso a Helios, el primer sistema de rack AI completamente integrado por AMD. Este clúster unirá CPUs EPYC «Venice» con 72 GPUs MI400, redes de baja latencia optimizadas y un ecosistema completo de refrigeración y alimentación.

Un solo rack Helios promete alcanzar 3.1 ExaFLOPS de rendimiento tensorial y contar con 31 TB de memoria HBM4. En comparación, NVIDIA Vera Rubin —con 72 GPUs y 288 GB cada una— alcanzaría 3.6 ExaFLOPS, pero AMD asegura que supera en capacidad total y ancho de banda efectivo.

Además, ya se rumorea una futura MI450X con interconexión IF128, que llegaría a finales de 2026 y permitiría conectar 128 GPUs a 1.8 TB/s bidireccional cada una, llevando los clústeres de IA a una escala sin precedentes.

Vía: TechPowerUp