Hemos recibido una nota de prensa por parte de Intel, os la dejamos a continuación:

Intel acelera el desarrollo, la implementación y el desempeño de la IA con una nueva clase de hardware de IA que va de la nube al Edge

Hoy, en una reunión de personalidades influyentes de la industria, Intel dio la bienvenida a la próxima ola de inteligencia artificial (IA) con actualizaciones sobre nuevos productos diseñados para acelerar el desarrollo y la implementación de sistemas de IA desde la nube hasta el edge. Intel demostró sus procesadores de red neuronales (NNP) Intel® Nervana™ para capacitación (NNP-T1000) e inferencia (NNP-I1000): los primeros ASIC de Intel diseñados específicamente para el aprendizaje profundo y complejo con una escala y eficiencia increíbles para clientes de centros de datos y nubes. Intel también reveló su Intel® de próxima generación Movidius™ Myriad™ Vision Processing Unit (VPU) para aplicaciones de medios de comunicación de vanguardia, visión computarizada e inferencia.

«Con esta nueva fase de la IA, estamos llegando a un punto de inflexión en términos de hardware computacional y memoria. Para continuar con el increíble progreso de la IA es necesario contar con hardware específico, como los NNPs Intel Nervana y las VPUs Movidius Myriad. Usar formas más avanzadas de IA a nivel de sistema nos ayudará a pasar de la conversión de datos en información a la transformación de información en conocimiento».

-Naveen Rao, vicepresidente corporativo de Intel y director general del Grupo de Productos de Inteligencia Artificial de Intel

Por qué son importantes: Estos productos refuerzan aún más la cartera de soluciones de inteligencia artificial de Intel, que se espera que genere más de 3.500 millones de dólares en ingresos en 2019. La cartera de productos de IA de Intel, la más amplia del sector, ayuda a los clientes a permitir el desarrollo y la implementación de modelos de IA a cualquier escala, desde nubes masivas hasta dispositivos de borde diminutos, y todo lo que se encuentra en medio.

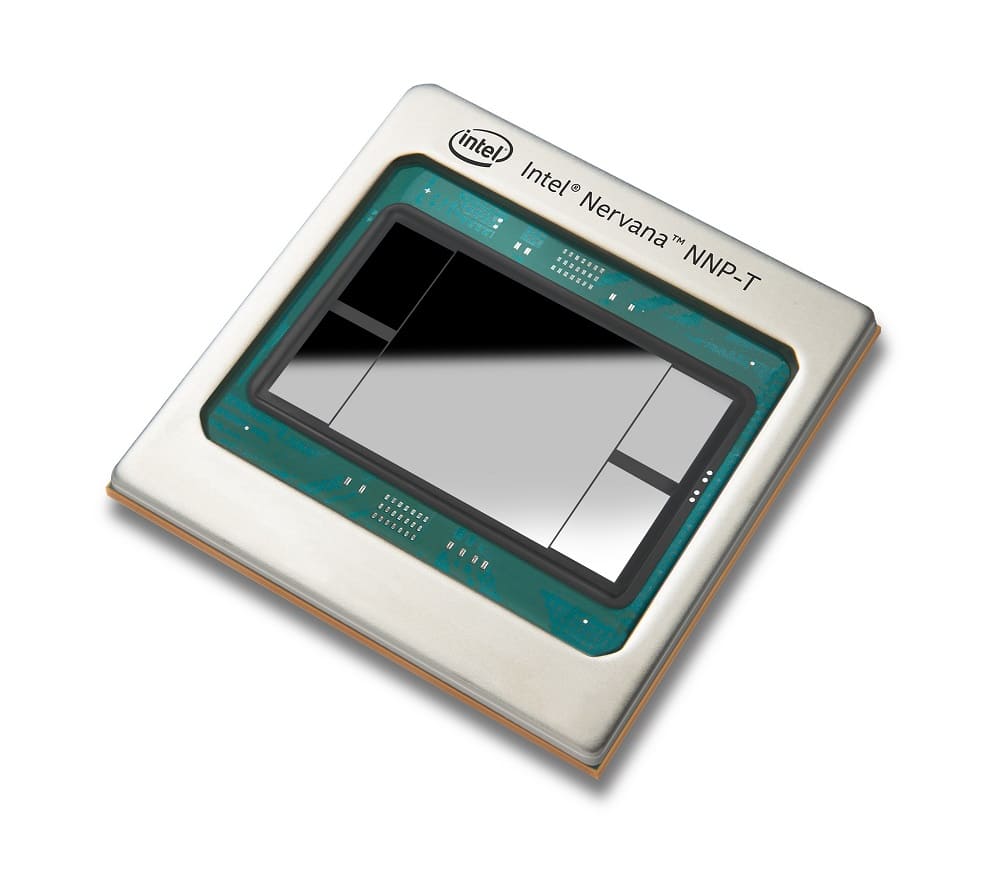

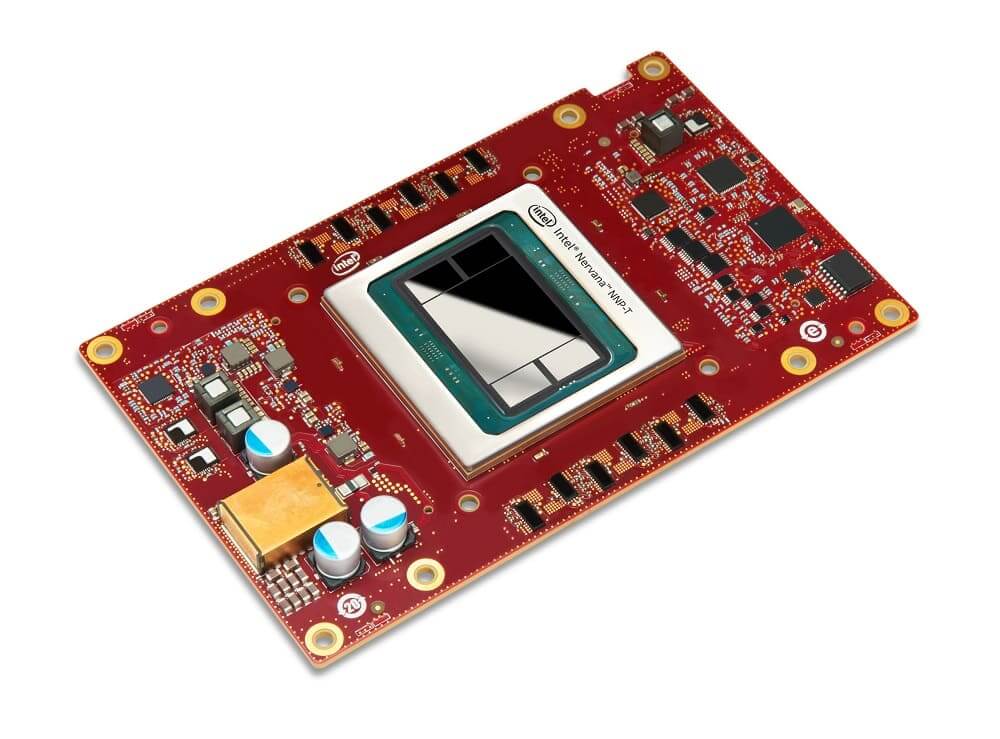

Lo que Intel anunció: Ya en producción y siendo entregados a los clientes, los nuevos NNPs Intel Nervana son parte de un enfoque de IA a nivel de sistemas que ofrece una pila completa de software desarrollada con componentes abiertos e integración de un marco de aprendizaje profundo para un uso óptimo.

El Intel Nervana NNP-T logra el equilibrio adecuado entre la informática, la comunicación y la memoria, lo que permite un escalado casi lineal y eficiente en términos energéticos, desde pequeños clústeres hasta los superordenadores más potentes. El Intel Nervana NNP-I es eficiente en el consumo energético y en el costo y es ideal para ejecutar inferencias intensas y multimodales a escala del mundo real utilizando factores de forma flexibles. Ambos productos fueron desarrollados para las necesidades de procesamiento de la IA de clientes de AI de vanguardia como Baidu y Facebook.

«Estamos entusiasmados de trabajar con Intel para implementar un cálculo de inferencia más rápido y eficiente con el procesador de red neuronal Intel Nervana para la inferencia y para ampliar el soporte de nuestro compilador de aprendizaje profundo de última generación, Glow, al NNP-I», dijo Misha Smelyanskiy, directora de AI System Co-Design en Facebook.

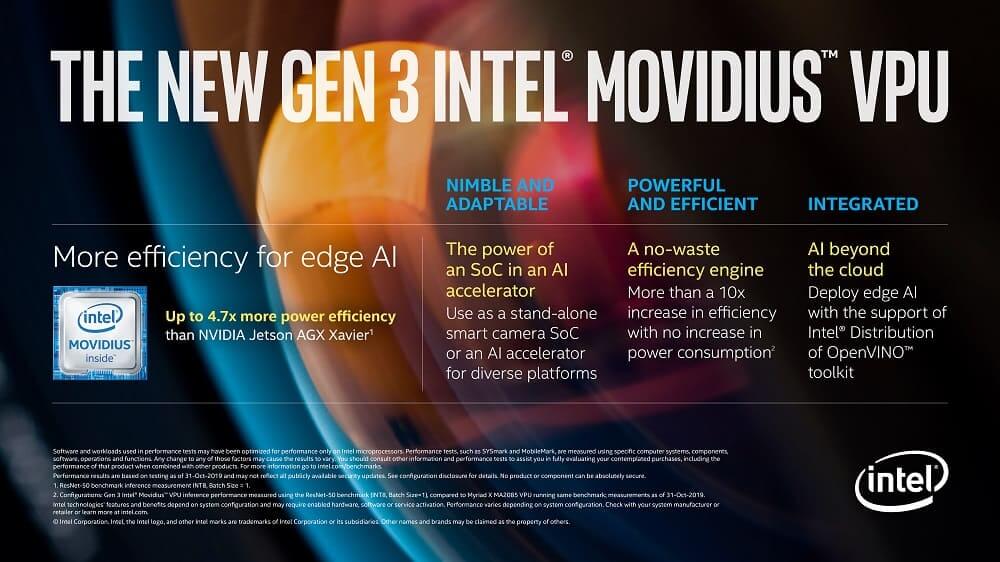

Además, la próxima generación de Intel Movidius VPU, cuya disponibilidad está prevista para el primer semestre de 2020, incorpora avances arquitectónicos únicos y altamente eficientes que se espera que proporcionen un rendimiento líder -más de 10 veces el rendimiento de inferencia de la generación anterior- con una eficiencia energética hasta seis veces superior a la de los procesadores de la competencia. Intel también anunció su nuevo Intel® DevCloud for the Edge, que, junto con el kit de herramientas Intel® Distribution of OpenVINO™, aborda un problema clave para los desarrolladores, permitiéndoles probar, prototipar y probar soluciones de IA en una amplia gama de procesadores Intel antes de comprar hardware.

Por qué es importante: Se requieren datos, modelos y técnicas increíblemente complejos para hacer avanzar el razonamiento y el contexto de un aprendizaje profundo, lo que conlleva la necesidad de pensar de manera diferente sobre las arquitecturas.

Con la mayor parte del mundo ejecutando parte de su IA en procesadores escalables Intel® Xeon®™, Intel continúa mejorando esta plataforma con características como Intel® Deep Learning Boost con Vector Neural Network Instruction (VNNI) que mejoran el desempeño de la IA en todo el centro de datos y en las implementaciones en los edge. Si bien esto seguirá siendo una sólida base para la IA durante años, las necesidades de formación profunda más avanzadas para los clientes de Intel exigen que el rendimiento se duplique cada 3,5 meses, y este tipo de avances sólo se producirán con una cartera de soluciones de IA como la de Intel. Intel está equipado para examinar el panorama completo de la informática, la memoria, el almacenamiento, la interconexión, el empaquetado y el software para maximizar la eficiencia, la programabilidad y garantizar la capacidad crítica de ampliar la distribución del aprendizaje profundo a través de miles de nodos para, a su vez, escalar la revolución del conocimiento.