La industria de la IA atraviesa una nueva fase marcada por la computación agéntica, un enfoque que exige latencias muy bajas, gran ancho de banda de memoria y una eficiencia extrema por vatio. En este contexto, NVIDIA ha publicado nuevos datos de rendimiento de Blackwell Ultra, donde el GB300 NVL72 emerge como una de las soluciones más avanzadas para hiperescaladores y laboratorios que trabajan con modelos frontera.

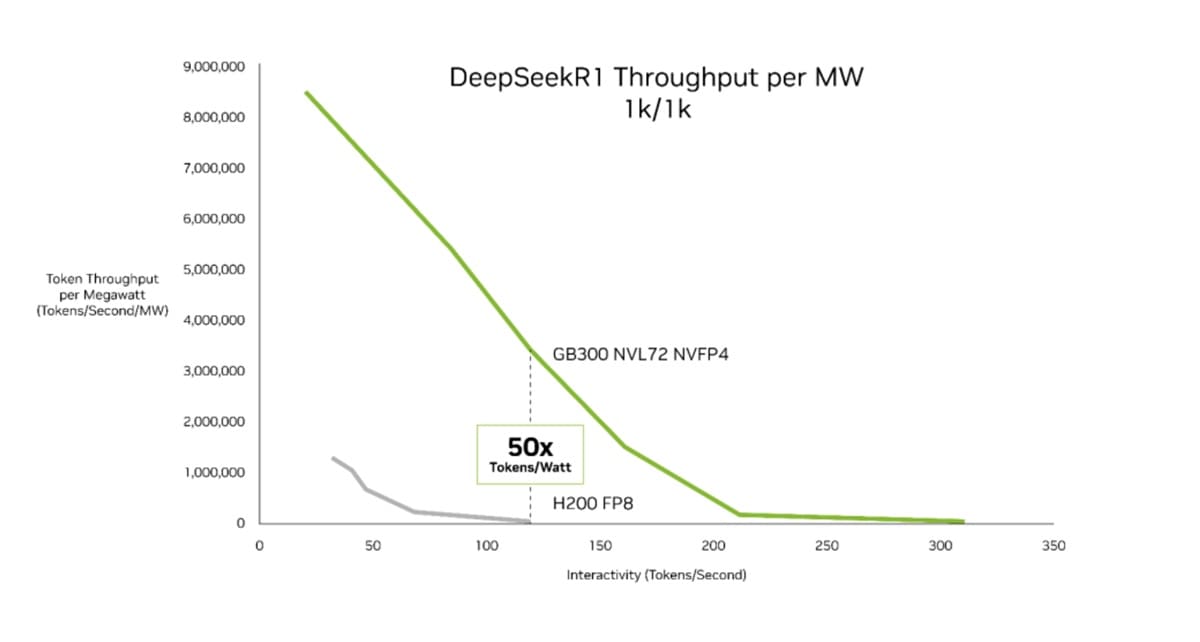

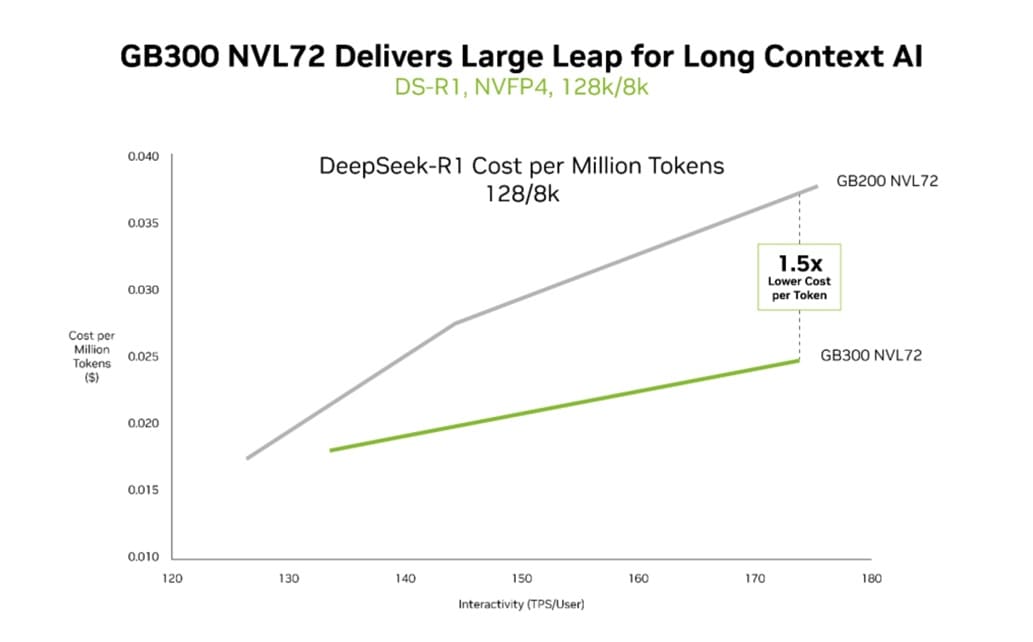

Las pruebas, realizadas sobre InferenceMAX de SemiAnalysis, ponen el foco en métricas clave como el rendimiento por megavatio y el coste por millón de tokens, dos factores críticos en el despliegue masivo de infraestructuras de inferencia.

El GB300 NVL72 dispara el rendimiento por megavatio

Uno de los datos más llamativos de Blackwell Ultra es el salto en throughput por megavatio frente a generaciones anteriores. Según NVIDIA, el GB300 NVL72 logra hasta 50 veces más rendimiento por megavatio que las GPUs Hopper, una mejora que refleja un trabajo profundo de optimización de arquitectura, diseño de rack y eficiencia energética.

Esta evolución no se limita al rendimiento bruto. NVIDIA ha puesto especial énfasis en métricas como tokens por vatio, consideradas cada vez más relevantes en un escenario donde los costes energéticos condicionan la escalabilidad de los centros de datos de IA.

NVLink como pilar del salto generacional

Gran parte de estas mejoras se apoyan en la evolución de NVLink. Blackwell Ultra integra hasta 72 GPUs dentro de un único dominio NVLink, formando un tejido unificado con 130 TB/s de ancho de banda. Esta cifra supone un salto radical frente a Hopper, limitado a configuraciones NVLink de 8 chips.

A este avance se suma la adopción del formato de precisión NVFP4, que permite incrementar el throughput efectivo sin disparar el consumo. La combinación de interconexión masiva, precisión optimizada y co-diseño extremo explica por qué el GB300 NVL72 domina en escenarios de inferencia a gran escala.

Menor coste por token en la era de la IA agéntica

Las pruebas también analizan el impacto económico del nuevo diseño. En cargas de trabajo agénticas, NVIDIA afirma haber logrado una reducción de hasta 35 veces en el coste por millón de tokens, posicionando al GB300 NVL72 como una de las plataformas más atractivas para hiperescaladores y laboratorios de investigación avanzada.

Este aspecto es especialmente relevante en aplicaciones donde los agentes deben mantener estados complejos y trabajar con contextos muy largos, un escenario en el que el consumo de tokens se convierte en un cuello de botella financiero y técnico.

Comparativa directa con GB200 y mejoras en contexto largo

Más allá de la comparación con Hopper, NVIDIA también ha enfrentado GB200 y GB300 NVL72 en workloads de contexto largo, uno de los grandes retos de la computación agéntica. En este ámbito, Blackwell Ultra consigue hasta 1,5 veces menos coste por token y el doble de velocidad en el procesamiento de atención, mejorando la viabilidad de agentes que necesitan manejar grandes volúmenes de información persistente.

Estas cifras refuerzan la idea de que la escalabilidad no solo sigue vigente, sino que se está redefiniendo a través de arquitecturas altamente integradas y optimizadas para inferencia.

Primeros benchmarks y una hoja de ruta clara

Aunque Blackwell Ultra se encuentra aún en fase de integración en hiperescaladores, estos resultados representan algunos de los primeros benchmarks públicos de la arquitectura. Todo apunta a que NVIDIA ha logrado mantener intactas las leyes de escalado, alineándolas con las necesidades reales de la IA moderna.

Con la vista puesta en Vera Rubin, NVIDIA deja claro que Blackwell es solo una etapa más dentro de una hoja de ruta agresiva que sigue consolidando su posición dominante en la infraestructura de IA.

Vía: Wccftech