Supermicro ha anunciado la llegada de sus nuevos sistemas HGX B300 de 2 OU (OCP) y 4 U, refrigerados por líquido y diseñados para entornos hiperescala y centros de datos de IA. Estas plataformas se integran en la línea Data Center Building Block Solutions (DCBBS), con una densidad y rendimiento sin precedentes para infraestructuras de entrenamiento masivo de modelos y despliegues de AI factory.

Arquitectura Blackwell y densidad extrema de GPU

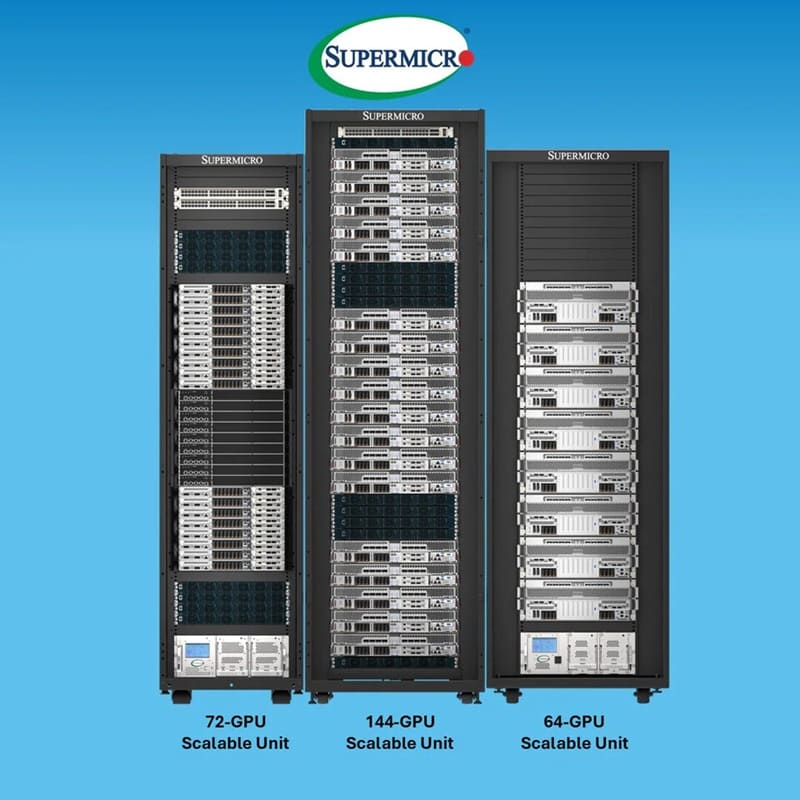

El modelo 2 OU (OCP) cumple con la especificación Open Rack V3 de 21 pulgadas y admite hasta 144 GPU por rack, alcanzando una densidad sobresaliente para entornos cloud e hiperescala. Cada nodo integra 8 GPU NVIDIA Blackwell Ultra con un TDP de 1.100W, combinadas con una arquitectura modular y conexiones blind-mate para refrigeración directa por líquido.

La infraestructura completa puede escalar con switches NVIDIA Quantum-X800 InfiniBand y las unidades de distribución térmica Supermicro CDU de 1,8 MW, permitiendo construir SuperClusters de 1.152 GPU por unidad escalable.

Eficiencia térmica y refrigeración líquida DLC-2

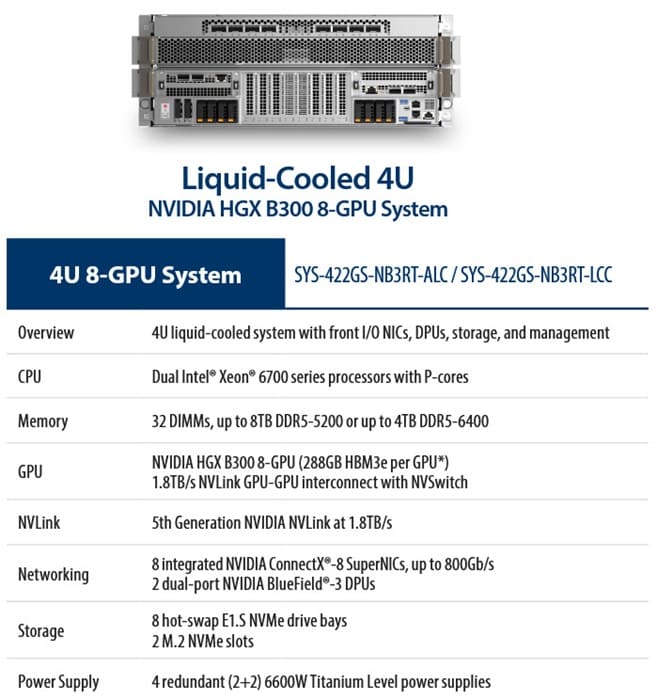

El sistema 4 U Front I/O HGX B300 mantiene la misma potencia de cálculo dentro de un formato EIA 19 pulgadas, más común en instalaciones tradicionales. Su tecnología DLC-2 disipa hasta un 98% del calor generado mediante refrigeración líquida directa, lo que reduce drásticamente el consumo energético y el ruido, al tiempo que mejora la mantenibilidad de los clústeres densos de entrenamiento e inferencia.

Ambos modelos integran 2,1 TB de memoria HBM3e por sistema, suficiente para manejar modelos de gran tamaño. En conjunto, las plataformas duplican el ancho de banda de red hasta 800 Gb/s gracias a las tarjetas NVIDIA ConnectX-8 SuperNIC, lo que acelera tareas de IA multimodal, entrenamiento de modelos base y aplicaciones agentic AI.

Diseño sostenible y despliegue validado

La familia HGX B300 ha sido desarrollada bajo criterios de eficiencia y sostenibilidad. La refrigeración líquida DLC-2 permite un ahorro energético de hasta el 40%, operación con agua templada a 45 °C y eliminación de sistemas de refrigeración por compresor.

Los sistemas se entregan prevalidados y probados bajo los niveles L11 y L12, acelerando la puesta en marcha en entornos empresariales, gubernamentales e hiperescala. Con esta estrategia, Supermicro busca reducir costes operativos y acortar los plazos de implementación de infraestructuras de IA a gran escala.

Integración completa con el ecosistema NVIDIA

Estos nuevos equipos amplían la gama Supermicro NVIDIA Blackwell, que ya incluye los GB300 NVL72, HGX B200 y RTX PRO 6000 Server Edition. Todos los sistemas cuentan con certificación NVIDIA y compatibilidad con NVIDIA AI Enterprise, Run:ai y soluciones de red Quantum-X800 InfiniBand y Spectrum-4 Ethernet. Esta integración total permite a los clientes construir infraestructuras modulares de IA que escalan desde un nodo hasta AI factories completas.

Vía: TechPowerUp