AMD ha dado un paso importante en su estrategia para competir en el entrenamiento de IA generativa, con los primeros resultados públicos de la Instinct MI350 Series en MLPerf 5.1 Training. Las nuevas cifras muestran mejoras masivas frente a generaciones previas y consolidan a la compañía en un momento clave para la aceleración de modelos fundacionales y cargas LoRA de gran escala.

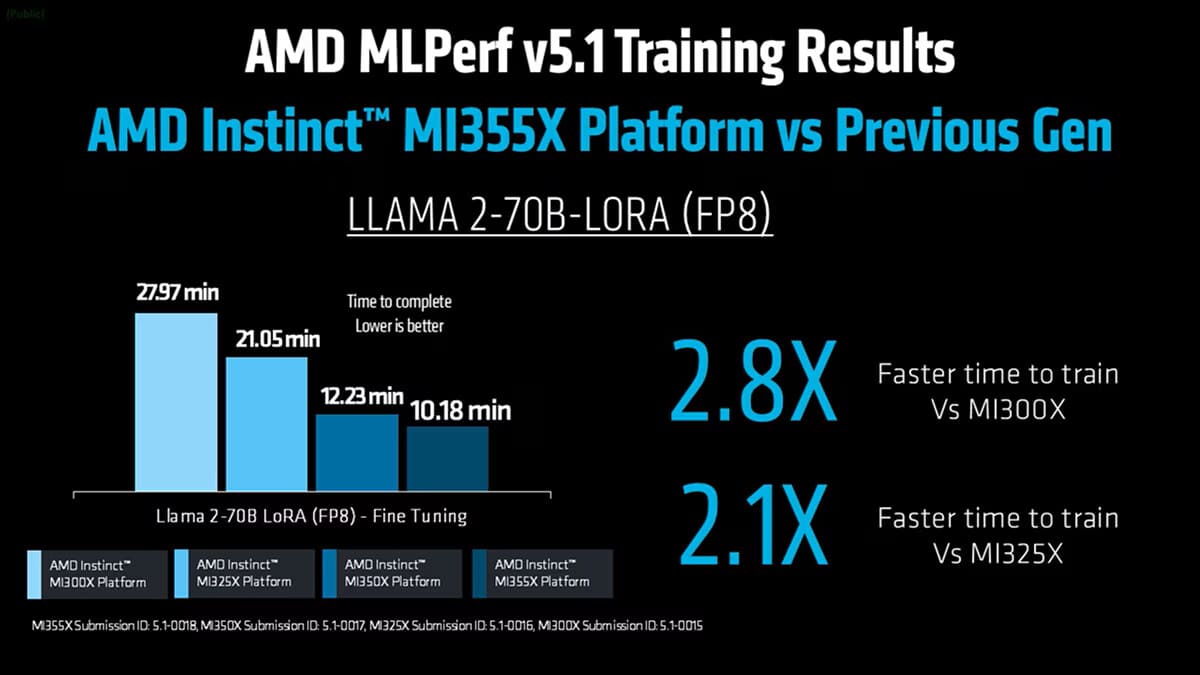

Hasta 2,8× más rápido que MI300X y mejoras claras en Llama 2-70B LoRA (FP8)

La Instinct MI350 Series —con las GPUs MI355X y MI350X— ofrece un avance notable en eficiencia y escalabilidad, alcanzando un rendimiento hasta 2,8× superior al de la MI300X y 2,1× por encima de la MI325X. En la prueba Llama 2-70B LoRA (FP8), la MI355X reduce el tiempo de entrenamiento de casi 28 minutos a poco más de 10 minutos, una aceleración muy notable en workloads donde la convergencia depende de ancho de banda sostenido y buena distribución de kernels.

Estas mejoras se apoyan en varios factores: ancho de banda HBM3E, optimizaciones del software ROCm 7.1, mejoras internas en kernel fusion, comunicación más eficiente en configuraciones distribuidas y ajustes profundos en primitivos GEMM. En conjunto, estos avances colocan a la MI355X como una opción competitiva para entrenamiento de modelos de gran tamaño y escenarios de fine-tuning con precisión FP8, el formato actualmente más adoptado por clientes de IA a gran escala.

Resultados competitivos frente a NVIDIA B200/B300 en workloads FP8 reales

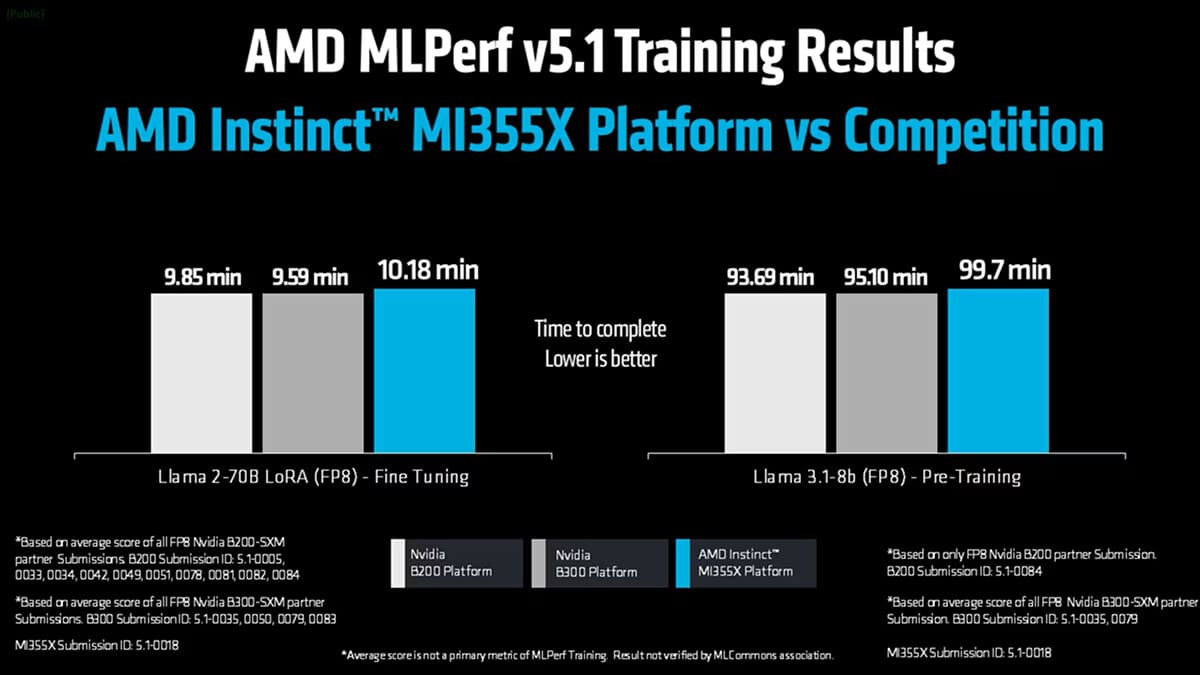

En la comparación con el promedio de sistemas basados en NVIDIA B200-SXM y B300-SXM (FP8), la MI355X completa el entrenamiento de Llama 2-70B LoRA en 10,18 minutos, una cifra cercana a los 9,85 y 9,59 minutos obtenidos por las plataformas equivalentes. En Llama 3.1-8B (FP8), la puntuación de 99,7 minutos queda dentro de un margen razonable frente a los valores agregados de 93,69 y 95,10 minutos de los sistemas NVIDIA.

Conviene destacar que NVIDIA no presentó resultados FP8 en esta ronda de MLPerf 5.1, optando por FP4, un formato que AMD considera aún no apto para cargas de entrenamiento debido a problemas de estabilidad numérica y necesidad de volver a FP8 durante la convergencia. Por ello, AMD se ha centrado en FP8 como formato equilibrado entre precisión y eficiencia para workloads de entrenamiento reales.

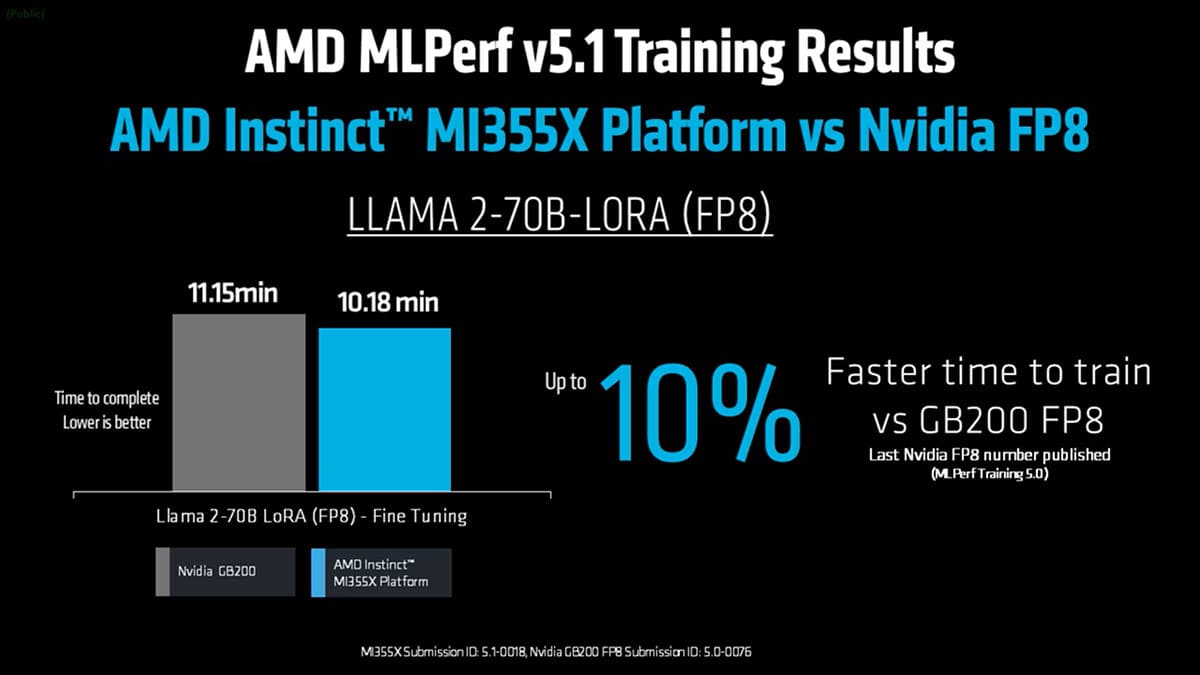

La comparación con resultados anteriores confirma el avance: en MLPerf 5.0, 8× GB200 lograban 11,15 minutos, mientras que la MI355X registra 10,18 minutos, una mejora cercana al 10% en FP8 frente al precedente de la competencia.

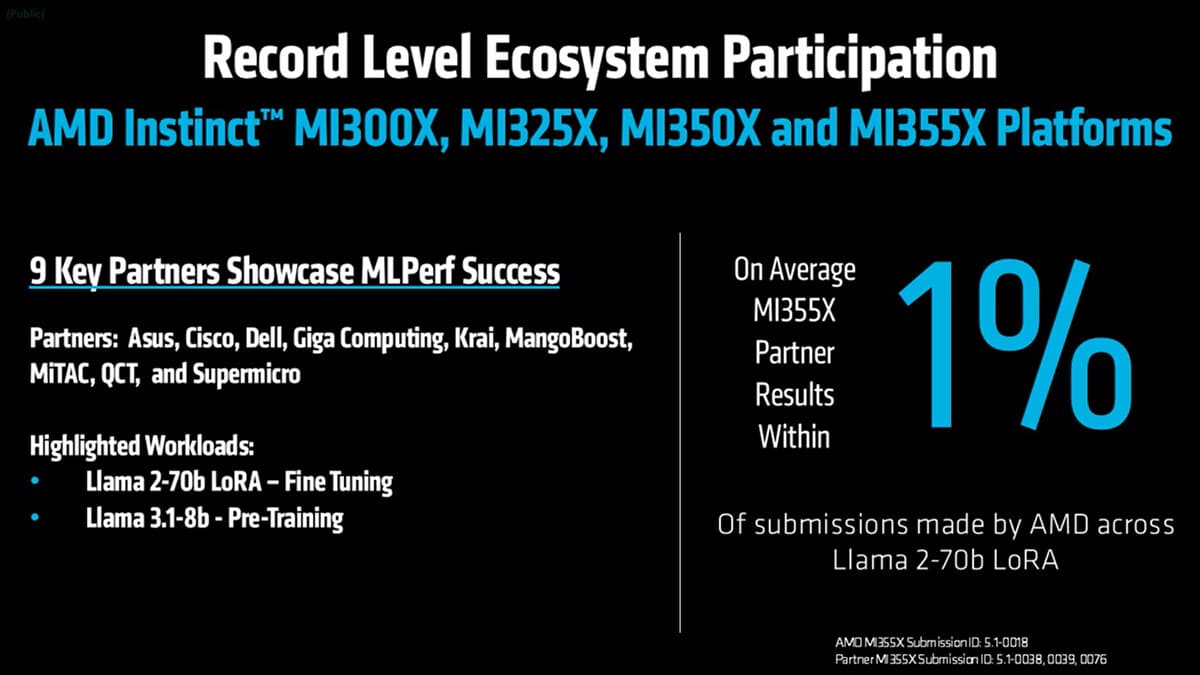

Participación récord del ecosistema y resultados consistentes entre socios

El ecosistema de AMD Instinct ha registrado su mayor participación hasta la fecha, con nueve socios —ASUS, Cisco, Dell, Giga Computing, Krai, MangoBoost, MiTAC, QCT y Supermicro— enviando resultados basados en hardware MI355X, MI350X, MI325X y MI300X. Todos los resultados en MI355X quedaron dentro del 1% de las cifras de AMD, lo que demuestra la consistencia de la plataforma y el grado de madurez del stack de software.

Estos entornos validan cargas intensivas como Llama 2-70B LoRA fine-tuning y Llama 3.1-8B pre-training, clave para escenarios reales de IA generativa. El caso de MangoBoost, con un análisis multi-nodo en MLPerf 5.1, confirma la escalabilidad en configuraciones distribuidas basadas en Instinct.

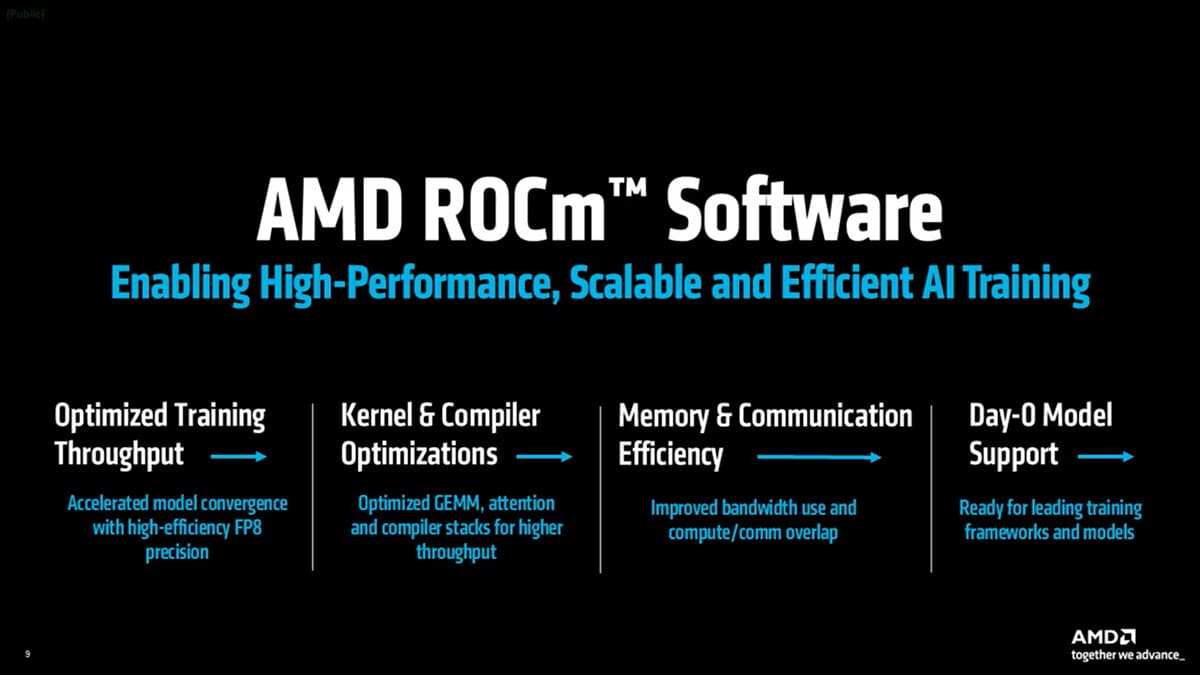

ROCm 7.1: mejoras en GEMM, fused attention y comunicación distribuidas

El software ROCm 7.1 es el motor de todos los resultados publicados. La versión introduce optimizaciones profundas en kernels, compiladores, XLA, TorchInductor, operaciones GEMM, fused attention, mejoras en planificación, comunicaciones superpuestas y soporte inmediato para modelos como Llama 3.1-8B, Mistral o SD-XL.

El incremento en eficiencia de memoria, la mejora en comunicación distribuida, y la optimización del flujo entre GPU, HBM3E y kernels FP8 permiten escalar desde una única GPU Instinct hasta configuraciones multi-nodo, manteniendo un rendimiento sostenido en cargas de IA generativa, donde la superposición de cómputo y comunicación, el ancho de banda efectivo, y la latencia inter-nodo son factores críticos para modelos de gran tamaño.

Un avance que refuerza la hoja de ruta anual de AMD Instinct

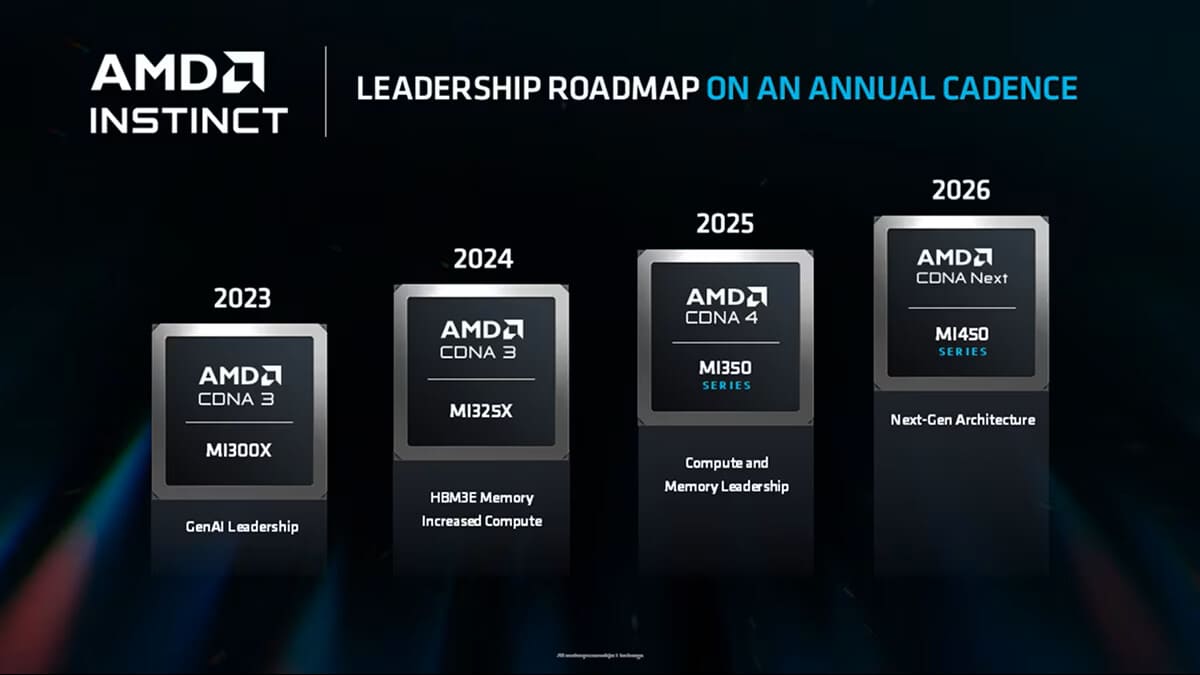

Los resultados de MLPerf 5.1 Training consolidan a la MI350 Series como un punto de inflexión en la estrategia anual de AMD, con una progresión clara desde la MI300X (2023), MI325X (2024) y ahora la MI350 Series (2025). La futura MI450 Series y la nueva arquitectura CDNA marcarán el siguiente paso hacia 2026.

Vía: TechPowerUp