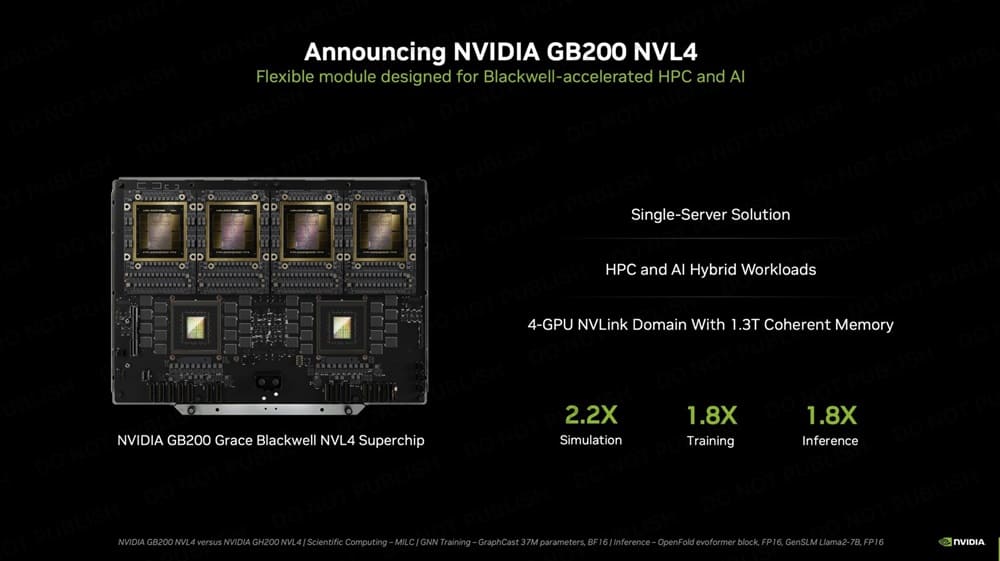

NVIDIA anunció en SC24 sus últimos aceleradores de IA de alta densidad computacional con el GB200 NVL4, una solución de servidor único que amplía la cartera de productos de la serie Blackwell de la compañía.

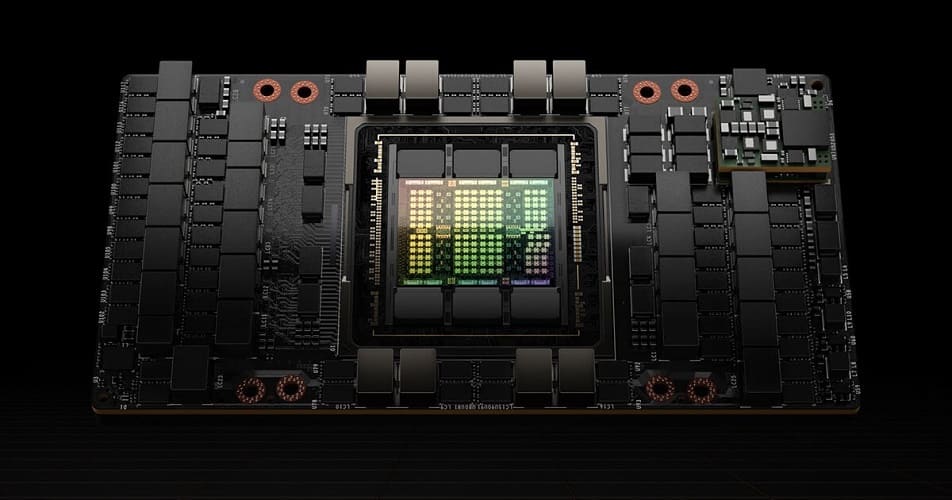

Esta nueva plataforma presenta una impactante fórmula que combina cuatro GPUs Blackwell y dos CPUs Grace en una única placa. Además, la GB200 NVL4 cuenta con unas espectaculares especificaciones para un sistema monoservidor, entre las que se incluyen 768 GB de memoria HBM3E en sus cuatro GPUs Blackwell, proporcionando un ancho de banda de memoria combinado de 32 TB/s.

Las dos CPUs Grace poseen 960 GB de memoria LPDDR5X, lo conforma una central neurálgica para las cargas de trabajo de inteligencia artificial más exigentes.

Una de las características más destacables del diseño de NVL4 radica en su tecnología de interconexión NVLink, que permite la comunicación entre todos los procesadores presentes en la placa. Dicha integración resulta fundamental para mantener un rendimiento óptimo en las múltiples unidades de procesamiento del sistema, sobre todo durante las grandes series de entrenamiento o la inferencia de un modelo con varios billones de parámetros.

Según NVIDIA, las GPUs GB200 proporcionan 2,2 veces más rendimiento global y 1,8 veces más capacidad de entrenamiento que su predecesora, la GH200 NVL4.

En cuanto al consumo energético, alcanza los 5400W, el doble de los 2700W que necesita el modelo GB200 NVL2, su hermano pequeño dotado de dos GPUs en lugar de cuatro.

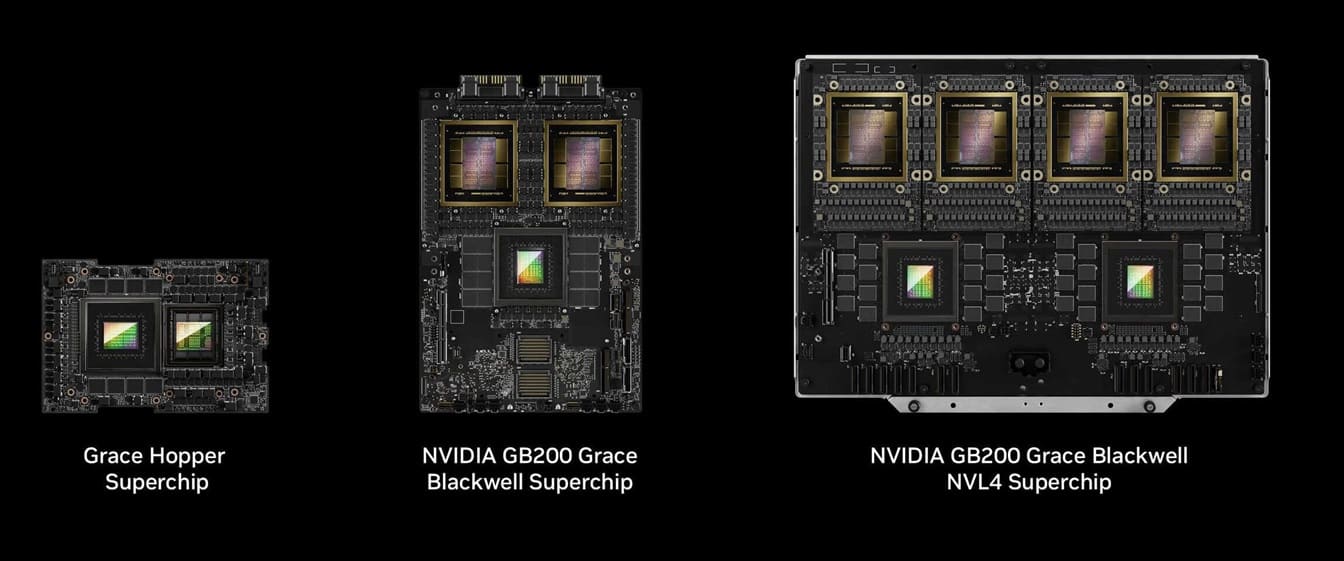

Gracias a su estrecha colaboración con los principales OEM del mercado, NVIDIA ha puesto en el mercado diversas soluciones Blackwell, entre las que se incluyen DGX B200, GB200 Grace Blackwell Superchip, GB200 Grace Blackwell NVL2, GB200 Grace Blackwell NVL4 y GB200 Grace Blackwell NVL72.

Para obtener un rendimiento óptimo, un servidor con un TDP de 5.400W requerirá de refrigeración líquida, y se espera que el GB200 NVL4 se instale en racks de servidores para clientes de hiperescaladores, que suelen disponer de sistemas de refrigeración líquida personalizados en sus centros de datos.

Vía: TechPowerUp