Microsoft Azure ha anunciado su nueva máquina virtual ND H100 v5, que combina los procesadores Sapphire Rapids Xeon Scalable de Intel con las GPUs Hopper H100 de NVIDIA, así como la interconexión Quantum-2 CX7 de NVIDIA.

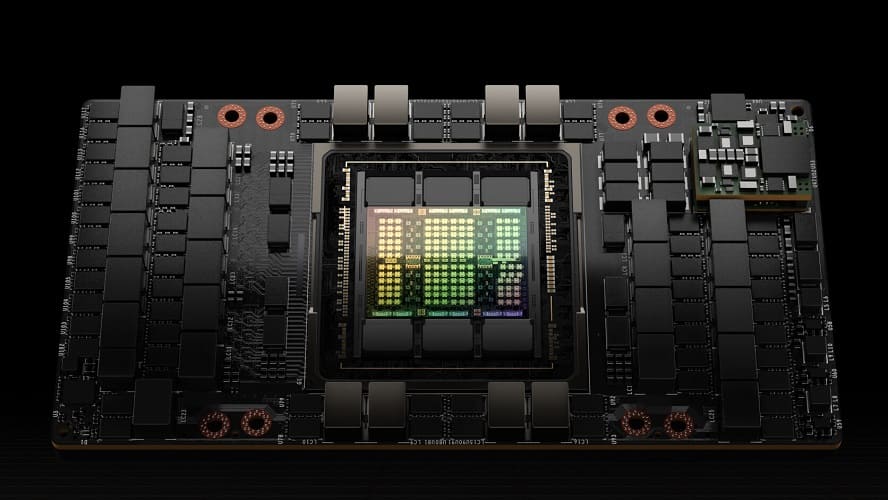

Cada máquina física contiene ocho H100 -presumiblemente la variante SXM5, con 132 SMs y 528 núcleos tensor de 4ª generación- interconectados por NVLink 4.0, que los une mediante un ancho de banda biseccional de 3,6 TB/s. Fuera de cada máquina local existe una red de miles de H100 adicionales conectadas entre sí con InfiniBand Quantum-2 CX7 a 400 GB/s, lo que, según Microsoft, permite 3,2 Tb/s por máquina virtual para el escalado bajo demanda con el fin de acelerar las mayores cargas de trabajo de capacitación de IA.

Las soluciones de IA generativa como ChatGPT han intensificado la demanda de servicios multi-ExaOP en la nube que puedan gestionar los grandes conjuntos de capacitación y utilizar las más recientes herramientas de desarrollo. Las nuevas máquinas virtuales ND H100 v5 de Azure ofrecen dicha capacidad a organizaciones de cualquier magnitud, tanto si se trata de una pequeña startup como de una gran multinacional que busca implementar despliegues de capacitación en IA a gran escala.

Si bien Microsoft no hace ninguna mención expresa sobre el rendimiento, NVIDIA ha afirmado que H100 funciona hasta 30 veces más rápido que la anterior arquitectura Ampere que se utiliza actualmente en las máquinas virtuales ND A100 v4.

- Microsoft Azure ha proporcionado las siguientes especificaciones técnicas para las nuevas máquinas virtuales:

- 8 GPUs NVIDIA H100 con núcleos tensor interconectadas a través de NVSwitch de última generación y NVLink 4.0.

- NVIDIA Quantum-2 CX7 InfiniBand a 400 Gb/s por cada GPU con 3,2 Tb/s por cada máquina virtual en una red fat-tree no bloqueable.

- NVSwitch y NVLink 4.0 con 3,6 TB/s de ancho de banda bidireccional entre las 8 GPUs locales de cada máquina virtual.

- Procesadores Intel Xeon Scalable de 4ª generación

- Interconexión de host a GPU PCIE Gen 5 con un ancho de banda de 64 GB/s por cada GPU

- 16 canales de módulos DIMM DDR5 a 4800 MHz

A juzgar por lo que se sabe de NVIDIA Hopper, es probable que Microsoft esté utilizando sus propios racks repletos de DGX H100, o bien el DGX SuperPOD de NVIDIA, que agrupa las DGX H100s en cinco alturas y hasta 16 a lo ancho para un total de 640 GPUs con 337.920 núcleos de tensor.

No olvidemos que cada DGX H100 también contiene dos procesadores Intel Xeon Scalable. Como Microsoft ya ha especificado que sus sistemas utilizan los últimos Xeon Sapphire Rapids de Intel, que pueden incorporar hasta 60 núcleos cada uno, existen potencialmente 9.600 núcleos x86 disponibles para impulsar esas enormes GPUs.

Microsoft Azure ha habilitado la vista preliminar de su servicio ND H100 v5 VM, pudiendo inscribirse para solicitar acceso desde el siguiente enlace.

Vía: TechPowerUp