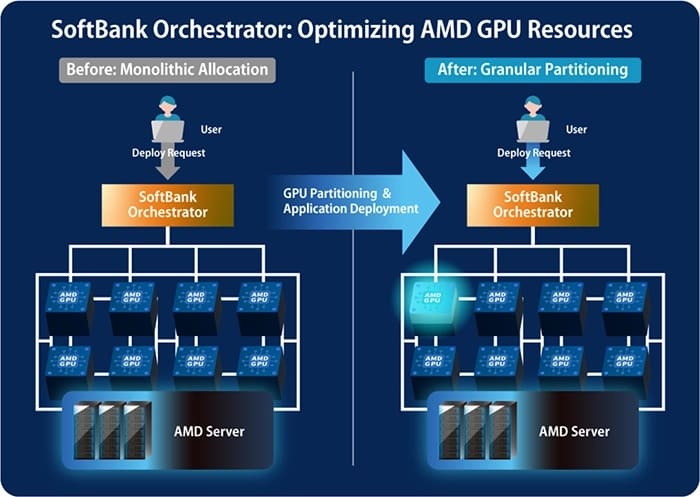

La infraestructura de IA sigue evolucionando más allá del silicio, y cada vez gana más peso el software de orquestación como elemento diferencial. En este contexto, SoftBank ha dado a conocer una iniciativa técnica orientada a maximizar el rendimiento de los chips AMD Instinct mediante un mecanismo avanzado de particionado de GPU, diseñado para adaptar los recursos de cómputo y memoria a las necesidades reales de cada carga de trabajo.

La propuesta llega en un momento en el que AMD busca reforzar su presencia en infraestructuras de IA frente al dominio de NVIDIA, apoyándose en clientes estratégicos que exploren enfoques alternativos en eficiencia y utilización del hardware.

Un orquestador propio para exprimir AMD Instinct

Según explica la propia SoftBank en su blog técnico, la compañía ha desarrollado un orquestador personalizado que trabaja directamente sobre las capacidades de particionado de las GPUs AMD Instinct. Este sistema permite que una sola GPU física funcione como múltiples dispositivos lógicos, ajustando dinámicamente los recursos en función del tamaño del modelo, la concurrencia y la intensidad del workload.

En palabras de la compañía, “el objetivo es lograr una asignación flexible y óptima de los recursos de GPU según los requisitos específicos de cada aplicación de IA”. Este enfoque busca evitar la infrautilización del hardware en escenarios donde los modelos no necesitan acceso exclusivo a una GPU completa.

Particionado por XCD y modos SPX y CPX

A nivel técnico, el orquestador de SoftBank se apoya en la arquitectura chiplet de las AMD Instinct, segmentando el cómputo a partir de los Accelerator Complex Die (XCD). En función del escenario, una GPU puede configurarse como una sola instancia (modo SPX) o dividirse en hasta ocho instancias independientes (modo CPX), aumentando progresivamente la granularidad del control.

Este esquema permite ejecutar múltiples cargas de trabajo aisladas sobre una misma GPU, algo especialmente útil en entornos donde conviven modelos pequeños (SLM) y modelos de mayor tamaño (MLM), con requisitos de recursos muy distintos.

Memoria HBM segmentada y aislamiento a nivel de hardware

El particionado no se limita al cómputo. El orquestador también divide la memoria HBM de alta capacidad de las GPUs AMD Instinct en regiones independientes, asignadas a cada instancia lógica. De este modo, SoftBank busca garantizar un aislamiento estricto a nivel de hardware, evitando interferencias entre cargas y picos de latencia impredecibles.

La compañía subraya que este control de bajo nivel es clave para ofrecer comportamientos más deterministas, un aspecto crítico en entornos de inferencia y servicios de IA en producción.

Sin cifras, pero con foco claro en eficiencia

Por ahora, SoftBank no ha compartido benchmarks ni cifras de rendimiento concretas, aunque sí afirma que el sistema permite una “asignación óptima de recursos”, especialmente efectiva en escenarios donde conviven múltiples modelos con diferentes demandas.

La compañía también ha adelantado que este tipo de orquestadores avanzados podría extenderse en el futuro a otros aceleradores de IA, aunque la implementación actual se encuentra limitada a AMD Instinct, fruto de la colaboración directa entre ambas compañías.

Software como arma estratégica en la IA

La iniciativa de SoftBank pone de relieve una tendencia cada vez más clara: en la carrera por la infraestructura de IA, el software de orquestación y el control fino del hardware pueden ser tan determinantes como el propio silicio. Para AMD, este tipo de desarrollos representa una vía para diferenciar su ecosistema, ofreciendo flexibilidad y eficiencia allí donde la fuerza bruta no siempre es la única respuesta.

Vía: Wccftech