El sector de semiconductores empieza a mirar más allá de la actual hoja de ruta de memorias HBM, y Samsung ya estaría dando pasos en esa dirección. Un informe publicado por ZDNet Corea apunta a que la división de Samsung Semiconductor está desarrollando nuevos diseños de HBM que podrían incorporar dies lógicos fabricados en nodos tan avanzados como 2 nm, una apuesta claramente orientada al futuro del sector de IA.

Aunque no se mencionan clientes concretos, las fuentes citadas indican que el equipo de desarrollo de HBM estaría trabajando en dies lógicos personalizados, adaptados a las necesidades específicas de cada producto. Este enfoque refuerza la idea de que la memoria de alto ancho de banda se está convirtiendo en un componente estratégico, no solo complementario, dentro de los aceleradores de IA de próxima generación.

HBM personalizada y salto a nodos de 2 nm

Según el artículo, el departamento de I+D de memorias estaría considerando procesos de fundición tan avanzados como 2 nm para estos futuros diseños. No se concreta si Samsung optaría por SF2 o SF2P, los nodos de 2 nm de su propia fundición, pero el mero hecho de que estén sobre la mesa refleja la ambición tecnológica del proyecto.

Esta estrategia permitiría a Samsung ajustar el encapsulado y el silicio de la lógica de HBM a cargas de trabajo muy concretas, algo especialmente relevante para aceleradores de IA de ultra alto rendimiento, donde la latencia, el ancho de banda y la eficiencia energética son críticos.

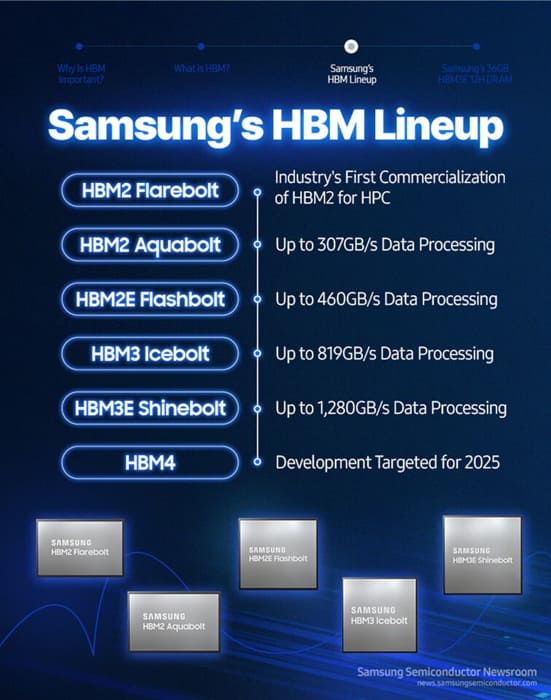

HBM4 como punto de partida, HBM4E como transición

En paralelo, la información señala que la sexta generación de HBM (HBM4) de Samsung estaría basada en un proceso de 4 nm, probablemente dentro de la familia SF4. Este nodo serviría como base tecnológica inmediata, mientras la compañía prepara el terreno para opciones más avanzadas.

Un responsable interno citado de forma anónima explica que Samsung está construyendo un portafolio que va desde 4 nm hasta 2 nm, con el objetivo de responder a las demandas de distintos clientes. Esta flexibilidad sería clave para competir en un mercado donde cada gran actor de IA busca soluciones a medida.

El informe añade que los dies lógicos a 2 nm no llegarían antes de la siguiente gran evolución del estándar, HBM4E (séptima generación), cuyo despliegue se situaría más allá de 2027. A partir de ese momento, se espera una demanda muy fuerte por parte del sector empresarial de IA, impulsada por nuevos aceleradores aún más exigentes.

La memoria como pieza central en la IA futura

Este movimiento encaja con una tendencia clara del mercado: la memoria HBM ya no es solo un acompañamiento del silicio de GPU o NPU, sino una pieza central del rendimiento global. A medida que los modelos crecen y el movimiento de datos se convierte en el principal cuello de botella, la integración entre lógica avanzada y memoria gana peso estratégico.

Si finalmente Samsung materializa HBM con dies lógicos a 2 nm, la compañía podría situarse en una posición muy competitiva frente a otros actores del sector de semiconductores, anticipándose a las necesidades de los aceleradores de IA de próxima generación. Por ahora, se trata de un proyecto en fase temprana, pero deja claro que la carrera por la HBM del futuro ya ha empezado.

Vía: TechPowerUp