Lexar ha presentado el AI Storage Core, un módulo de almacenamiento diseñado para la nueva generación de dispositivos con inteligencia artificial integrada, desde AI PCs hasta sistemas de conducción autónoma y robótica industrial. Su objetivo es resolver los cuellos de botella provocados por el aumento del tráfico de datos multimodales en tiempo real y la necesidad de ancho de banda elevado en entornos de inferencia local.

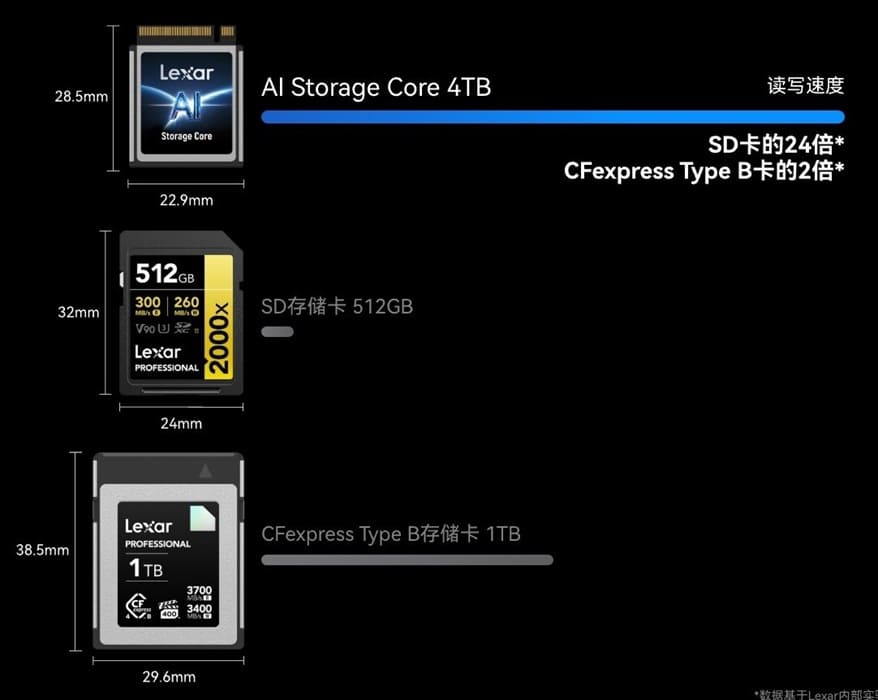

Según Gartner, los envíos de AI PCs alcanzarán los 143 millones de unidades en 2026, más de la mitad del mercado mundial. En ese contexto, el almacenamiento se ha convertido en un elemento crítico: los chips de IA procesan enormes volúmenes de información, pero la transferencia sigue dependiendo de medios demasiado lentos para estas cargas. Lexar busca romper esa limitación con un diseño de hasta 4 TB y rendimiento extremo compatible con arquitecturas PCIe NVMe.

Rendimiento optimizado para cargas de IA

El AI Storage Core logra velocidades secuenciales de lectura y escritura muy superiores a las de las tarjetas de memoria convencionales, optimizando bloques de 512 bytes y capas SLC Boost y Read Cache para acelerar la carga de modelos LLM, flujos de imágenes generativas y análisis locales. Estas mejoras reducen la latencia en tareas de entrenamiento e inferencia y permiten mantener un flujo constante de datos sin depender del cloud.

La gestión térmica ha sido uno de los pilares del diseño. El módulo mantiene rendimiento estable bajo cargas sostenidas, ofreciendo un comportamiento predecible en entornos edge o estaciones compactas dedicadas a IA. Esto lo convierte en un componente idóneo para AI PCs portátiles, donde la eficiencia térmica y el espacio interno son factores limitantes.

Fiabilidad industrial y resistencia ambiental

Construido con tecnología de encapsulado Longsys, el dispositivo es resistente al polvo, al agua, a impactos y a la radiación, características propias de soluciones industriales. Los próximos modelos ofrecerán rango térmico de −40 °C a 85 °C, orientados a vehículos autónomos y robótica de exterior. Esta robustez amplía su aplicabilidad más allá del consumo, acercándolo a sectores donde la continuidad operativa es esencial.

El AI Storage Core se perfila así como una pieza clave para plataformas embebidas que requieren alta fiabilidad sin sacrificar rendimiento. En ámbitos como la automatización industrial o los mini centros de datos edge, su combinación de velocidad, durabilidad y compacidad puede reducir costes y simplificar despliegues.

Diseño intercambiable y colaboración entre dispositivos

Uno de los rasgos más distintivos del módulo es su diseño hot-swappable, que permite extraer o insertar el almacenamiento sin apagar el sistema. Esta capacidad, unida al soporte de arranque PCIe, facilita trasladar un entorno de trabajo completo –sistema operativo, modelos y datos– entre distintos equipos sin pérdida de consistencia.

El módulo utiliza una solución térmica co-diseñada que mantiene las temperaturas bajo control incluso en sesiones prolongadas de inferencia. Su formato portátil refuerza la tendencia hacia plataformas modulares de IA, donde el usuario puede intercambiar fácilmente recursos de cómputo o almacenamiento según el tipo de proyecto.

Un paso adelante en almacenamiento inteligente

El avance del sector de IA está redefiniendo la arquitectura del hardware. El Lexar AI Storage Core demuestra que el almacenamiento puede actuar como acelerador directo de los modelos generativos, no solo como soporte pasivo. Con un equilibrio entre rendimiento, fiabilidad y flexibilidad, la marca propone una visión más integrada de la computación en el borde.

Si las previsiones del mercado se cumplen, soluciones como esta marcarán el estándar de los Copilot+ PCs y sistemas autónomos de próxima generación, donde la respuesta instantánea y la portabilidad del entorno de IA serán tan importantes como la potencia de cálculo.

Vía: TechPowerUp