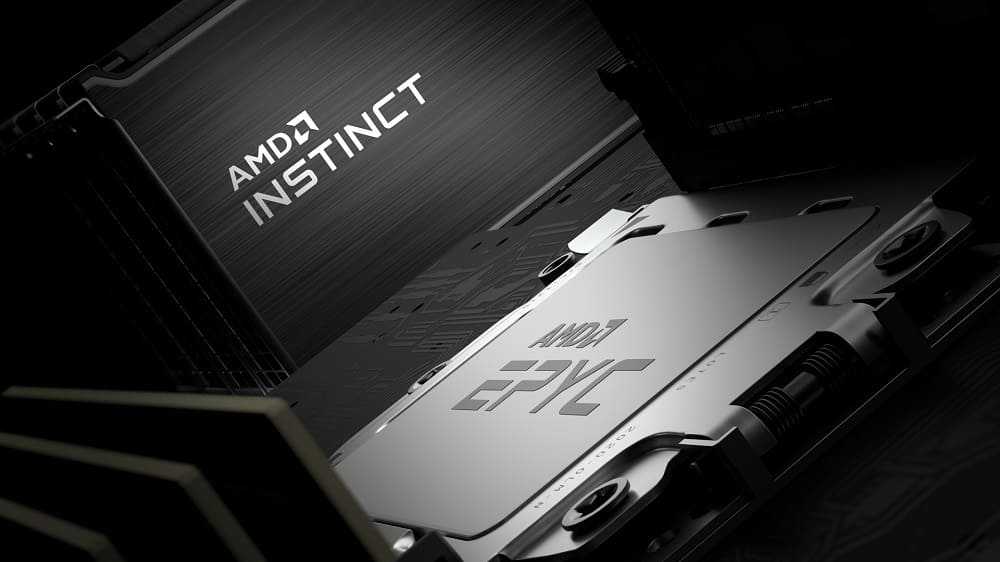

AMD ha anunciado el nuevo Instinct MI430X, un acelerador diseñado para cargas de HPC, IA generativa, modelos multimodales, entrenamiento distribuido, simulación científica y plataformas exascale, integrándose directamente en el supercomputador Discovery del Oak Ridge National Laboratory y en el sistema europeo Alice Recoque. Este despliegue inmediato confirma que el acelerador se convierte en el sucesor directo de la gama Instinct, combinando 432 GB de HBM4, 19,6 TB/s de ancho de banda, compatibilidad con los futuros AMD EPYC “Venice” y un enfoque centrado en infraestructura de IA soberana, centros con muy alta densidad de memoria y entornos donde la eficiencia energética y el rendimiento sostenido son tan críticos como la potencia bruta disponible.

HBM4 y ancho de banda extremo como motor para IA de billones de parámetros

El elemento central del Instinct MI430X es su enorme subsistema de memoria, compuesto por 432 GB de HBM4 capaces de entregar cerca de 19,6 TB/s, lo que convierte al acelerador en un dispositivo orientado a near-memory compute, crucial para modelos de billones de parámetros, arquitecturas transformer de gran profundidad, contextos ampliados, entrenamiento con ventanas largas y cargas donde mantener activaciones y tensores dentro de la GPU es fundamental. Estas cifras permiten reducir el habitual cuello de botella en cargas de IA generativa, eliminando la dependencia del tráfico intensivo por red y manteniendo gran parte del procesamiento dentro del propio acelerador.

El chip utiliza la arquitectura AMD CDNA, que conserva compatibilidad con operaciones científicas de FP64 y suma modos nativos FP8 y FP4, esenciales para optimizar el entrenamiento e inferencia de modelos modernos con esquemas de precisión mixta. Este enfoque permite que un mismo acelerador soporte simultáneamente simulación física, análisis estructural, dinámica molecular, modelos multimodales, IA agentic, pipelines generativos y operaciones científicas tradicionales, equilibrando cargas que requieren precisión máxima con otras que priorizan velocidad y capacidad de paralelización a gran escala. Todo ello viene acompañado de mejoras sustanciales en rendimiento por vatio, un requisito crítico para nodos exascale.

CDNA optimiza el movimiento de datos para IA avanzada y cargas científicas continuas

La arquitectura CDNA del MI430X reorganiza el flujo interno de datos para maximizar la utilización de la memoria HBM4, reducir la latencia entre bloques de cómputo y mejorar el manejo de tensores de gran tamaño, algo esencial en modelos generativos y en simulaciones que requieren múltiples iteraciones por ciclo. AMD ha rediseñado los motores de cálculo para combinar eficientemente FP64, FP32, BF16, FP8 y FP4, manteniendo rutas de precisión mixta optimizadas para cargas híbridas. El resultado es una arquitectura apta tanto para modelos multimodales, entornos de IA soberana, simulación científica avanzada, entrenamiento distribuido, análisis de datos masivo y operaciones de alto paralelismo, ofreciendo un equilibrio entre fiabilidad, rendimiento sostenido y eficiencia energética para instalaciones que operan durante meses sin interrupción.

Integración inmediata en sistemas de referencia globales

El hecho de que el Instinct MI430X debute directamente en sistemas de producción como Discovery y Alice Recoque subraya que AMD busca posicionar su arquitectura como una alternativa abierta frente a soluciones cerradas dominantes en el ecosistema de IA. Este movimiento permite a laboratorios nacionales, centros de investigación y organizaciones estratégicas implementar modelos propios, aprovechar configuraciones con muy alta densidad de memoria y desplegar infraestructura soberana con soporte a largo plazo. El acelerador se perfila como una pieza clave dentro de la estrategia de AMD para capturar cuota en la supercomputación de nueva generación, donde la combinación de HBM4, gran ancho de banda, modos de precisión variables y escalabilidad lo sitúan como un candidato sólido para proyectos científicos y de IA de nivel mundial.

Vía: TechPowerUp