SK hynix ha aprovechado el OCP Global Summit 2025, celebrado en San José (California) del 13 al 16 de octubre, para exhibir su visión de futuro en el campo de la memoria avanzada aplicada a inteligencia artificial y centros de datos. Bajo el lema “MEMORY, Powering AI and Tomorrow”, la compañía presentó su ecosistema completo de soluciones, incluyendo HBM4, AiM, DDR5 DRAM y eSSDs, consolidando su papel como proveedor integral de memoria para la era de la IA.

HBM4: mayor ancho de banda y eficiencia energética

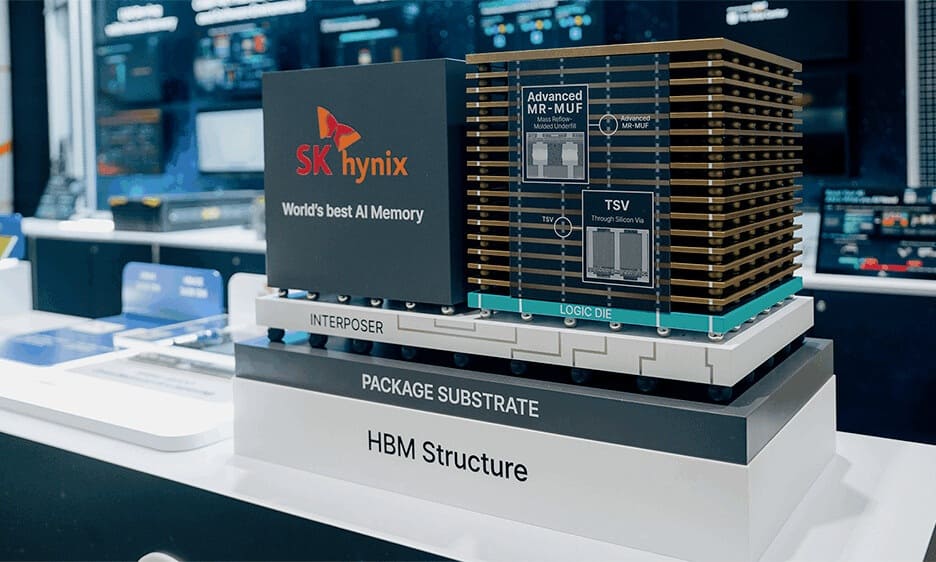

El punto central de su exposición fue la memoria HBM4, recientemente finalizada y lista para producción en masa. Este nuevo estándar incorpora 12 capas apiladas y 2.048 canales de E/S, duplicando la cifra de la generación anterior. Con ello logra más de un 40 % de mejora en eficiencia energética y un aumento significativo del ancho de banda, características clave para las cargas de trabajo de IA generativa y entrenamiento de modelos de gran escala.

Junto a ella, la marca mostró su HBM3E de 36 GB, actualmente la de mayor capacidad del mercado, utilizada por NVIDIA en sus GPU Grace Blackwell GB300. Los asistentes pudieron observar una maqueta 3D explicativa del proceso de empaquetado avanzado, con tecnologías TSV y MR-MUF, que permiten el apilamiento de múltiples capas con alta densidad y fiabilidad.

AiM y memoria optimizada para LLMs

En el área dedicada a AiM (Accelerator in Memory), SK hynix mostró en vivo su tarjeta AiMX, compuesta por varios chips GDDR6-AiM. La demostración utilizó cuatro tarjetas AiMX junto a dos GPUs NVIDIA H100, ejecutando el modelo Llama 3 de Meta sobre vLLM.

El sistema demostró cómo AiM acelera las operaciones de atención en modelos de lenguaje, mejora la utilización de la KV-cache y reduce la latencia en inferencias largas. Gracias a ello, múltiples usuarios pudieron interactuar simultáneamente con un chatbot sin pérdida de rendimiento.

Soluciones CXL, DRAM avanzada y almacenamiento eSSD

El fabricante también presentó soluciones basadas en CXL (Compute Express Link), que permiten la expansión flexible de la memoria del sistema y el uso compartido entre procesadores. Entre ellas destacó el CXL Memory Module-Accelerator (CMM-Ax), aplicado en la nube Petasus AI de SK Telecom, y un sistema de inferencia distribuida sin red mediante CXL pooled memory.

En la zona DRAM, la compañía exhibió módulos DDR5 RDIMM, MRDIMM y 3DS DDR5, fabricados con el nodo 1c (sexta generación del proceso de 10 nm), orientados al mercado de servidores de próxima generación.

Por último, el área eSSD mostró soluciones de almacenamiento para servidores y centros de datos, como las PS1010 E3.S, U.2 y PEB110 E1.S, basadas en NAND 4D de 176 y 238 capas, además del modelo PS1101 E3.L de 245 TB, construido con NAND QLC de 321 capas, actualmente el más denso de la industria.

Estrategia y visión de futuro

Durante las conferencias del evento, representantes de SK hynix explicaron su estrategia para convertir el almacenamiento y la memoria en componentes centrales de la infraestructura IA. Las presentaciones se centraron en soluciones de alta capacidad, bajo consumo y escalabilidad, capaces de sostener la próxima ola de modelos generativos y computación de datos masivos.

Con estas innovaciones, SK hynix refuerza su posición como uno de los actores clave del mercado de memoria avanzada, impulsando el desarrollo de infraestructuras de IA más eficientes y sostenibles.

Vía: TechPowerUp